Ein Jahr Jakoblog

13. April 2008 um 12:43 7 KommentareSeit einem Jahr gibt es nun dieses Weblog. Das sind: 212 213 Beiträge in 365 366 Tagen, 351 Kommentare (davon etwa ein Drittel eigene und knapp die Hälfte Trackback/Pingback). Die Beiträge sind im Mittel zwei Kilobyte lang, die Verteilung sieht lognormal aus (Powerlaw). Der Zugriffsstatistik mit StatPress nach zu urteilen gibt es zur Zeit fast 150 Besucher pro Tag und zwischen 400 und 500 Seitenaufrufe (ohne Crawler etc.). Die meisten Besucher kommen per Google auf einige Artikel, die bei entsprechenden Suchanfragen hoch gerankt werden – populär sind vor allem MBTI (im Moment Google Platz 12) und ASIN (Platz 7). Besonders erfreut es, dass ich anscheinend beim Googeln nach Jakob knapp vor Jakob Maria Mierscheid lande, der immerhin zu den kompetentesten Abgeordneten des Bundestags gehört!

Eine inhaltliche Rückschau der 213 Beiträge gibt es vielleicht ein andermal. Die am Häufigsten vergebenen Tags („Bibliothek“: 69, „Wikipedia“: 29, „Web 2.0“: 23) drücken es eigentlich schon aus, danach folgen „Tagging“ und „Semantic Web“ sowie „Politik“ und „Freie Inhalte“. Für das kommende Jahr habe ich mir vorgenommen, weniger im Blog und dafür mehr an der Dissertation zu schreiben. 😉

Wie leicht lässt sich die TV-Realität beeinflussen?

12. April 2008 um 00:51 4 KommentareTeilnehmer der Gruppe Hedonistische Internationale (HI) haben dem (eigentlich ganz netten) TV-Magazin Polylux einen Beitrag über einen angeblichen Speed-Konsumenten untergejubelt. In einer Presseerklärung kritisiert die HI:

Erschreckend, wie einfach es ist, selbst gewählte Inhalte in Massenmedien zu platzieren und so gesellschaftliche Wirklichkeit werden zu lassen. […] Zentrale Bereiche des Journalismus werden an unterbezahlte Praktikanten ausgelagert, denen es aufgrund prekärer Arbeitsverhältnisse und des daraus resultierenden Drucks schwer möglich ist, ausreichend Zeit und Ressourcen in ihre Arbeit zu investieren.

Eine Richtigstellung habe ich auf der Seite von Polylux/Polylog bisher nicht finden können (P.S: ah, hier wird der Schwarze Peter weitergeschoben, P.P.S: und inzwischen offen diskutiert), stattdessen haben sie das Video einfach entfernt und die Kopie bei YouTube löschen lassen. Schade, dass die Redakteure nicht die Courage haben, den Fehler einzugestehen und die Leser für so unmündig halten, dass sie sich nicht selber ein Bild machen können. Stattdessen bestreitet der Sprecher des RBB im Intellektuellen-Boulevard die Probleme:

Den Vorwurf, Fernsehredaktionen würden schlecht recherchieren, wies Kotsch von sich. Man müsse sich trotzdem in Zukunft darüber Gedanken machen, wie ein weiterer Vorfall dieser Art verhindert werden könne. Personelle Konsequenzen würde der Sender allerdings nicht ziehen; genügend Personal, um gründlich zu recherchieren, gebe es auch.

Passender wäre ein Hinweis auf Michael Born, an den Günter Jauch wohl eher ungern erinnert wird. Die Darstellung von Thomas Pritzl in seinem Buch „Der Fake-Faktor. Spurensuche im größten Betrugsfall des deutschen Fernsehens“ (kopäd, 2006, ISBN 3-938028-69-6) ist sicherlich aufschlussreicher als die berechtigte aber kurze Kritik der Hedonistischen Internationalen. Obgleich ich eine klammheimliche Freude an der Aktion nicht verhehlen kann, frage ich mich jedoch ein wenig, was das ganze Spaß soll – vor allem nachdem ich mir selber ein Bild machen konnte (dank Google Video). Die gefakten Speed-Konsumenten sind übertrieben, aber Hans-Christian Dany, der im Beitrag als Experte vorkommt, kennt sich schon aus. Sein Buch Speed. Eine Gesellschaft auf Droge vermittelt ein besseres Bild als jeder TV-Beitrag und wenn nicht das Sach- und Personenregister fehlen würde, könnte ich es als unterhaltsames Standardwerke empfehlen (unterhaltsam ist es trotzdem).

Was mich an der Aktion etwas stört: Wenn die Massenmedien so einfach zu „unterwandern“ sind, sollte dort statt irrelevanter Späße besser Aufklärung eingebracht werden. Die Themenliste der Initiative Nachrichtenaufklärung ist leider etwas eingeschlafen. Sehr zu empfehlen zu „Konstruktion von Realität mittels Medien“ ist übrigens der Vortrag Die Wahrheit und was wirklich passierte vom 24C3 (Video über Torrent oder hier). Das Bekennervideo der Hedonistischen Internationalen ist darüber hinaus ein durchaus lustiges Stück (Real?)satire.

Siehe auch die Beiträge zum Fake bei Tanith, bei Netzpolitik und etwas anderes zum Thema Gehirn-Doping bei Nature [via Koehntop].

Suchmaschinen-Vorträge auf der Inetbib 2008

11. April 2008 um 12:35 3 KommentareDas Panel zu Suchmaschinen auf der Inetbib 2008 war erfreulicherweise durchweg mit Experten besetzt: Der Vortrag von Stefan Keuchel (Pressesprecher von Google Deutschland) bestand ausschließlich aus einer werbenden Darstellung der populärsten Google-Produkte. Muß man alles mal gesehen haben, aber dann reicht es auch (s.a. Netbib-Weblog). Ebenfalls hauptsächlich um Google ging es im Vortrag über Prof. Hendrik Speck (FH Kaiserslautern) über die „Entwicklung des Suchmaschinenmarktes“. Die interessanten Vortragsfolien stehen unter CC-BY-SA zur Verfügung – der Link führt allerdings zur Zeit ins 404 – (s.a. Netbib-Weblog). Der Vortrag von Prof. Mario Fischer (FH Würzburg-Schweinfurt) über Suchmaschinen-Optimierung war sehr unterhaltsam, obgleich er hauptsächlich Binsenweisheiten enthielt (Webseite für die Crawler einfach zugänglich machen, relevante Suchworte verwenden, etc.). Interessant wäre mal ein ähnlicher Vortrag zur „OPAC-Optimierung“. Ob die Teilnehmer über die Beispiele vermurkster Kataloge, in denen Nutzer nicht das finden, was sie suchen, ebenfalls so lachen würden wie in Fischers Vortrag über Webseiten und Suchmaschinen?

Inetbib 2008, first German „2.0“ library conference

10. April 2008 um 16:06 2 KommentareParticipating at the Inetbib 2008 conference in Würzburg I am pleased to see that web 2.0 usage among German librarians finally has reached the critical mass. I’d guess that we are more or less 18 month behind the situation of the vital US „library 2.0“ scene. With Inetbib 2008 we finally have a larger general library conference with open wifi and participants blogging (technorati, google blogsearch), twittering, flickring and social-networking the event (or just reading email if the speaker bores ;-). I hope that soon no more library colleauge will think that „all this internet services“ are a waste of time but usefull tools to better recognize developements, ideas, and events – even outside the German biblio-blogosphere (for instance here). The next event will be BibCamp, a Library 2.0 BarCamp at March May 16th/17th in in Potsdam and Berlin.

Der Subito-Rahmenvertrag ist Murx

9. April 2008 um 15:58 8 KommentareDer bisherige Höhepunkt der INETBIB 2008 war – obgleich ich nur mit halbem Ohr mitgehört habe – der Vortrag „Spinn ich oder die anderen?“ – Das Gute am neuen Urheberrecht und das Häßliche am neuen Subito-Rahmenvertrag von Dr. Harald Müller (Bibliothek des Max-Planck-Instituts für ausländisches öffentliches Recht und Völkerrecht). Dabei zerpflückt er den Subito-Rahmenvertrag als – in meinen Worten – überflüssigen, fehlerhaften und schädlichen Murx (Herr Graf kann bei Bedarf sicher drastischere Worte liefern).

Ich komme mir bei guten Vorträgen von Juristen immer vor wie jemand, der sich ohne technischen Sachverstand einen technischen Vortrag anhört. Vielleicht ist das Verhältnis zwischen Bibliotheken und Jura ähnlich dem Verhältnis zwischen Bibliotheken und Technik: es mangelnd an Fachkompetenz. Den anschließenden Kommentaren und Fragen nach zu Urteilen ist ist ein Grund für den vermurxten Subito-Vertrag, dass Bibliotheken Angst haben und vor lieber irgendeine „Rechtssicherheit“ wollen, anstatt eine eigene Rechtsposition zu vertreten – und diese auch zu verteidigen. Aber auch beim Urhheberrecht gilt: Freiheit stirbt mit Sicherheit.

Übersicht webbasierter Literaturverwaltung

9. April 2008 um 15:28 8 KommentareP.S.: Unter http://literaturverwaltung.wordpress.com gibt es inzwischen ein von Bibliothekaren betriebenes Portal zum Theme Literaturverwaltungsprogramme.

Einen Überblick über „Webbasierte Literaturverwaltung“ gab Thomas Stöber von der UB Augsburg in seinem Vortrag zusammen mit Astrid Teichert auf der INETBIB 2008. Das Thema ist eigentlich nicht neu, aber nicht jeder hat die Zeit und Muße, sich selber mit RefWorks, citeulike, Connotea und BibSonomy im Vergleich zu EndNote und Citavi zu beschäftigen – außerdem sollte man das Firefox-Plugin Zotero kennen.

Auf der einen Seite stehen die traditionellen, „geschlossenen“ Systemen (EndNote, Citavi), bei denen ein Nutzer für sich alleine bibliographische Daten sammelt und verwaltet. „Halboffene“ Systeme (EndNote Web, RefWorks) bieten als Webanwendungen zusätzlich die Möglichkeit, Daten für andere Nutzer freizugeben. Bei „Offenen“ Systeme ist der Nutzerkreis prinzipiell offen und alle bibliographischen Daten werden miteinander geteilt.

Die offenen Literaturverwaltungs-Systeme bieten neue Kooperationsmöglichkeiten im Bereich Forschung und Lehre, Stöber zitierte Lambert Hellers Hinweis auf die Möglichkeit „Informeller Gemeinschaftsbibliographien„. Dabei lassen sich aus seiner Sicht drei wesentliche Anwendungszenarien unterscheiden:

(1) Freigabe des eigenen Datenpools mit Lesezugriff, z.B. Literaturlisten für Lehrveranstaltungen, Bibliographien, eigene Schriftenverzeichnisse etc. (RefWorks…)

(2) Geschlossene Arbeitsgruppen arbeiten gemeinsam an Bibliographien (EndNote Web, BibSonomy…)

(3) Gemeinsamer, offener Datenpool (BibSonomy…)

Für die weitere Entwicklung stellen sich angesichts der rasanten Entwicklungen im Bereich webbasierter Literaturverwaltung folgende Fragen:

(1) Ist die offene, gemeinschaftliche Arbeiten an Bibliographien ein realistisches Modell für eine offene Wissenschaft? Laura Cohen spricht schon begeistert von „Social Scholarship (wobei meiner Meinung nach dabei eher Blogs von Bedeutung sind, siehe blogs as scholarship von Georgia Harper und als Beispiel Research Blogging). Viele Wissenschaftler möchten jedoch vermutlich nur ungern ihre Literaturlisten offenlegen (was meiner Meinung nach nicht unbedingt für die Qualität ihrer Forschung spricht).

(2) Sind OpenSource-Anwendung aktuell und zukünftig eine echte Alternative zu kommerziellen Systemen? Thomas Stöber konnte diese Frage nicht bejahen – ich denke vor allem bei der Usability hat OpenSource regelmäßig Probleme.

(3) Wie entwickeln sich Bibliographie-Verwaltungssysteme weiter? Zur Zeit ist eine Konvergenz der Funktionen zu beobachten, so dass sich die verschiedenen Systeme im Kern immer weniger unterscheiden.

In der anschließenden Fragerunde meldeten sich vor Allem die „üblichen Verdächtigen“ (Till Kinstler, Lambert Heller, Patrick Danowski) zu Wort – ich war zu sehr mit der Formulierung dieses Beitrags beschäftigt und kann der Einführung nichts wesentliches hinzufügen. Mir fehlte nur etwas Zotero. Herr Stöber wies darauf hin, dass sich das Programm in erstaunlich kurzer Zeit zu einer vollwertigen Literaturverwaltung entwickelt hat. Dem in der Diskussion gebrachten Hinweis auf die Notwendigkeit von Werbung und Benutzerschulungen kann ich mich nur anschließen.

P.S.: Eine tabellarische Übersicht von Programmen zur Literaturverwaltung gibt beim Max Planck Institut für Biochemie.

Pseudo-URIs als Identifikatoren für Normdaten der Deutschen Nationalbibliothek

7. April 2008 um 03:31 7 KommentareDie Deutsche Nationalbibliothek (DNB) hat anscheinend Ende März eine neue Katalog-Oberfläche online gestellt – der alte OPAC ist auch noch verfügbar. Dabei sind unter Anderem die Normdaten (SWD, GKD, PND) teilweise besser integriert. Ich warte ja schon seit einiger Zeit darauf, dass endlich richtige URIs vergeben werden, so dass sich Normdaten global referenzieren lassen. Bei der aktuellen Lösung ist aber leider einiges schiefgelaufen.

Was ist eine URI?

Die Diskussion zum Thema URI/URN/URL auf Inetbib hat mal wieder gezeigt, dass es beim Thema Identifikatoren oft Missverständnisse gibt. Die international allgemeine Form globaler Identifikatoren ist der „Uniform Resource Identifier“ (URI) bzw. die Erweiterung „Internationalized Resource Identifier“ (IRI). Sie sind in RFC 3986 und RFC 3987 standardisiert. Die Vergabe von UR regelt RFC 4395. Verschiedene URI-Schemata (gekennzeichnet durch den Teil einer URI bis zum ersten Doppelpunkt) sind jeweils mit einem eigenen Standard registriert und definiert, zum Beispiel URNs durch RFC 2141.

Viele URI-Schemata legen Namensräume und eigene Regeln zur Struktur und Vergabe von Identifikatoren fest. So zum Beispiel RFC 3406 für URNs und RFC 3044 für den URN-Namensraum urn:issn zur Abbildung von ISSNs. Durch die Formulierung von ISSNs als URI können diese bereits etablierten aber nur begrenzt nutzbaren Identifikatoren auch global genutzt werden, beispielsweise im Rahmen des Semantic Web. Während die Zeichenfolge „0024-9319“ sehr unterschiedliches identifizieren kann, weist „urn:issn:0024-9319“ eindeutig auf die amerikanische Ausgabe des MAD-Magazins hin.

Um welche Identifikatoren geht es?

Zur Identifikation von Personen (PND), Begriffen (SWD) und Körperschaften (GKD) gibt es im deutschen Bibliothekssystem seit vielen Jahren etablierte Normdaten. Abgesehen von wenigen Ausnahmen fristen diese Normdaten bzw. ihre Identifikatoren jedoch eher ein Schattendasein. Andere Identifikatoren, wie beispielsweise die Nummern von OCLC und der Library of Congress werden dagegen auch zunehmend von den „global players“ im Netz verwendet (von Google und LibrayThing). Wenn sie endlich mit URIs versehen und frei veröffentlicht würden, könnten die deutschen Normdateien ebenfalls weitere Verbreitung finden – oder andernfalls an Bedeutung verlieren.

Was hat die DNB falsch gemacht?

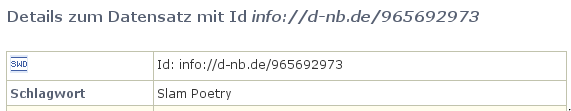

Anscheinend ist nun bei der Erstellung von Identifikatoren für Normdaten bei der Deutschen Nationalbibliothek gleich an mehreren Stellen etwas schief gelaufen. Dabei sieht es auf den ersten Blick ganz gut aus: Beim SWD-Eintrag „Poetry Slam“ ist beispielsweise dort als „Id“ die Zeichenkette „info://d-nb.de/965692973“ angegeben:

Ist das eine URI? Nein. In der offiziellen Liste von URI-Schemata ist „info:“ als gültiges URI-Schema eingetragen, das durch RFC 4452 definiert wird. Die dort festgelegte Maintenance Authority NISO hat die Verwaltung von Namensräumen an OCLC weitergegeben. Nun bekleckert sich OCLC mit dem seit Wochen nicht erreichbaren Verzeichnis der vergebenen Unternamensräume auch nicht gerade mit Ruhm, aber immerhin gibt es klare Standards (mehr Informationen bei der LOC). Eine info-URI ist aufgebaut nach dem Schema „info:NAMENSRAUM/LOKALTEIL„. Die Zeichenkette „info://d-nb.de/965692973“ kann also schon formal keine URI sein. Außerdem ist „d-nb.de“ nicht als gültiger info-URI Namensraum registriert. Zu allem Überfluss wird nicht auf die etablierten SWD-Nummern zurückgegriffen (die SWD-Nummer für den SWD-Datensatz ist „4709615-9“), sondern als lokaler Bestandteil die nicht standardisierte, systemabhängige PND-Nummer (hier: 965692973) verwendet!

Wie lässt sich der Schlamassel beheben?

Leider ist dies nicht das erste mal, dass sich die DNB im Internet lächerlich macht. Zum Glück lassen sich die Fehler relativ einfach beheben.

1. Die bereits existierenden „Standards“ für die existierenden Normdaten-Nummern werden explizit und verlässlich festgeschrieben, d.h. erlaubte Zeichen und Wertebereiche, Berechnung der Prüfziffer und Normalisierung (siehe LCCN-Normalisierung).

2. Die DNB reserviert für die Normdaten-Nummern einen URI-Namensraum (beispielsweise info:swd, info:pnd, info:gkd). Dabei sind die Regeln zur Syntax und Vergabe von URI-Schemata und Namensräumen einzuhalten. Internationale Standards sind zum Lesen und Einhalten da und nicht zum Ignorieren und Uminterpretieren.

3. Die URIs werden verständlich dokumentiert und propagiert. Die Kür wäre eine völlige Freigabe der Normdaten als öffentlicher Datenbank-Abzug unter einer freien Lizenz.

Zur Klärung der Konfusion bezüglich URI und URL sei auf die Artikel URIs, URLs, and URNs: Clarifications and Recommendations (via Kay Heiligenhaus) und On Linking Alternative Representations To Enable Discovery And Publishing hingewiesen.

P.S: Eine bibliotheksrelevante Anwendung von von Identifikatoren für Personen wurde letzte Woche von Arjan Hogenaar and Wilko Steinhoff im Vortrag Towards a Dutch Academic Information Domain auf der Open Repositories 2008 vorgestellt.

Aggregation von Metadaten aus Social Software-Diensten mit Aloe

3. April 2008 um 18:33 1 KommentarIm Vortrag „Sagt wer? Metadaten im Web“ auf der re:publica 08 sprach Martin Memmel darüber, „wie Daten von Experten, Maschinen und Endusern kombiniert“ werden können. Dabei stellte er das Projekt Aloe vor (link), in dem am DFKI Metadaten aus verschiedenen Quellen kombiniert und annotiert werden können. Alle Funktionen sind auch als Webservice verfügbar. Interessant sah die im Vortrag vorgestellte Tagging-Funktion aus, die Tag-Vorschläge aus mehreren Tagging-Diensten zusammenführt. Mehr dazu in den Vortragsfolien bei Slideshare.

Wirklich interessant werden solche aggregierenden Dienste meiner Meinung nach erst, sobald sich offene Standardformate zum Austausch von Kommentaren, Bewertungen, Tags etc. und anderen Metadaten durchsetzen. Bisher nicht bekannt in diesem Kontext war mir APML. Ein kritischer Punkt, der am Ende heftig diskutiert wurde, sind die Rechte an Metadaten und was juristisch und moralisch möglich und vertretbar ist. Ist es beispielsweise legitim, aus verschiedenen Social Networking-Plattformen soziale Graphen zusammenzuführen und weiterzugeben? Welche Rechte an Metadaten kann es überhaupt geben und welche lassen sich überhaupt durchsetzen? In jedem Fall spannend, wie es mit der Zusammenführung von Daten aus verschiedenen Diensten weitergeht.

Morgen nimmt Martin Memmel auch noch am Panel Social Media in der Wissenschaft teil, wo die „Möglichkeiten und Grenzen einer Wissenschaft 2.0“ diskutiert werden.

Review in Wikipedia mit markierten Versionen

2. April 2008 um 01:20 4 KommentareDie als „stabile Versionen“ diskutierte Erweiterung von Wikipedia um ein System zur Begutachtung nähert sich mühsam aber sicher ihrer Vollendung (siehe Ankündigung im Wikimedia-Deutschland-Blog und Beitrag von Tim). Zur Zeit kann die neue Funktion in einem Testwiki ausprobiert werden. Konstruktive Bugreports, Vandalismus-Tests und vor allem Hilfe bei der Verbesserung der Usability (!) sind gerne willkommen. Danach wird das System – möglichst noch diesen Monat – zunächst in der deutschsprachigen Wikipedia probeweise eingeschaltet. Und darum geht es:

Mit der neuen Funktion „markierte Versionen“ können einzelne Versionen eines Artikels markiert werden. Die Markierung als gesichtet zeigt an, dass kein Vandalismus vorhanden ist. Wenn zusätzlich jeweils zuerst die letzte gesichtete Version eines Artikels angezeigt wird, sollten offensichtlicher Blödsinn und Quatscheinträge in Wikipedia merklich abnehmen – allerdings ist es für Neuautoren möglicherweise abschreckend, wenn ihre Verbesserungen nicht sofort sichtbar sind.

Die Markierung als geprüft geht über eine gesichte Version hinaus: Sie stellt ein Qualitätsurteil eines fachkundigen Prüfers dar. Ein Prüfer gibt mit der Markierung als geprüft bekannt, dass die betreffende Artikelversion keine falschen Aussagen oder verfälschende Lücken enthält. Damit nähert sich Wikipedia dem traditionellen Review-System in den Wissenschaften an. Genauer gesagt handelt es sich um ein Offenes Peer-Review-Verfahren. Bisherige Peer-Review-Verfahren stoßen immer mehr an ihre Grenzen – zur Überwindung dieser Krise könnten Wikis helfen.

Was ich besonders bemerkenswert finde: Im Unterschied zu den bereits jetzt in Wikipedia vorhandenen Review-Verfahren (lesenswerte Artikel, exzellente Artikel) treten bei der Prüfung von einzelnen Artikelversionen nicht das Kollektiv der „Wikipedianer“ in Erscheinung, sondern einzelne Personen. Wenn jemand einen Artikel prüft, muss er mit seiner vollen Reputation dafür geradestehen, dass keine Fehler übersehen wurden. Bei Wikipedia-Autoren ist das in geringerem Maße zwar auch schon der Fall; für Außenstehende ist jedoch in der Regel undurchschaubar, was ein Autor zu einem konkreten Wikipedia-Artikel geleistet hat.

Ich befürchte nur, dass den meisten Lesern aufgrund fehlender Informationskompetenz sowieso egal ist, wer für welche Inhalte in Wikipedia verantwortlich ist (nämlich die konkreten Autoren und Prüfer und nicht ein anonymes Kollektiv oder ein Herausgeber!). Die meisten Menschen wollen nämlich beim Erwerb von „Wissen“ nicht selber denken, sondern einer Autorität vertrauen, die sagt, was richtig und was falsch ist. Das ist dann aber nicht das Problem der Wikipedia sondern ein Problem der Massenverdummung unserer Gesellschaft und ihren Teilnehmern, die lieber in selbstverschuldeter Unmündigkeit verharren, anstatt eigenes Urteilsvermögen zu gebrauchen.

Ich bin gespannt, wie sich die markierten Versionen in der Praxis entwickeln werden und wie sich die offen-anarchische Wikipedia-Community und das elitär-akademische Wissenschaftssystem weiter aufeinander zubewegen – im Guten wie im Schlechten.

re:publica 2008

1. April 2008 um 19:40 2 KommentareSo, ich fahr‘ dann auch ma‘ nach Berlin zur re:publica08. Dort treffen sich Blogger, andere Arbeitslose, Selbstdarsteller und/oder Weltverbesserer, um … dabei zu sein 😉

Nächste Woche geht es dann zur INETBIB’08 und im Monat d’rauf ist schon das erste BibCamp. Und dann ist ja auch schon bald wieder Weihnachten!

Neueste Kommentare