Diplomarbeit zu Web 2.0 und Verbundkatalogen

28. Januar 2009 um 12:43 1 KommentarBarbara Haubenwaller hat ihre Diplomarbeit Studiengang Informationstechnologien und IT-Marketing an der FH Graz zum Thema „Herausforderung Bibliothek 2.0 – Chancen und Risiken für Verbundkataloge durch die Anreicherung mit Web 2.0-Konzepten“ geschrieben und nun auf E-LIS veröffentlicht. Da der der Begriff „Web 2.0“ ein weites Feld ist, dass zu unstrukturiertem Blabla einläd, hatte ich zunächst die Befürchtung, ein oberflächliches Allerlei vorzufinden – diese Befürchtung wird durch die gut strukturierte und fundierte Arbeit mit einer einer aktuellen und sachlichen Bestandsaufnahme jedoch widerlegt. Behandelt werden folgende Fragen:

1. Welche Bibliotheksverbünde setzen Web 2.0-Konzepte bereits ein und in welcher Form?

2. Welche Web 2.0-Konzepte werden nicht eingesetzt und weshalb?

3. Welchen Mehrwert bringen Social Tagging, Blogging, Weblogs, RSS, Social Bookmarking und Ähnliches für den Leser? Werden diese überhaupt angenommen?

4. Welche Chancen und Risiken ergeben sich durch den Einsatz von Web 2.0-Konzepten für Bibliotheksverbünde und ihre Verbundkataloge?

BibSonomy mit neuer Oberfläche

16. Dezember 2008 um 03:19 4 KommentareSeit einigen Tagen (im Blog steht noch nichts?) zeigt sich die Social-Cataloging Plattform BibSonomy mit einer neuen Benutzeroberfläche. Die Schriftgröße ist leider noch immer Augenkrebs und ich kann mich plötzlich nicht mehr per OpenID Delegation anmelden, aber das wird sicherlich auch noch (vielleicht finde ich dann auch heraus, warum mein PhD-Literatur-Account nicht öffentlich einsehbar ist). Social Cataloging kam in der gestrigen Vorlesung zu Social Tagging und (gemeinschaftlicher) Erschließung etwas zu kurz, deshalb sei nochmal darauf hingewiesen, dass die derzeit innovativ aktivsten Dienste zur Verwaltung von bibliographischen Daten keine Bibliotheken sondern LibraryThing und BibSonomy sind. Bibliotheken können dagegen lediglich in Sachen Autorität und Dauerhaftigkeit punkten und werden sich hoffentlich einige Scheiben abschneiden. Ãœbrigens suchen sowohl die Verbundzentrale des GBV als auch das BibSonomy-Team studentische Mitarbeiter. Wer als Student im Raum Göttingen/Kassel wohnt und Webanwendungen o.Ä. programmieren kann, sollte sich mal überlegen, ob er/sie nur langweilige Ãœbungsaufgaben und Firmenanwendungen schreiben oder an der Zukunft der webbasierten Literaturverwaltung mitarbeiten möchte! 🙂

Neue Entwicklungen im GBV zur Öffnung der Kataloge

3. September 2008 um 15:44 3 KommentareIch weiß nicht genau was mit mir los ist, dass ich den Vortrag „Bibliographien für alle – Neue Entwicklungen zur Öffnung der Kataloge“ bereits eine Woche vor der GBV-Verbundkonferenz fertig habe – jedenfalls sind die Folien bei Slideshare. Wer sich also lieber Lambert anschauen möchte, wie er von „Erschließung 2013: Visionen und mögliche Entwicklungen“ spricht, muss nichts verpassen. 😉

Im Vortrag werde ich darüber sprechen, dass Bibliothekskataloge sowohl auf der Eingabeseite (Katalogisierung) als auch auf der Ausgabeseite (Präsentation und Export) offener werden müssen. An der Verbundzentrale des GBV werden dazu derzeit verschiedene Schnittstellen umgesetzt und dokumentiert. Die in Entwicklung befindlichen Schnittstellen zum Anlegen und Bearbeiten von Katalogeinträgen werden zunächst an einer eigenen Datenbank getestet, die den Namen „Perlis“ (für „Persönliche Listen“) trägt. Auf Perlis aufbauend können verschiedene Anwendungen wie Social Cataloging, Semesterapparate, vereinfachte Webkatalogisierung, automatische Katalogisierung etc. erstellt werden. Wer sich mit SOAP und PICA+ auskennt, könnte ab Herbst mit der anfangen, wer weniger selber entwickeln möchte, sondern mehr fertige Applikationen mit schönem Benutzerinterface benötigt, muss sich noch etwas länger gedulden.

P.S: Der aktuelle Stand der Entwicklung steht unter Collection Webservices (CWS) im GBV-Wiki.

Nature als Nationallizenz verfügbar

29. Mai 2008 um 17:14 2 KommentareNature, die neben „Science“ renommierteste wissenschaftliche Fachzeitschrift, ist ab sofort im Rahmen der Nationallizenzen in den Jahrgängen von 1869-2007 für alle „in Deutschland wissenschaftlich Tätige“ kostenfrei verfügbar und kann hier recherchiert werden. Welche weiteren Zeitschriften und Datenbanken ebenfalls als Nationallizenz verfügbar sind, ist unter www.nationallizenzen.de einsehbar. Nach und nach werden auch die gesamten Metadaten gesammelt – siehe dazu die Datenbanken, die bei der VZG aufgelistet werden. Der Zugang sollte in allen Bibliotheken möglich sein, die Nature als Nationallizenz ausgewählt haben. Um auch vom eigenen Arbeitsplatz zugreifen zu können, muss man sich theoretisch per Shibbolethals als Nutzer einer Bibliothek ausweisen. Praktisch funktioniert das aber bislang nur für Einzelnutzer, das heisst Personen, die keine Bibliotheken nutzen oder nur Bibliotheken, die noch kein Shibboleth zur Authentifizierung im Rahmen der DFN-Föderation unterstützen. Hier kann man sich anmelden.

Beim Blättern in den alten Ausgaben ist mir aufgefallen, dass sich der Stil und die Anforderungen an wissenschaftliche Fachartikel mit der Zeit doch schon etwas gewandelt haben. Die kurzen Artikel aus dem 19. Jahrhundert erinnern mich teilweise eher an heutige Weblog-Beiträge! 😉

Fortbildung Weblogs und RSS

9. Mai 2008 um 09:57 3 KommentareGestern habe ich im Zentrum für bibliothekarische Fortbildung in Niedersachsen mal wieder einen Workshop veranstaltet, diesmal ging es speziell um Weblogs und Feeds. Die Vortragsfolien sind bei Slideshare (zum Anschauen im Browser oder zum Herunterladen im OpenOffice-Format). Für die eigene Nachbereitung und alle, die nicht dabei waren, kann ich die Lehrreihe Lernen 2.0 empfehlen – zu Weblogs gibt es dort drei Lektionen: Lektion 1: Weblog erstellen, Lektion 2: Im Weblog schreiben und Lektion 3: RSS entdecken und verstehen. Ich hoffe, die Teilnehmer streuen ihr Wissen auch unter ihren Kollegen, denn leider ist der Umgang mit Weblogs in Bibliotheken noch immer nicht so alltäglich wie es sein sollte. Vor allem in der Führungsebene fehlt manchmal das Grundverständnis für die neuen Mediengattungen, wenn lieber ignoriert oder nachgeplappert statt selber ausprobiert wird.

Zum Thema „Feeds von Fachzeitschriften“ möchte ich noch nachtragen, dass über die Datenbank Online Contents (OLC) theoretisch unter allgemeinen Suchanfragen natürlich auch die neuesten Artikel einer bestimmten Zeitschrift per RSS-Feed abonniert werden können. Dazu ist zunächst die Zeitschrift ausfindig zu machen (in der Datenbank OLC-Journals oder in der OLC-Gesamtdatenbank, z.B. nach ISSN oder ZDB), dann unten Rechts „Alle Aufsätze“ auszuwählen und es erscheint ein Hinweis auf den Feed. Diese 2-3 automatisierbaren Schritte könnte ich mit einem einfachen Service zusammenführen, so dass man über SeeAlso bei gegebener ISSN oder ZDB-ID im Katalog direkt einen passenden Feeds mit den neuesten Artikeln dieser Zeitschrift anbieten könnte. Praktisch scheitert dieses Vorhaben jedoch mal wieder an der Fortschrittsbremse Urheberrecht, denn Online-Contents ist nicht frei zugänglich und somit funktionieren auch die Feeds nur bedingt.

BibSonomy und Kataloge verknüpfen mit dem Bibkey

25. April 2008 um 15:46 2 KommentareAnknüpfend an einen Workshop zum Thema „Social Tagging in Bibliotheken“ und an Gespräche auf der INETBIB 2008 gab es Ãœberlegungen, Bibliothekskataloge mit der webbasierten Literaturverwaltung BibSonomy zu verknüpfen (siehe auch die Diplomarbeit von Annett Kerschis auf die Patrick hingewiesen hat).

Zum einen sollen Nutzer Einträge aus dem Katalog direkt in BibSonomy abspeichern können (wie bereits der KUG und HEIDI anbieten) – der einfachste Weg dazu ist ein BibTeX-Export. Zum anderen soll per Webservice BibSonomy abgefragt werden, ob und mit welchen Tags dort bereits ein Titel von Nutzern gespeichert wurde. Ein grundsätzliches Problem dabei ist jedoch, erst einmal den Titel zu identifizieren, nach dem gesucht werden soll. Die dahinter liegende Aufgabenstellung ist ein klassisches (nicht nur) Bibliothekswissenschaftliches Forschungsfeld: Duplikaterkennung in bibliographischen Datenbanken. BibSonomy ist dabei auf eine ähnliche Lösung gekommen, wie sie teilweise in Katalogen angewandt wird: Aus verschiedenen Feldern (Titel, Autor, Jahr…) wird durch Normalisierung und mittels einer Hashfunktion eine Zeichenkette als Identifikator („Hashkey“) gebildet. Dubletten sollen dabei möglichst auf den gleiche Hashkey abgebildet werden. Der übergreifende Hashkey von BibSonomy heisst dort „Interhash“.

Ich bin momentan dabei, diesen Hashkey zu spezifizieren (Unter dem Namen „Bibkey Level 1“) und zu implementieren – der Bibkey kann hier ausprobiert werden. In diesem Beispiel wird der Titel über die ISBN aus den GBV-Verbundkatalog geholt und aus den Daten der Bibkey gebildet (serverseitig, Link „Go to record in GSO“). Mit dem Bibkey wird dann über eine weitere API von BibSonomy (die ich als „SeeAlso“-verpackt habe) abgefragt ob den Titel schon jemand in seiner Sammlung hat (clientseitig, Link „Available in BibSonomy“).

Wie alle Heuristiken funktionier der Bibkey in seiner jetzigen Form nicht in jedem Fall. In diesem Beispiel wird bei BibSonomy nichts gefunden, weil die meisten Nutzer „Albert-László Barabási“ Nicht richtig buchstabieren können. Auch verschiedene Auflagen kommen aufgrund unterschiedlicher Jahreszahl nicht zusammen. Es ist also noch genügend Forschungs- und Entwicklungsbedarf. Auch für den Einsatz von FRBR wird über Hashkeys nachgedacht, wie dieser Vortrag von Rosemie Callewaert auf der ELAG2008 zeigt.

Weitere Literatur zum Thema „Hashkeyverfahren zur Duplikaterkennung in bibliographischen Daten“ sammle ich dank hilfreicher Hinweise mit dem Tag „bibkey“ – falls jemand seine Bachelor/Master-Arbeit dazu machen möchte, helfe ich gerne! 🙂

Felix Klein über Riemann’sche Flächen in Katalogen

23. Januar 2008 um 11:43 6 KommentareIn einem Posting von letztem Jahr auf ol-tech wies Paul Rubin auf dieses Digitalisat (vollständiger Datensatz bei Archive.org) hin, mit dem die OCR ihre Schwierigkeiten haben dürfte: Abgesehen vom Titelblatt und Inhaltsverzeichnis ist das Vorlesungsskript „Riemann’sche Flächen 1“ (gehalten im Wintersemester 1891/92 in Göttingen) von Felix Klein handschriftlich verfasst! Der entsprechende Katalogeintrag im GBV ist dieser. Das Digitalisat stammt vom „zweiten Abdruck“ (1894), die erste Ausgabe (dieser Datensatz) ist von 1892. Einen unveränderte Nachdruck gab es 1906 (dieser Datensatz). 1986 erschien im Teubner-Verlag eine kommentierte Neuauflage (ISBN 3-211-95829-0), die im GBV-Katalog als Duplikat (hier und hier) verzeichnet ist. Wie aus dem Digitalisat bei Open Library und Internet Archive nicht ganz hervorgeht, gibt es auch den Zweiten Teil mit „Riemann’sche Flächen 2“ (siehe Datensatz) gehalten während des Sommer-Semesters 1892.

Abgesehen vom Inhalt finde das Beispiel schön, da es zwei Probleme und Herausforderungen illustriert. Duplikate und die Schwierigkeit sie automatisch zu erkennen (ein Algorithmus würde wahrscheinlich Teil 1 und Teil 2 zusammenschmeißen) sowie die fehlende semantische Verknüpfungen zwischen Datensätzen. Warum wird bei der Erstausgabe von Teil 1 nicht ein Verweis auf die folgenden Ausgaben, auf das Digitalisat und auf Teil 2 angezeigt? Je mehr ich mich mit dem Thema beschäftige, desto mehr komme ich zur Überzeugung, dass zu solch einer semantischen Tiefenerschließung alle Bibliothekare der Welt nicht ausreichen werden. Ein offener Ansatz wie beim Open Library Projekt, wo Katalogisate wie in Wikipedia von jedem gändert werden können, ist wahrscheinlich die einzige Möglichkeit, mit den Massen an Datensätzen und Verknüpfungsmöglichkeiten fertig zu werden.

P.S: Noch zwei amüsante Fundstücke: es gibt doch einen „Volltext“ und wie sich am Umschlag ablesen lässt wurde das zugrunde liegende Exemplar der Universität Berkeley zuletzt 1987 ausgeliehen worden, bevor es digitalisiert wurde.

Schnittstelle für Verfügbarkeitsdaten von Bibliotheksbeständen

21. Januar 2008 um 11:22 4 KommentareLetzen Dezember habe ich über Serviceorientierte Architektur geschrieben und bin unter Anderem auf den Heidelberger UB-Katalog eingegangen. Dabei ging es darum, wie Daten einzelner Exemplare von Bibliotheksbeständen – speziell Verfügbarkeitsdaten – über eine Schnittstelle abgefragt werden können. Bislang gibt es dafür keinen einfachen, einheitlichen Standards sondern höchstens verschiedende proprietäre Verfahren. Till hat mich zu Recht auf den Artikel „Beyond OPAC 2.0: Library Catalog as Versatile Discovery Platform“ hingewiesen, in dem die API-Architektur des Katalogs an der North Carolina State University vorgestellt wurde. Die Beispiele zeigen gut, was mit dem Buzzword „Serviceorientierte Architektu“ eigentlich gemeint ist, wie sowas in Bibliotheken umgesetzt werden kann und was für Vorteile der Einsatz von einfachen, webbasierten Schnittstellen bringt. Die als CatalogWS bezeichnete API ist – wie es sich gehört – offen dokumentiert. CatalogWS enthält einen Catalog Availability Web Service, der ausgehend von einer ISBN ermittelt, in welchen (Teil)bibliotheken ein Titel verfügbar oder ausgeliehen ist.

Bei Bedarf könnte ich mal versuchen, diese API für die GBV-Kataloge zu implementieren. Andererseits sollte man sich vielleicht erstmal Gedanken darüber machen, was es noch für Kandidaten für eine Verfügbarkeitsschnittstelle gibt und welche Daten über so eine Schnittstelle abfragbar sein sollten: Das NCIP-Protokoll scheint mir wie Z39.50 nicht wirklich zukunftsfähig zu sein. Janifer Gatenby macht in ihrem Vortrag „Bridging the gap between discovery and delivery“ (PPT) weitere durchdachte Vorschläge. Auf den Mailinglisten CODE4LIB und PERL4LIB habe ich letzte Woche herumposaunt, wie wichtig eine Holding-API wäre und dass das doch alles eigentlich ganz einfach sei. Neben Iinteressanten Bemerkungen zu FRBR bin ich daraufhin auf Holding-data in Z39.50 hingewiesen worden. In den PICA-LBS-Systemen stehen die Verfügbarkeitsdaten soweit ich es herausgefunden, habe im Feld 201@, aber nur teilweise. Für die weitere Umsetzung wäre es wahrscheinlich sinnvoll, erstmal alle in der Praxis vorkommenden Verfügbarkeits-Stati (ausleihbar, Präsenzbestand, Kurzausleihe, ausgeliehen, unbekannt…) zu ermitteln. Für elektronische Publikationen sollte die Schnittstelle außerdem irgendwie mit existierenden Linkresolvern zusammenarbeiten können. Eine einfache Schnittstelle für Verfügbarkeitsdaten von Bibliotheken ist also nicht ganz trivial, aber solange nicht jeder Spezialfall berücksichtigt wird oder erstmal ein Gremium eingesetzt werden muss, dürfte es machbar sein. Hat sonst noch jemand Interesse?

thingISBN is getting better – so does SeeAlso

17. Januar 2008 um 00:05 Keine KommentareTim Spalding points out that thingISBN is getting better [via FRBR blog] – a good reason to update the thingISBN data of our SeeAlso Linkserver isbn2librarything. It now includes 2994299 ISBNs, that’s almost 12 times the size of the isbn2wikipedia linkserver. But what’s a linkserver? A linkserver is a server that gets an identifier (for instance an ISBN) and gives you links (for instance a link to a work at LibraryThing). You can try out some SeeAlso linkservers at a demo page or start to implement your own.

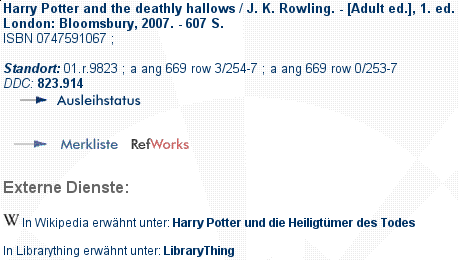

To get an impression, look in GBV union catalog, for instance this record: after a short moment, a link to German Wikipedia is included. More and more German libraries follow to include such additional links in their catalog. The Catalog of University Bremen includes both links to (German) Wikipedia and links to LibraryThing (you have to click at „weitere Informationen…“ at a selected record):

There is also an experimental ISBN2WorldCat linkserver. But linkservers that only send one or zero links are not very effective. I could combine multiple service to something like ISBN2SocialCataloging or such. Any suggestions for other services that libraries might not be frightened to link to? I’d also like to include more data in the link to LibraryThing (for instance the number of reviews) but unless German libraries wake up to ask for LibraryThing for Libraries I better not reimplement services that LibraryThing already offers.

The linkserver model could also be used to provide links to library holding and thus implement a FRBR-Manifestation to FRBR-Item mapping. As I just wrote at CODE4LIB and PER4LIB, a simple data format for holding information is needed to do so.

First Draft of SeeAlso Simple linkserver API

14. Januar 2008 um 23:45 2 KommentareI finally finished the first draft of the SeeAlso Simple Specification  . The webservice API for simple linkservers is based on OpenSearch Suggestions. It will be completed by the „SeeAlso Full Specification“ which adds unAPI and OpenSearch Description documents. The service is already implemented and running at the Union Catalog of GBV, see my earlier posting or simply have a look at this example. The same service is installed for testing at the Wikimedia Toolserver. For Wikipedia I drafted a different client that can be tested via a Bookmarklet: Drag the Link „ISBN2W“ to you bookmark toolbar, visit an English or German Wikipedia article with ISBNs on it, click the Bookmarklet link in your toolbar and hover the the ISBNs (that will become yellow) with the mouse. German Wikipedia users can also enable the service by adding a line of JavaScript to their user profile.

. The webservice API for simple linkservers is based on OpenSearch Suggestions. It will be completed by the „SeeAlso Full Specification“ which adds unAPI and OpenSearch Description documents. The service is already implemented and running at the Union Catalog of GBV, see my earlier posting or simply have a look at this example. The same service is installed for testing at the Wikimedia Toolserver. For Wikipedia I drafted a different client that can be tested via a Bookmarklet: Drag the Link „ISBN2W“ to you bookmark toolbar, visit an English or German Wikipedia article with ISBNs on it, click the Bookmarklet link in your toolbar and hover the the ISBNs (that will become yellow) with the mouse. German Wikipedia users can also enable the service by adding a line of JavaScript to their user profile.

An implementation (SeeAlso Simple and SeeAlso Full) in Perl is available at CPAN (there was neither unAPI nor OpenSearch Suggestions, so I implemented both). Please note that ISBN to Wikipedia is only one example how the API can be used. In my opinion the concept of a linkserver is highly undervalued but will become more important again (for instance as a lightweigth alternative to simple SPARQL queries). Feedback and usage is welcome!

Neueste Kommentare