Verordnung zur Pflichtablieferung von Netzpublikationen in Kraft

23. Oktober 2008 um 11:21 8 KommentareWie Heise berichtet, tritt heute die Verordnung zur Pflichtablieferung von Netzpublikationen (PDF) der Deutschen Nationalbibliothek (DNB) in Kraft – mehr dazu auf der Seite zu Netzpublikationen und auf Bibliotheksrecht. Der heise-Beitrag zeigt gut einige Schwierigkeiten auf, die die Verordnung mit sich bringt. Kurz gesagt macht das gesamte Verfahren eher den Eindruck, als hätte die DNB noch immer nicht verstanden, dass Netzpublikationen keine eins-zu-eins-Abbildung von Papiermedien sind. Das von der DNB präferierte Ablieferungsformat PDF stellt im Netz eher die Ausnahme dar und ist sowieso schlechte Praxis.

Der größte Knackpunkt ist allerdings der Ansatz, dass Dateien bei der DNB abgeliefert werden sollen, statt dass sie diese selber einsammelt. Die vom Internet Archive und anderen Nationalbibliotheken genutze Crawler-Software Heritrix ist frei verfügbar – vielleicht kann Gordon Mohr mit seinem Vortrag „Build Your Own Web Archive“ helfen. Crawling ist seit 1994 Praxis und mit OAI-PMH, Sitemaps, und Feeds gibt es inzwischen gängige Verfahren, um Daten und Metadaten auch besser strukturiert zum Abholen bereitzustellen.

Die jetzt zur Pflicht erkorene Praxis der Ablieferung von „Netzpublikationen“ macht den Eindruck, als sei die DNB gar nicht daran interessiert, die zur Zeit im Netz entstehenden kulturellen Werke zu sammeln und zu bewahren. Stattdessen hat sie mit der Verordnung nun ein Druckmittel in der Hand, um von Verlagen ausgewählte Publikationen geliefert zu bekommen. Das ist zwar legitim und besser als nichts – aber wenn man sich im Gegenzug anguckt, wie restriktiv die DNB auf ihren eigenen Daten sitzt, müffelt das schon etwas. Dazu ein schönes Zitat von Tim Spalding in NGC4LIB:

So, it’s not just Amazon, but now Google serving up high-quality book metadata to the world—data that libraries refuse to provide, except to each other and in antiquated formats. Another step down the long path to irrelevance.

Nach all dem Gemecker jetzt noch ein konstruktiver Vorschlag: Google propagiert den sitemaps-Standard, mit dem Betreiber von Webseiten angeben können, welche Teile ihrer Webseite von Crawlern durchsucht werden sollen. Die URLs einer sitemaps.xml-Datei können von Heritrix gecrawlt werden und werden in einer ARC-Datei abgelegt. Diese Datei kann als ZIP gepackt und bei der DNB abgeliefert werden. Wenn die DNB dieses Verfahren als Dienst anbietet, wo man zur „Pflichtablieferung von Netzpublikationen“ nur noch die URL der sitemaps-Datei angeben muss, sollte es mit dem Einsammeln von Netzpublikationen besser funktionieren.

Konkurrenz zu Normdaten mit dem Scopus Affiliation Identifier

30. April 2008 um 09:34 2 KommentareWie medinfo berichtet (Details dort) hat Scopus nach dem Author identifier nun den Scopus Affiliation Identifier eingeführt. Damit baut Scopus praktisch eine eigene Normdatei für Körperschaftenh auf. In Deutschland ist dafür bislang die Gemeinsame Körperschaftsdatei (GKD) verbreitet, weitere Systeme existieren in anderen Ländern.

Ich sehe die Entwicklung von Normdaten ähnlich wie Patrick Danowski, der in seiten Vorträgen (The future importance of bibliographic data Sharing and control in Web 2.0, Sharing and control) auf die Bedeutung von freien Normdaten hingewiesen hat: Wenn Bibliotheken nicht endlich ihre Normdaten aktiv und kompetent für die Nutzung im Web anbieten, machen es andere und die bibliothekarischen Normdaten versinken in der Bedeutungslosigkeit. Das Zeitfenster, in dem andere Akteure dazu gebracht werden können, die bibliothekarischen Normdaten weiterzunutzen, schließt sich langsam – wenn es zu spät ist, werden Bibliotheken den anderen herlaufen müssen anstatt umgekehrt. Das Potential für Bibliotheken, sich als relevanter Bestandteil des (Semantic) Web zu positionieren ist mit den bestehenden Normdaten da. Leider aber ist die Situation zu oft – wie beispielsweise neulich an der DNB – so, dass eine gute Idee in ihrer (technischen und organisatorischen) Umsetzung dem Stand der Entwicklung hinterherhinkt und langsam so sehr verkrustet, dass es irgendwann eben andere besser machen – und Bibliotheken damit stückweise überflüssig werden. 🙁

Pseudo-URIs als Identifikatoren für Normdaten der Deutschen Nationalbibliothek

7. April 2008 um 03:31 7 KommentareDie Deutsche Nationalbibliothek (DNB) hat anscheinend Ende März eine neue Katalog-Oberfläche online gestellt – der alte OPAC ist auch noch verfügbar. Dabei sind unter Anderem die Normdaten (SWD, GKD, PND) teilweise besser integriert. Ich warte ja schon seit einiger Zeit darauf, dass endlich richtige URIs vergeben werden, so dass sich Normdaten global referenzieren lassen. Bei der aktuellen Lösung ist aber leider einiges schiefgelaufen.

Was ist eine URI?

Die Diskussion zum Thema URI/URN/URL auf Inetbib hat mal wieder gezeigt, dass es beim Thema Identifikatoren oft Missverständnisse gibt. Die international allgemeine Form globaler Identifikatoren ist der „Uniform Resource Identifier“ (URI) bzw. die Erweiterung „Internationalized Resource Identifier“ (IRI). Sie sind in RFC 3986 und RFC 3987 standardisiert. Die Vergabe von UR regelt RFC 4395. Verschiedene URI-Schemata (gekennzeichnet durch den Teil einer URI bis zum ersten Doppelpunkt) sind jeweils mit einem eigenen Standard registriert und definiert, zum Beispiel URNs durch RFC 2141.

Viele URI-Schemata legen Namensräume und eigene Regeln zur Struktur und Vergabe von Identifikatoren fest. So zum Beispiel RFC 3406 für URNs und RFC 3044 für den URN-Namensraum urn:issn zur Abbildung von ISSNs. Durch die Formulierung von ISSNs als URI können diese bereits etablierten aber nur begrenzt nutzbaren Identifikatoren auch global genutzt werden, beispielsweise im Rahmen des Semantic Web. Während die Zeichenfolge „0024-9319“ sehr unterschiedliches identifizieren kann, weist „urn:issn:0024-9319“ eindeutig auf die amerikanische Ausgabe des MAD-Magazins hin.

Um welche Identifikatoren geht es?

Zur Identifikation von Personen (PND), Begriffen (SWD) und Körperschaften (GKD) gibt es im deutschen Bibliothekssystem seit vielen Jahren etablierte Normdaten. Abgesehen von wenigen Ausnahmen fristen diese Normdaten bzw. ihre Identifikatoren jedoch eher ein Schattendasein. Andere Identifikatoren, wie beispielsweise die Nummern von OCLC und der Library of Congress werden dagegen auch zunehmend von den „global players“ im Netz verwendet (von Google und LibrayThing). Wenn sie endlich mit URIs versehen und frei veröffentlicht würden, könnten die deutschen Normdateien ebenfalls weitere Verbreitung finden – oder andernfalls an Bedeutung verlieren.

Was hat die DNB falsch gemacht?

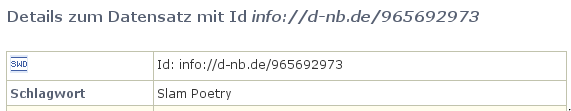

Anscheinend ist nun bei der Erstellung von Identifikatoren für Normdaten bei der Deutschen Nationalbibliothek gleich an mehreren Stellen etwas schief gelaufen. Dabei sieht es auf den ersten Blick ganz gut aus: Beim SWD-Eintrag „Poetry Slam“ ist beispielsweise dort als „Id“ die Zeichenkette „info://d-nb.de/965692973“ angegeben:

Ist das eine URI? Nein. In der offiziellen Liste von URI-Schemata ist „info:“ als gültiges URI-Schema eingetragen, das durch RFC 4452 definiert wird. Die dort festgelegte Maintenance Authority NISO hat die Verwaltung von Namensräumen an OCLC weitergegeben. Nun bekleckert sich OCLC mit dem seit Wochen nicht erreichbaren Verzeichnis der vergebenen Unternamensräume auch nicht gerade mit Ruhm, aber immerhin gibt es klare Standards (mehr Informationen bei der LOC). Eine info-URI ist aufgebaut nach dem Schema „info:NAMENSRAUM/LOKALTEIL„. Die Zeichenkette „info://d-nb.de/965692973“ kann also schon formal keine URI sein. Außerdem ist „d-nb.de“ nicht als gültiger info-URI Namensraum registriert. Zu allem Ãœberfluss wird nicht auf die etablierten SWD-Nummern zurückgegriffen (die SWD-Nummer für den SWD-Datensatz ist „4709615-9“), sondern als lokaler Bestandteil die nicht standardisierte, systemabhängige PND-Nummer (hier: 965692973) verwendet!

Wie lässt sich der Schlamassel beheben?

Leider ist dies nicht das erste mal, dass sich die DNB im Internet lächerlich macht. Zum Glück lassen sich die Fehler relativ einfach beheben.

1. Die bereits existierenden „Standards“ für die existierenden Normdaten-Nummern werden explizit und verlässlich festgeschrieben, d.h. erlaubte Zeichen und Wertebereiche, Berechnung der Prüfziffer und Normalisierung (siehe LCCN-Normalisierung).

2. Die DNB reserviert für die Normdaten-Nummern einen URI-Namensraum (beispielsweise info:swd, info:pnd, info:gkd). Dabei sind die Regeln zur Syntax und Vergabe von URI-Schemata und Namensräumen einzuhalten. Internationale Standards sind zum Lesen und Einhalten da und nicht zum Ignorieren und Uminterpretieren.

3. Die URIs werden verständlich dokumentiert und propagiert. Die Kür wäre eine völlige Freigabe der Normdaten als öffentlicher Datenbank-Abzug unter einer freien Lizenz.

Zur Klärung der Konfusion bezüglich URI und URL sei auf die Artikel URIs, URLs, and URNs: Clarifications and Recommendations (via Kay Heiligenhaus) und On Linking Alternative Representations To Enable Discovery And Publishing hingewiesen.

P.S: Eine bibliotheksrelevante Anwendung von von Identifikatoren für Personen wurde letzte Woche von Arjan Hogenaar and Wilko Steinhoff im Vortrag Towards a Dutch Academic Information Domain auf der Open Repositories 2008 vorgestellt.

Heidelberger Katalog auf dem Weg zu Serviceorientierter Architektur

23. Dezember 2007 um 20:59 4 KommentareDie zunehmende Trennung von Bibliotheksdaten und ihrer Präsentation zeigt „HEIDI“, der Katalog der Unibibliothek Heidelberg. Vieles, was moderne Bibliothekskataloge bieten sollten, wie eine ansprechende Oberfläche, Einschränkung der Treffermenge per Drilldown, Permalinks, Exportmöglichkeit (u.A. direkt nach BibSonomy), RSS-Feeds und nicht zuletzt eine aktuelle Hilfe für Benutzer ist hier – zwar nicht immer perfekt, aber auf jeden Fall vorbildhaft – umgesetzt. Soweit ich es von Außen beurteilen kann, baut der Katalog auf zentralen Daten des Südwestdeutschen Bibliotheksverbundes (SWB) und lokalen Daten des lokalen Bibliothekssystems auf. Zum Vergleich hier ein Titel in HEIDI und der selbe Titel im SWB-Verbundkatalog. Aus dem Lokalsystem werden die Titeldaten mit Bestands- und Verfügbarkeitsdaten der einzelnen Exemplare angereichter, also Signatur, Medien/Inventarnummer, Standort, Status etc.:

Die tabellarische Ansicht diese Daten erinnert mich an WorldCat local, das sich zu WorldCat teilweise so verhält wie ein Bibliotheks-OPAC zu einem Verbundsystem. Hier ein Beispieldatensatz bei den University of Washington Libraries (und der gleiche Datensatz in WorldCat). Die Exemplardaten werden aus dem lokalen Bibliothekssystem als HTML-Haufen per JavaScript nachgeladen, das sieht dann so aus:

Bei HEIDI findet die Integration von Titel- und Exemplardaten serverseitig statt, dafür macht der Katalog an anderer Stelle rege von JavaScript Gebrauch. In beiden Fällen wird eine proprietäres Verfahren genutzt, um ausgehend von einem Titel im Katalog, die aktuellen Exemplardaten und Ausleihstati zu erhalten. Idealerweise sollte dafür ein einheitliches, offenes und webbasiertes Verfahren, d.h. ein RDF-, XML-, Micro- o.Ä. -format und eine Webschnittstelle existieren, so dass es für den Katalog praktisch egal ist, welches lokale Ausleih- und Bestandssystem im Hintergrund vorhanden ist. Die Suchoberfläche greift damit als als ein unabhängiger Dienst auf Katalog und Ausleihsystem zu, die ihrerseits eigene unabhängige Dienste mit klar definierten, einfachen Schnittstellen bereitstellen. Man spricht bei solch einem Design auch von „Serviceorientierter Architektur“ (SOA), siehe dazu der Vortrag auf dem letzten Sun-Summit. Eigentlich hätte beispielsweise die IFLA sich längst um einen Standard für Exemplardaten samt Referenz-implementation kümmern sollen, aber bei FRBR hat sie es ja auch nicht geschafft, eine RDF-Implementierung auf die Beine zu stellen; ich denke deshalb, es wird eher etwas aus der Praxis kommen, zum Beispiel im Rahmen von Beluga. Der Heidelberger Katalog setzt SOA noch nicht ganz um, geht allerdings schon in die richtige Richtung. Beispielweise wird parallel im Digitalisierten Zettelkatalog DigiKat gesucht und ggf. ein Hinweis auf mögliche Treffer eingeblendet. Wenn dafür ein offener Standard (zum Beispiel OpenSearch oder SRU) verwendet würde, könnten erstens andere Kataloge ebenso dynamisch zum DigiKat verweisen und zweitens in fünf Minuten andere Kataloge neben dem DigiKat hinzugefügt werden.

Ein weiteres Feature von HEIDI sind die Personeneinträge, von denen auf die deutschsprachige Wikipedia verwiesen wird – hier ein Beispiel und der entsprechende Datensatz im SWB. Die Verlinkung auf Wikipedia geschieht unter Anderem mit Hilfe der Personendaten und wurde von meinem Wikipedia-Kollegen „Kolossos“ erdacht und umgesetzt. Ãœber einen statischen Link wird eine Suche durch einen Webservice angestossen, der mit Hilfe der PND und des Namens einen passenden biografischen Wikipedia-Artikel sucht. Ich könnte den Webservice so erweitern, dass er die SeeAlso-API verwendet (siehe Ankündigung), so dass Links auf Wikipedia auch nur dann angeboten werden, wenn ein passender Artikel vorhanden ist. Für einen verlässlichen und nachhaltigen Dienst ist es dazu jedoch notwendig, dass der SWB seine Personenangaben und -Normdaten mit der PND zusammenbringt. Natürlich könnte auch nach Namen gesucht werden aber warum dann nicht gleich den Namen einmal in der PND suchen und dann die PND-Nummer im Titel-Datensatz abspeichern? Hilfreich wäre dazu ein Webservice, der bei Ãœbergabe eines Namens passende PND-Nummern liefert. Die Fälle, in denen eine automatische Zuordnung nicht möglich ist, können ja semiautomatisch gelöst werden, so wie es seit über zwei Jahren der Wikipedianer APPER mit den Personendaten vormacht. Hilfreich für die Umsetzung wäre es, wenn die Deutsche Nationalbibliothek URIs für ihre Normdaten vergibt und ihre Daten besser im Netz verfügbar macht, zum Beispiel in Form einer Download-Möglichkeit der gesamten PND.

P.S.: Hier ist testweise die PND-Suche in Wikipedia als SeeAlso-Service umgesetzt, zum Ausprobieren kann dieser Client verwendet werden, einfach bei „Identifier“ eine PND eingeben (z.B. „124448615“).

Vorbereitungen zur Archivierung von Netzpublikationen bei der DNB

29. Mai 2007 um 15:25 1 KommentarAuf heise ist wieder etwas zur Archivierung von Netzpublikationen durch die Deutsche Nationalbibliothek (DNB) zu lesen. Die DNB betreibt ein Informationsportal zur Ablieferung von Publikationen, die im Netz erscheinen. Mit dem im Juni 2006 geänderten Gesetz über die Deutsche Nationalbibliothek (DNBG) fallen diese Werke auch unter den Sammelauftrag der DNB. Näheres soll die Pflichtabgabeverordnung klären, die heise im Entwurf vorliegt – allerdings ist der Entwurf anscheinend nicht öffentlich, kann das bitte jemand online stellen? Bis es soweit ist, werde ich mal schauen, wie die Ablieferung von Weblogs am Besten zu bewerkstelligen ist. Dass die DNB selber die Feeds sammeln wird, bezweifle ich (obwohl es die einfachste Variante wäre). Vielleicht hilft das unAPI-Plugin weiter, dass von Mike Giarlo betreut wird, der mit Technosophia mit einen schönen Tech-Librarian-Weblog betreib. Das Zusammenpacken und Bereitstellen der Postings eines ausgewählten Zeitraums dürfte mit einem passenden Plugin kein Problem sein; der Teufel steckt aber wahrscheinlich im Detail.

Neueste Kommentare