MPDL-Stelle zur Verwaltung von Normdaten mit Webservices

27. Juni 2008 um 17:13 2 KommentareDie Max Planck Digital Library hat eine interessante Stelle als „Scientific Developer“ in Berlin ausgeschrieben (siehe Stellenausschreibung als PDF). Gesucht ist als Vertretung wegen Elternzeit ein(e) Entwickler(in) zur Erstellung einer Infrastruktur (Webservices etc.) für Normdaten (Authority files) von Organisationen und Personen im Rahmen der Max Planck Institute. Normdaten spielen zur kontrollierten Erschließung eine zunehmede Rolle auch in Bezug auf die Entwicklung zum Semantic Web. Bibliotheken und Dokumentations- einrichtungen sind hier eigentlich relativ gut positioniert sofern sie ihre Normdaten aktiv zur Verfügung stellen.

Wie Patrick Danowski in einem Vortrag betont hat, wird es bald Alternativen zu bestehenden Normdaten geben (z.B. Wikipedia-Artikel selber), wenn sich bei den existieren Daten nichts tut. Bei den Normdaten zu Personen ist zumindest einiges in Bewegung geraten, ich gehe davon aus, dass die PND „bald“ endlich per Webservice verfügbar sein wird, nachdem einige Schwierigkeiten überwunden sein werden (apropos „wird sein werden“: Kann mal jemand den dürftigen Wikipedia-Eintrag zu Futur II ausbauen?).

Ebenfalls relevant im Zusammenhang mit Normdaten über Webservices sind die Aktivitäten um Museumsvokabular.de. Ich bin leider noch nicht dazu gekommen, zu demonstrieren, wie mit SeeAlso ein einfaches Formular-Eingabefeld um Normdaten-Unterstützung erweitern werden kann – vielleicht hat die MPDL ja Interesse und wir können die gemeinsame Entwicklung gleich bei bibforge hosten, mal sehen.

Ach ja: Die Stelle wird nach TVöD-Bund bezahlt – in anderen Ländern würde so eine einjährige Technikerstelle vermutlich eher an einen Freiberufler vergeben werden, der dann in der Einrichtung einen Arbeitsplatz bekommt, deutlich mehr verdient, sich aber auch selber versichern muss.

Gewinner des Theseus-Wettbewerb ausgezeichnet

20. Juni 2008 um 16:40 Keine KommentareUnter 180 Bewerbungen im Rahmen des Theseus-Talente-Wettbewerbs sind vor drei Tagen die Gewinner ausgezeichnet worden. Ein Vorschlag, die Webseite des Wettbewerbs von unnötigen PDFs zu befreien, fand sich anscheinend nicht unter den Einreichungen – etwas versteckt findet sich zumindest ein „News“-Beitrag, in dem die ersten vier von 14 ausgezeichneten Gewinner kurz mit ihrem Thema genannt sind. Statt langweiligen Informatik-, Technik-, und Wirtschaftsthemen gibt es den erste Preis für einen Beitrag zum Thema „Tagging“ in Verbindung mit „Semantik“. Die Autorin Sonja Kraus studiert auf Lehramt und Magister mit den Nebenfächern Angewandte Sprachwissenschaft und sprachliche Informationsverarbeitung und hat ihren Beitrag mit „Semantstrategien“ betitelt. Was genau das sein soll geht auch aus ihrem Blog nicht so ganz hervor und die Originalarbeit ist auch (noch?) nicht öffentlich verfügbar, so dass es erstmal bei Buzzwords bleibt. Ich hoffe, es ergeht der Arbeit nicht wie dem ersten deutschsprachigen Buch zum Thema Social Tagging („Social Tagging“ von Sascha Carlin, ISBN 3-940317-03-9), auf das ich schon seit einem Dreivierteljahr vergeblich warte. Stattdessen wird nun das erste Buch der Sammelband „Good Tags, Bad Tags“ zur Tagung Social Tagging in der Wissensorganisation, der unter Anderem einen Beitrag von mir zum Semantischen Tagging enthält (weitere Infos zum Sammelband bei Birgit Gaiser). Neben Sonjas Arbeit wurde übrigens noch ein weiterer Text zum Thema Tagging ausgezeichnet und zwar der von Kim Korte (gefunden dank Trackback in Sonjas Blog :-).

Pseudo-URIs als Identifikatoren für Normdaten der Deutschen Nationalbibliothek

7. April 2008 um 03:31 7 KommentareDie Deutsche Nationalbibliothek (DNB) hat anscheinend Ende März eine neue Katalog-Oberfläche online gestellt – der alte OPAC ist auch noch verfügbar. Dabei sind unter Anderem die Normdaten (SWD, GKD, PND) teilweise besser integriert. Ich warte ja schon seit einiger Zeit darauf, dass endlich richtige URIs vergeben werden, so dass sich Normdaten global referenzieren lassen. Bei der aktuellen Lösung ist aber leider einiges schiefgelaufen.

Was ist eine URI?

Die Diskussion zum Thema URI/URN/URL auf Inetbib hat mal wieder gezeigt, dass es beim Thema Identifikatoren oft Missverständnisse gibt. Die international allgemeine Form globaler Identifikatoren ist der „Uniform Resource Identifier“ (URI) bzw. die Erweiterung „Internationalized Resource Identifier“ (IRI). Sie sind in RFC 3986 und RFC 3987 standardisiert. Die Vergabe von UR regelt RFC 4395. Verschiedene URI-Schemata (gekennzeichnet durch den Teil einer URI bis zum ersten Doppelpunkt) sind jeweils mit einem eigenen Standard registriert und definiert, zum Beispiel URNs durch RFC 2141.

Viele URI-Schemata legen Namensräume und eigene Regeln zur Struktur und Vergabe von Identifikatoren fest. So zum Beispiel RFC 3406 für URNs und RFC 3044 für den URN-Namensraum urn:issn zur Abbildung von ISSNs. Durch die Formulierung von ISSNs als URI können diese bereits etablierten aber nur begrenzt nutzbaren Identifikatoren auch global genutzt werden, beispielsweise im Rahmen des Semantic Web. Während die Zeichenfolge „0024-9319“ sehr unterschiedliches identifizieren kann, weist „urn:issn:0024-9319“ eindeutig auf die amerikanische Ausgabe des MAD-Magazins hin.

Um welche Identifikatoren geht es?

Zur Identifikation von Personen (PND), Begriffen (SWD) und Körperschaften (GKD) gibt es im deutschen Bibliothekssystem seit vielen Jahren etablierte Normdaten. Abgesehen von wenigen Ausnahmen fristen diese Normdaten bzw. ihre Identifikatoren jedoch eher ein Schattendasein. Andere Identifikatoren, wie beispielsweise die Nummern von OCLC und der Library of Congress werden dagegen auch zunehmend von den „global players“ im Netz verwendet (von Google und LibrayThing). Wenn sie endlich mit URIs versehen und frei veröffentlicht würden, könnten die deutschen Normdateien ebenfalls weitere Verbreitung finden – oder andernfalls an Bedeutung verlieren.

Was hat die DNB falsch gemacht?

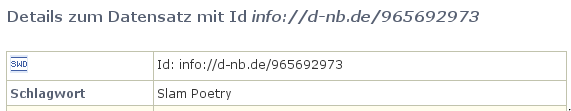

Anscheinend ist nun bei der Erstellung von Identifikatoren für Normdaten bei der Deutschen Nationalbibliothek gleich an mehreren Stellen etwas schief gelaufen. Dabei sieht es auf den ersten Blick ganz gut aus: Beim SWD-Eintrag „Poetry Slam“ ist beispielsweise dort als „Id“ die Zeichenkette „info://d-nb.de/965692973“ angegeben:

Ist das eine URI? Nein. In der offiziellen Liste von URI-Schemata ist „info:“ als gültiges URI-Schema eingetragen, das durch RFC 4452 definiert wird. Die dort festgelegte Maintenance Authority NISO hat die Verwaltung von Namensräumen an OCLC weitergegeben. Nun bekleckert sich OCLC mit dem seit Wochen nicht erreichbaren Verzeichnis der vergebenen Unternamensräume auch nicht gerade mit Ruhm, aber immerhin gibt es klare Standards (mehr Informationen bei der LOC). Eine info-URI ist aufgebaut nach dem Schema „info:NAMENSRAUM/LOKALTEIL„. Die Zeichenkette „info://d-nb.de/965692973“ kann also schon formal keine URI sein. Außerdem ist „d-nb.de“ nicht als gültiger info-URI Namensraum registriert. Zu allem Ãœberfluss wird nicht auf die etablierten SWD-Nummern zurückgegriffen (die SWD-Nummer für den SWD-Datensatz ist „4709615-9“), sondern als lokaler Bestandteil die nicht standardisierte, systemabhängige PND-Nummer (hier: 965692973) verwendet!

Wie lässt sich der Schlamassel beheben?

Leider ist dies nicht das erste mal, dass sich die DNB im Internet lächerlich macht. Zum Glück lassen sich die Fehler relativ einfach beheben.

1. Die bereits existierenden „Standards“ für die existierenden Normdaten-Nummern werden explizit und verlässlich festgeschrieben, d.h. erlaubte Zeichen und Wertebereiche, Berechnung der Prüfziffer und Normalisierung (siehe LCCN-Normalisierung).

2. Die DNB reserviert für die Normdaten-Nummern einen URI-Namensraum (beispielsweise info:swd, info:pnd, info:gkd). Dabei sind die Regeln zur Syntax und Vergabe von URI-Schemata und Namensräumen einzuhalten. Internationale Standards sind zum Lesen und Einhalten da und nicht zum Ignorieren und Uminterpretieren.

3. Die URIs werden verständlich dokumentiert und propagiert. Die Kür wäre eine völlige Freigabe der Normdaten als öffentlicher Datenbank-Abzug unter einer freien Lizenz.

Zur Klärung der Konfusion bezüglich URI und URL sei auf die Artikel URIs, URLs, and URNs: Clarifications and Recommendations (via Kay Heiligenhaus) und On Linking Alternative Representations To Enable Discovery And Publishing hingewiesen.

P.S: Eine bibliotheksrelevante Anwendung von von Identifikatoren für Personen wurde letzte Woche von Arjan Hogenaar and Wilko Steinhoff im Vortrag Towards a Dutch Academic Information Domain auf der Open Repositories 2008 vorgestellt.

Was ist Semantisches Tagging?

26. Februar 2008 um 14:19 11 KommentareIn Anschluß an den sehr fruchtbaren Workshop Social Tagging in der Wissensorganisation (Program und weitere Berichte von Mandy Schiefner, bei Joachim Wedekind und Johannes Moskaliuk) schreibe ich grade an einem Artikel über „Semantic Tagging“. Im Zusammenhang mit Social Tagging wurde das Thema Semantic Web zwar immer wieder genannt und die Beiträge dazu im letzten Panel waren alle interessant; wie den nun konkret beide Welten zusammenkommen sollen, blieb aber abgesehen vom Vortrag von Rolf Sint und Georg Güntner von Salzburg Research) über das Terminologie-Modul im Projekt LIVE etwas vage – vielleicht liegt das auch an meiner Technik-zentrierten Sicht, auf Implementierungen und Spezifikationen.

So wie ich das LIVE-Projekt verstanden habe, sollen bei der Olympiade 2008 sportliche Ereignisse „live“ verschlagwortet werden, wobei freie Tags zeitnah mit Hilfe eines Thesaurus-Editors in die „Ontologie“ eingearbeitet werden; das ganze basiert auf SKOS und ist damit weitgehend Semantic-Web-kompatibel – und ein Beispiel für Semantic Tagging. Mit Social Tagging hat das Projekt allerdings nur noch wenig zu tun. Falls sich dennoch normale Nutzer am Tagging der PR-Olympiade beteiligen dürfen, hier mal ein Vorschlag für die Tag-Cloud:

Aber zurück zum Semantischen Tagging: Die Bezeichnung ist eigentlich schon aus der Linguistik besetzt; dort wird unter Semantic Tagging die Erkennung und Auszeichnung von Namen und syntaktischen Strukturen in einem Text verstanden. Ein sehr einfaches Beispiel aus dem Web sind semantische HTML-Tags wie em, strong und cite; eine andere Form semantischen Taggings im Web, die eher in Richtung Auszeichnung von Daten geht, sind Mikroformate. Von dort lässt sich zwar wieder der Bogen zum Semantic Web spannen, aber eigentlich ist semantisches Tagging im Linguistischen Sinne etwas anderes: Gegeben ist ein Text, in dem einzelnen Bestandteile wie Subjekt, Objekt, Nebensatz, Personennamen etc. als solche markiert werden. Beim Social Tagging werden dagegen freie Tags an einen gesamten Text (oder ein anderes Objekt) angehängt, um seinen gesamten Inhalt zu beschreiben. Irgendwo sollte sich deshalb zwischen Semantischem Tagging innerhalb eines Textes und Semantischem Tagging als (Social) Tagging mit expliziter Semantik eine Grenze ziehen lassen.

Dachte ich. Bis ich entdeckt habe, was die Nachrichtenagentur Reuters Ende Januar online gebracht hat: Mit der kostenlosen Web-API „Calais“ lassen sich Texte analysieren, indem Reuters Namen, Orte, Zahlen und andere Angaben extrahiert (siehe API-Dokumentation) und mit RDF auszeichnet. [via Taxonomy Watch] Ob die gefundenen Entitäten auch gleich mit URIs versehen werden oder ob nur ausgezeichnet wird, dass es sich beispielsweise um einen Firmennamen handelt, habe ich noch nicht rausgefunden – in jedem Fall dürften die extrahierten Terme gute Vorschläge für semantisches Tagging abgeben. Zum Ausprobieren kann dieses Formular verwendet werden.

Ach herrje – Ich weiß manchmal nicht, ob ich begeistert sein soll, in welch spannender Weise sich das Web zur Zeit weiterentwickelt oder ob ich daran verzweifeln sollte, wie komplex und schnell das alles geht. Inzwischen ist „Semantic Web“ ja schon so hype, dass es schwierig wird, die Spreu vom Weizen zu trennen.

Semantic Wiki Workshop

5. Februar 2008 um 20:30 Keine KommentareThe 5th European Semantic Web Conference (ESWC) at the beautiful island of Tenerife (June 1st to 5th 2008) will host the 3rd Semantic Wiki Workshop (SemWiki2008). Forget about specialized ontology editors – Wikis are the smarter way to edit information for the Semantic Web! Deadline for submission of research papers, position papers, and system demonstrations is February 22th. Unfortunately I have another meeting the same days, but you should consider to participate!

Encoding ISO 3166 in RDF with SKOS

29. Januar 2008 um 00:56 Keine KommentareLast year at the 2nd International Conference on Metadata and Semantics Research (MTSR 2007) I gave a talk about the Simple Knowledge Organisation System (SKOS) and its application to encode ISO 3166 country codes. The revised paper „Encoding changing country codes for the Semantic Web with ISO 3166 and SKOS“ is finally ready to appear in the post-proceedings. The preprint is accessible at http://arxiv.org/abs/0801.3908. I raised three issues (notations, nesting concept schemes, and versioning) that are not included in the current SKOS draft – but the proposed solutions are compliant, beside the nesting of concept schemes with the RDF property skos:member – which could be possible by making skos:ConceptScheme a RDF subclass of skos:Collection. Therefore the paper can also be used as a general introduction to SKOS, especially to encode authority files. More details in the paper and at the public-esw-thes@w3.org mailing list. SKOS is going to become a W3C recommendation this year.

First draft of OAI-ORE

30. Dezember 2007 um 18:06 Keine Kommentare„Web 3.0“ (or „Semantic Web“ – use the buzzword of your choice) is slowly on the raise. Two weeks ago the first public draft of OAI-ORE was published and Mike Giarlo published an OAI-ORE-Plugin for WordPress – I have not actually tried it, but as far as I understand one could add RFC 5005 to OAI-ORE to support large resource sets. Or is OAI-PMH enough? Well, in the end it depends on the availability of software libraries, client and the ease of connecting it with other services. After my fancy there are still too much generalized data models but we need concrete implementations – it was not RDF and OWL but Microformats that got the Web of data started (yes, we’re in it: the next hype after „Web 2.0“). For 2008 I wish less abstract meta-meta-meta-stuff but, more little usable applications and services that can be combined.

Semantic Web aus Bibliothekssicht

14. Oktober 2007 um 23:00 2 KommentareBen weist im IB-Weblog auf einen Beitrag von Allen Cho hin, der Web 3.0-Librarian-Weblog von hin, der mit Dean Giustini den Artikel The Semantic Web as a Large, Searchable Catalogue: A Librarian’s Perspective verfasst hat. Abgesehen davon, dass sie aus meiner Sicht mit einigem Durcheinander und Fehlurteilen ahnen lassen, dass über das Semantic Web ebenso viel Übertreibungen und Unsinn verbreitet werden wird, wie über Web 2.0, enthält der Artikel trotz Übertreibungen eine richtige Kernaussagen: Dokumentarische Erschließung und Semantic Web haben viele Gemeinsamkeiten. Oder wie die Autoren schreiben:

The Resource Description Framework (RDF), a method of connecting URIs in a meaningful way, is the key to making the Semantic Web possible. Making connections among and between documents and ideas is something librarians do for a living.

Nur: wieviele Bibliothekare haben sich wenigstens mal mit RDF auseinandergesetzt und zumindest die wichtigsten Eigenschaften (URIs, Unicode, Triples) verstanden? Wenn man daran denkt, welch Schattendasein FRBR nach über einem Dutzend Jahren noch immer fristet und wie noch immer eher diskutiert statt ausprobiert wird, kann man schon stark daran zweifeln, ob an der folgenden Prognose etwas dran ist:

Many of the same techniques of bibliographic control apply to the possibilities of the Semantic Web. It was the computer scientists and computer engineers who had created Web 1.0 and 2.0, but it will ultimately be individuals from library science and information science who will play a prominent role in the evolution of organizing the messiness into a coherent whole for users.

Zumindest mit „individuals from library science and information science“ haben Sie recht.

Presentation about versioned ISO-3166 in SKOS

11. Oktober 2007 um 00:03 1 KommentarUnlike my usual habbits and thanks to W-LAN in the hotel, the slides of my presentation Encoding changing country codes in RDF with ISO 3166 and SKOS at the second International Conference on Metadata and Semantics Research (MTSR2007) are ready and online even before the conference started! The full, detailed paper is not online yet because I am revising and correcting it (I found a very relevant paper after submission). And the serendipity effect of slideshare works: looking for other presentations about SKOS I stumbled upon the very interesting slides of Sebastion Kruk who works in the Corrib project on semantic web and digital libraries.

P.S: A preprint of the revised paper is available at arXiv.org.

Neuigkeiten aus dem Wikipedia-Projekt

2. Oktober 2007 um 12:23 Keine KommentareSoeben ist der erste KIM-DINI-Technology-Watch-Report (ISSN 1865-3839) herausgekommen, in dem auf 35 Seiten aktuelle Entwicklungen aus dem Bereich Standards und Standardisierungender digitalen Informationsversorgung zusammengefasst werden. Ich habe einen Beitrag zu aktuellen Neuigkeiten aus dem Wikipedia-Projekt beigesteuert, den ich an dieser Stelle ebenfalls veröffentlichen möchte. Genannt werden Maßnahmen zur Qualitätssicherung und die Extraktion von Daten aus Wikipedia für das Semantic Web:

Beitrag Neuigkeiten aus dem Wikipedia-Projekt weiterlesen…

Neueste Kommentare