Social Cataloging ist Bibliothekswissenschaft at its best

2. Juni 2008 um 21:47 3 KommentareIst eigentlich schon jemandem aufgefallen, dass das Erste Lehrbuch der Bibliothekswissenschaft, nämlich Martin Schrettingers „Handbuch der Bibliothek-Wissenschaft von 1834 mit vollständigem Titel „Handbuch der Bibliothek-Wissenschaft, besonders zum Gebrauche der Nicht-Bibliothekare; welche ihre Privat-Büchersammlung selbst einrichten wollen“ heisst? Social Cataloging ist also nichts anderes als die Fortführung von Bibliothekswissenschaft mit zeitgemäßen Mitteln. Zeitgemäß heisst nichts anderes als digital (entweder digital oder marginal) und damit kommt der Social Software-Aspekt des Social Catalogings ganz automatisch. Denn Digital heisst unbegrenzte kopier- und modifizierbar, das war schon vor 20 Jahren so, auch wenn das bei einigen ewig Gestrigen noch immer nicht angekommen ist: „Der Computer ist eine Maschine zum Kopieren und Verändern von Bits.“ (Wau Holland). Dass ganz normale bibliophile Menschen ihre Literatursammlungen selber erschließen ist nichts bibliothekarisch Irrelevantes oder Unprofessionelles sonder wäre sicher ganz im Sinne Schrettingers. Gestern hätte sich noch niemand vorstellen können, dass in Zukunft Enzyklopädien von Freiwilligen geschrieben werden, morgen werden wir uns darüber wundern, dass Publikationen früher allein von einer Handvoll Bibliothekaren erschlossen wurden. Die kommen nämlich mit dem Katalogisieren jetzt schon nicht hinterher – oder wo bitte sind die fachlich erschlossenen Weblogs, Primärdaten, Vorträge etc.? Mit den dank Social Cataloging freiwerdenden Kräften können dann die Aufgaben angegangen werden, für die nach Ulrich Johannes Schneider in seinem heutigen, ganzseitigen Artikel in der Süddeutschen Zeitung nicht genügend Stellen da sind. In diesem Sinne wünsche ich allen Bibliothekaren und Nicht-Bibliothekaren, ganz gleich welche Sammlung von Publikationen sie einrichten wollen, einen schönen Bibliothekartag 2008!

BibSonomy und Kataloge verknüpfen mit dem Bibkey

25. April 2008 um 15:46 2 KommentareAnknüpfend an einen Workshop zum Thema „Social Tagging in Bibliotheken“ und an Gespräche auf der INETBIB 2008 gab es Ãœberlegungen, Bibliothekskataloge mit der webbasierten Literaturverwaltung BibSonomy zu verknüpfen (siehe auch die Diplomarbeit von Annett Kerschis auf die Patrick hingewiesen hat).

Zum einen sollen Nutzer Einträge aus dem Katalog direkt in BibSonomy abspeichern können (wie bereits der KUG und HEIDI anbieten) – der einfachste Weg dazu ist ein BibTeX-Export. Zum anderen soll per Webservice BibSonomy abgefragt werden, ob und mit welchen Tags dort bereits ein Titel von Nutzern gespeichert wurde. Ein grundsätzliches Problem dabei ist jedoch, erst einmal den Titel zu identifizieren, nach dem gesucht werden soll. Die dahinter liegende Aufgabenstellung ist ein klassisches (nicht nur) Bibliothekswissenschaftliches Forschungsfeld: Duplikaterkennung in bibliographischen Datenbanken. BibSonomy ist dabei auf eine ähnliche Lösung gekommen, wie sie teilweise in Katalogen angewandt wird: Aus verschiedenen Feldern (Titel, Autor, Jahr…) wird durch Normalisierung und mittels einer Hashfunktion eine Zeichenkette als Identifikator („Hashkey“) gebildet. Dubletten sollen dabei möglichst auf den gleiche Hashkey abgebildet werden. Der übergreifende Hashkey von BibSonomy heisst dort „Interhash“.

Ich bin momentan dabei, diesen Hashkey zu spezifizieren (Unter dem Namen „Bibkey Level 1“) und zu implementieren – der Bibkey kann hier ausprobiert werden. In diesem Beispiel wird der Titel über die ISBN aus den GBV-Verbundkatalog geholt und aus den Daten der Bibkey gebildet (serverseitig, Link „Go to record in GSO“). Mit dem Bibkey wird dann über eine weitere API von BibSonomy (die ich als „SeeAlso“-verpackt habe) abgefragt ob den Titel schon jemand in seiner Sammlung hat (clientseitig, Link „Available in BibSonomy“).

Wie alle Heuristiken funktionier der Bibkey in seiner jetzigen Form nicht in jedem Fall. In diesem Beispiel wird bei BibSonomy nichts gefunden, weil die meisten Nutzer „Albert-László Barabási“ Nicht richtig buchstabieren können. Auch verschiedene Auflagen kommen aufgrund unterschiedlicher Jahreszahl nicht zusammen. Es ist also noch genügend Forschungs- und Entwicklungsbedarf. Auch für den Einsatz von FRBR wird über Hashkeys nachgedacht, wie dieser Vortrag von Rosemie Callewaert auf der ELAG2008 zeigt.

Weitere Literatur zum Thema „Hashkeyverfahren zur Duplikaterkennung in bibliographischen Daten“ sammle ich dank hilfreicher Hinweise mit dem Tag „bibkey“ – falls jemand seine Bachelor/Master-Arbeit dazu machen möchte, helfe ich gerne! 🙂

Vorbildliches OPAC-Widget von der Jacobs University

23. April 2008 um 15:03 1 KommentarKollege John_Paul weist hier im Kommentar und auf den Seiten der Jacobs University auf das gelungene Katalog-Widget jOPAC hin. Der Meinung von Christan Hauschke, dass das Widget „im deutschsprachigen Raum wirklich Maßstäbe setzt“ kann ich mich anschließen. Das Widget ist mit Hilfe von Netvibes Universal Widget API (UWA) programmiert und damit unter verschiedenen Widget-Engines (iGoogle, Netvibes, Windows Vista Sidebar, Apple Dashboard, Windows XP Yahoo Sidebar …) lauffähig. Ein Serverausfall bei Netvibes heute vormittag zeigte allerdings auch ein Manko vieler Mashups: Die Dienste fallen ab und zu mal aus. Wenn der UWA Quellcode von Netvibes auf einen eigenen Server kopiert wird, sollte eine Fehlerquelle minimiert sein. Auf den OPAC der Bibliothek der Jacobs University greift das Widget über einen eigenen Webservice zu, der wiederum per Z39.50 mit dem OPAC kommuniziert – es sollte also nicht sehr aufwändig sein, solch ein Widget auch für andere Bibliotheken anzubieten. Im Detail müsste man sich allerdings anschauen, welche Daten in welchem Format genau über Z39.50 abgefragt werden, da verwendet ja leider gerne jede(s/r) Bibliothek(ssystem/sverbund) seine eigenen Standards.

P.S: Nein, ich habe nichts mit der „Jacobs University“ zu tun, mein Name wird mit „k“ geschrieben 😉

Dynamische Kataloganreicherung mit Webservices

16. April 2008 um 17:36 3 KommentareDie Folien des Vortrags „Dynamische Kataloganreicherung mit Webservices“ am 15.4.2008 Berliner Bibliothekswissenschaftlichem Kolloquium (BBK) sind jetzt online bei Slideshare. In der aktuellen letzten iX (04/2008) gibt es einen Artikel zu Webschnittstellen, die dort erwähnten Sechs Wahrheiten über Freie APIs hätte ich auch noch aufnehmen sollen (auf die Nachteile von Webservices bin ich im Vortrag nicht eingegangen).

Eine Gute Übersicht von Webanwendungen, Widgets und Plugins, die Bibliotheken ihren Nutzern anbieten können, bietet die University of Texas Libraries, Austin. Vom Facebook-Widget bis zum Hinweis auf Zotero ist alles dabei und übersichtlich erklärt. Neue Widgets können direkt empfohlen werden und werden im Blog vorgestellt. Die Bibliothek ist unter Anderem auch Google Book Search-Partner und veröffentlicht Videos bei YouTube.

P.S: Und wo ich so sehr die Wichtigkeit von Standards betont habe: so sollte ein Standard nicht aussehen. Wie bei anderen Themen (Wikipedia-Artikeln, Kongress-veranstaltern etc.) reicht es nicht aus, auf den Namen des Herausgebers zu schauen, um Qualität von Müll unterscheiden zu können – ISO-„Standards“ sind beispielsweise nicht nur nicht frei zugänglich (und damit schon mal zweifelhaft) sondern in einigen Fällen eher das Gegenteil eines Standarts.

Pseudo-URIs als Identifikatoren für Normdaten der Deutschen Nationalbibliothek

7. April 2008 um 03:31 7 KommentareDie Deutsche Nationalbibliothek (DNB) hat anscheinend Ende März eine neue Katalog-Oberfläche online gestellt – der alte OPAC ist auch noch verfügbar. Dabei sind unter Anderem die Normdaten (SWD, GKD, PND) teilweise besser integriert. Ich warte ja schon seit einiger Zeit darauf, dass endlich richtige URIs vergeben werden, so dass sich Normdaten global referenzieren lassen. Bei der aktuellen Lösung ist aber leider einiges schiefgelaufen.

Was ist eine URI?

Die Diskussion zum Thema URI/URN/URL auf Inetbib hat mal wieder gezeigt, dass es beim Thema Identifikatoren oft Missverständnisse gibt. Die international allgemeine Form globaler Identifikatoren ist der „Uniform Resource Identifier“ (URI) bzw. die Erweiterung „Internationalized Resource Identifier“ (IRI). Sie sind in RFC 3986 und RFC 3987 standardisiert. Die Vergabe von UR regelt RFC 4395. Verschiedene URI-Schemata (gekennzeichnet durch den Teil einer URI bis zum ersten Doppelpunkt) sind jeweils mit einem eigenen Standard registriert und definiert, zum Beispiel URNs durch RFC 2141.

Viele URI-Schemata legen Namensräume und eigene Regeln zur Struktur und Vergabe von Identifikatoren fest. So zum Beispiel RFC 3406 für URNs und RFC 3044 für den URN-Namensraum urn:issn zur Abbildung von ISSNs. Durch die Formulierung von ISSNs als URI können diese bereits etablierten aber nur begrenzt nutzbaren Identifikatoren auch global genutzt werden, beispielsweise im Rahmen des Semantic Web. Während die Zeichenfolge „0024-9319“ sehr unterschiedliches identifizieren kann, weist „urn:issn:0024-9319“ eindeutig auf die amerikanische Ausgabe des MAD-Magazins hin.

Um welche Identifikatoren geht es?

Zur Identifikation von Personen (PND), Begriffen (SWD) und Körperschaften (GKD) gibt es im deutschen Bibliothekssystem seit vielen Jahren etablierte Normdaten. Abgesehen von wenigen Ausnahmen fristen diese Normdaten bzw. ihre Identifikatoren jedoch eher ein Schattendasein. Andere Identifikatoren, wie beispielsweise die Nummern von OCLC und der Library of Congress werden dagegen auch zunehmend von den „global players“ im Netz verwendet (von Google und LibrayThing). Wenn sie endlich mit URIs versehen und frei veröffentlicht würden, könnten die deutschen Normdateien ebenfalls weitere Verbreitung finden – oder andernfalls an Bedeutung verlieren.

Was hat die DNB falsch gemacht?

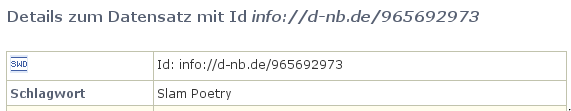

Anscheinend ist nun bei der Erstellung von Identifikatoren für Normdaten bei der Deutschen Nationalbibliothek gleich an mehreren Stellen etwas schief gelaufen. Dabei sieht es auf den ersten Blick ganz gut aus: Beim SWD-Eintrag „Poetry Slam“ ist beispielsweise dort als „Id“ die Zeichenkette „info://d-nb.de/965692973“ angegeben:

Ist das eine URI? Nein. In der offiziellen Liste von URI-Schemata ist „info:“ als gültiges URI-Schema eingetragen, das durch RFC 4452 definiert wird. Die dort festgelegte Maintenance Authority NISO hat die Verwaltung von Namensräumen an OCLC weitergegeben. Nun bekleckert sich OCLC mit dem seit Wochen nicht erreichbaren Verzeichnis der vergebenen Unternamensräume auch nicht gerade mit Ruhm, aber immerhin gibt es klare Standards (mehr Informationen bei der LOC). Eine info-URI ist aufgebaut nach dem Schema „info:NAMENSRAUM/LOKALTEIL„. Die Zeichenkette „info://d-nb.de/965692973“ kann also schon formal keine URI sein. Außerdem ist „d-nb.de“ nicht als gültiger info-URI Namensraum registriert. Zu allem Ãœberfluss wird nicht auf die etablierten SWD-Nummern zurückgegriffen (die SWD-Nummer für den SWD-Datensatz ist „4709615-9“), sondern als lokaler Bestandteil die nicht standardisierte, systemabhängige PND-Nummer (hier: 965692973) verwendet!

Wie lässt sich der Schlamassel beheben?

Leider ist dies nicht das erste mal, dass sich die DNB im Internet lächerlich macht. Zum Glück lassen sich die Fehler relativ einfach beheben.

1. Die bereits existierenden „Standards“ für die existierenden Normdaten-Nummern werden explizit und verlässlich festgeschrieben, d.h. erlaubte Zeichen und Wertebereiche, Berechnung der Prüfziffer und Normalisierung (siehe LCCN-Normalisierung).

2. Die DNB reserviert für die Normdaten-Nummern einen URI-Namensraum (beispielsweise info:swd, info:pnd, info:gkd). Dabei sind die Regeln zur Syntax und Vergabe von URI-Schemata und Namensräumen einzuhalten. Internationale Standards sind zum Lesen und Einhalten da und nicht zum Ignorieren und Uminterpretieren.

3. Die URIs werden verständlich dokumentiert und propagiert. Die Kür wäre eine völlige Freigabe der Normdaten als öffentlicher Datenbank-Abzug unter einer freien Lizenz.

Zur Klärung der Konfusion bezüglich URI und URL sei auf die Artikel URIs, URLs, and URNs: Clarifications and Recommendations (via Kay Heiligenhaus) und On Linking Alternative Representations To Enable Discovery And Publishing hingewiesen.

P.S: Eine bibliotheksrelevante Anwendung von von Identifikatoren für Personen wurde letzte Woche von Arjan Hogenaar and Wilko Steinhoff im Vortrag Towards a Dutch Academic Information Domain auf der Open Repositories 2008 vorgestellt.

Wikisource im DFG-Viewer dank Schnittstellen

31. März 2008 um 14:52 3 KommentareDer DFG-Viewer ist eine relativ neue Webanwendung zur Anzeige von Digitalisaten. Das von der Deutschen Forschungsgemeinschaft geförderte Projekt soll bei der Etablierung von Standards für Digitalisierungsprojekten helfen – und macht das dank Webservices und offener Standards schon recht gut.

Angestoßen von einem Hinweis auf die Sammlung Ponickau an der ULB Sachsen-Anhalt und eine anschließende Diskussion um die andauernden Verwirrungen bezüglich URI, URN, URL Identifikatoren und Lokatoren, habe ich mir den DFG-Viewer etwas näher angesehen. Die Darstellung sieht nicht ganz so cool aus, wie bei The Open Library, dafür gibt es offene Schnittstellen. Digitalisate können dem Viewer per OAI oder direkter URL im METS/MODS-Format übergeben werden. Die einzelnen Seiten eines digitalisierten Buches und dessen innere Struktur (Gliederung) lassen sich dann durchblättern. Eine Volltextsuche ist anscheinend noch nicht implementiert und es fehlt eine eigene Zoom-Funktion; bislang ist es nur möglich zwischen verschieden großen Auflösungen zu wechseln, falls diese vom Repository ausgeliefert werden.

Ein Exemplar des auf INETBIB als Beispiel genannten Buches mit der VD17-Nummer 32:623995L ist in Halle digitalisiert vorhanden. Die Metadaten des Digitalisates können per OAI in METS/MODS abgerufen werden. Ãœbergibt man nun dem DFG-Viewer die URL, kann das Digitalisat im DFG-Viewer betrachtet werden. Im Moment ist noch ein Schritt Handarbeit notwendig, da im DFG-Viewer ein falscher (?) OAI-Server für Halle eingetragen ist, aber grundsächtlich funktioniert das Mashup. 🙂

Statt spaßeshalber eine METS-Datei mit Pornobildchen zusammenzustellen, um sie im DFG-Viewer anzeigen zu lassen, habe ich mir ein zufälliges Digitalisat von Wikisource vorgenommen. In Wikisource gibt es für jedes Digitalisat eine Indexseite, auf der einige Metadaten und die Seiten der digitalisierten Vorlage aufgelistet sind. Aus dieser Seite kann eine METS/MODS-Datei erzeugt und an den DFG-Viewer geschickt werden. Zwei bis drei Stunden später steht ein einfaches Perl-Skript, dass aus der Index-Seite in Wikisource eine METS-Datei erzeugt. Und so sieht es im DFG-Viewer aus (Draufklicken=größere Ansicht):

Das ganze ist nur ein schnell gehackter Proof-of-concept. Eine stabile Verwendung der Metadaten aus Wikisource sollte aus einer OAI-Schnittstelle bestehen, die METS/MODS liefert (und MABXML für ZVDD). Falls jemand Interesse hat (Bachelor/Diplomarbeit, eigenes Projekt etc.), biete ich gerne meine Unterstützung an – umsetzen muss er es jedoch erstmal jemand anderes da ich nicht dauernd nur neue Projekte anfangen kann. 🙁

Bücher, die ich schon mal ausgeliehen hatte…

15. März 2008 um 15:38 1 KommentarHaftgrund berichtet, dass es in Wiener Büchereien „aus Datenschutzgründen“ nicht mehr möglich ist, im Bibliothekssystem auf Wunsch die Titel zu speichern, die man in der Vergangenheit schon mal ausgeliehen hatte. Schön, dass Bibliotheken anders als die meisten Webanbieter auf Datenschutz achten und nicht bis in alle Ewigkeiten speichern, wer wann was gemacht hat. In diesem Fall ist die Begründung aber wohl eher vorgeschoben, schließlich klingt „Datenschutz“ auch kompetenter als „unsere Software kann das nicht und/oder wir wissen nicht wie man sowas technisch umsetzt“. Die Möglichkeit, alle ausgeliehenden Bücher automatisch in einer Liste abzuspeichern, ist meinem Eindruck nach in Bibliotheken ebenso nützlich wie selten.

Wie Edlef bemerkt, kann man ausgeliehene Bücher ja auch „in citavi, Librarything oder beliebigen anderen Literaturverwaltungssystemen für sich selbst [speichern]“ – was prinzipiell tatsächlich die bessere Variante ist. Nur sollten Bibliotheken Nutzer dabei nicht in „kenn wa nich, wolln wa nicht, ham wa nich, geht nich“-Manier abspeisen, sondern aktiv für die Verknüpfung von Bibliothekssystemen mit Literaturverwaltungssystemen sorgen. Alles was über ein Feld „Ausleihen automatisch bei BibSonomy/LibraryThing/etc. eintragen“ im Benutzerkonto hinausgeht, ist nicht zumutbar und überflüssig.

Ein Lösungsansatz gemäß Serviceorientierter Architektur sähe folgendermaßen aus:

Das Ausleihsystem bekommt eine Webschnitttstelle, über die Nutzer abfragen können, welche Medien sie zur Zeit ausgeliehen haben. Wenn dabei RSS oder ATOM eingesetzt wird (natürlich nur über HTTPS und mit Passwort), sollten gängige Feed-Aggregatoren damit klarkommen. Bisher muss der Zugang zum Ausleihsystem für jede Anwendung wie Bücherwecker einzeln gehackt werden, was mühsam und fehleranfällig ist. Die ausgeliehenen Werke sollten (per URL-Parameter steuerbar) in möglichst vielen Datenformaten beschrieben werden. Prinzipiell reicht aber auch die Standard-Kurztitelanzeige und ein Identifier, mit dem z.B. über unAPI weitere Details in verschiedenen Datenformaten angefordert werden können. Zusätzlich zu diesem Pull-Verfahren sollte die Möglichkeit gegeben werden, á la Pingback andere Dienste zu benachrichtigen sobald ein Benutzer ein Medium ausgeliehen hat.

Den Rest (das automatische Eintragen in eine Literaturverwaltung) kann – und sollte – bei gegebenen APIs eine eigene Anwendung übernehmen. Es würde mich nicht wundern, wenn die fixen Entwickler von LibraryThing das selber basteln oder sich ein Student im Rahmen einer Diplom- oder Bachelorarbeit daran setzt. Sobald saubere, einfache Schnittstellen verfügbar sind, ist der Aufwand für neue „Mashups“ und Zusatzdienste minimal.

Wikipedia-Artikel falsch in WorldCat

14. März 2008 um 01:35 2 KommentareOk, WorldCat ist schon eine feine Sache und momentan auf jeden Fall besser als alles in Google Buch-Suche zu packen (was auch eine Möglichkeit wäre) – aber ganz so einfach wie OCLC sich das vorstellt, ist der Betrieb eines Verbundkataloges doch nicht. Mathias hat mich gerade darauf aufmerksam gemacht, dass dort einige hundert falsch katalogisierte Wikipedia-Artikel eingetragen sind. Sicherlich gibt es Anwendungsfälle, in denen die Aufnahme von Wikipedia-Artikeln in einen Bibliothekskatalog sinnvoll ist und sicherlich gibt es richtige Arten, Wikipedia-Artikel zu katalogisieren. Die Einträge bei WorldCat sind keins von beidem – man beachte allein die falsche Herausgeberangabe! Die Möglichkeit, einzelne Versionen von Wikipedia-Artikeln zu zitieren ist sowieso anscheinend völlig unbekannt. Ãœbrigens nehmen auch einige Repositories Wikipedia-Artikel auf, bei OAISter sind mir vor einiger Zeit einige Datensätze untergekommen.

Freie Katalogdaten und Erschließungsmittel

12. März 2008 um 23:57 1 KommentarDie Open Knowledge Foundation setzt sich für freie Daten ein, also Daten die wie Freie Inhalte oder Freie Software ohne Beschränkung weiterverarbeitet, verändert und weiterverbreitet werden dürfen. Letzten Herbst hat sie dazu einen Guide to Open Data Licensing erstellt. Damals wurde der Entwurf einer Lizenz für Freie Daten von Talis und Creative Commons diskutiert – die Hintergründe gibt es unter Anderem bei Talis beschrieben und eine kurze Zusammenfassung bei Peter Suber.

Auf dem jährlichen Treffen der Open Knowledge Foundation am Samstag (15.3.2008) in London soll nun soweit ich es verstanden habe, im Rahmen von Open Data Commons die „Open Data Commons Public Domain Dedication and Licence“ (PDDL) verabschiedet werden. Ein Beispiel für Daten, die mit dieser Lizenz explizit als Public Domain oder Freie Daten gekennzeichnet werden sollten sind bibliografische Katalogdaten.

Letzte Woche gab es im OKF-Blog einen Artikel über Freie Katalogdaten – bisher sieht es trotz öffentlicher Förderung von Bibliotheken schlecht aus – nirgendwo kann explizit der gesamte Katalog heruntergeladen werden. Vielleicht hilft ja das Informationsfreiheitsgesetz – eine öffentliche Einrichtung, die Bücher verwaltet, sollte wenigstens einen vollständigen Bestandskatalog zur Verfügung stellen. Wirklich freie Bibliothekskataloge gibt es also bislang leider nicht.

Neben bibliografischen Daten nehmen die Erschließungsmittel eine zunehmende Rolle ein. Hier entstehen zur Zeit offene Alternativen und Bibliotheken sollten sich fragen, welche Rolle ihre Normdaten, Klassifikationen und Schlagwortsysteme in Zukunft noch haben werden, wenn sie nur eingeschränkt nutzbar sind. Ein Beispiel für ein nicht nutzbares Erschließungssystem nennt Anthony Williams der von Peter kommentiert wird: Die American Chemical Society (ACS) verbietet es, die CAS-Nummern weiterzuverbreiten, mit denen Chemische Verbindungen identifiziert werden. Wenn die ACS mit ihrer Meinung Recht hat, können in Wikipedia-Artikeln über Chemikalien keine CAS-Nummern aufgenommen werden – obwohl sich darüber viele weitere Informationen finden ließen, schließlich sind CAS-Nummern sowas wie „Telefonnummern der Chemischen Welt„.

Tja, anscheinend ist an verschiedenen Stellen noch einiges an Aufklärungsarbeit zu leisten.

Nobelpreis in Bibliotheks- und Informationswissenschaft

15. Februar 2008 um 23:09 Keine KommentareUnbeachtet vom Fachpublikum und den interessierten Laien ist letztes Jahr eine bibliothekswissenschaftliche Arbeit mit dem Literatur-Nobelpreis ausgezeichnet worden! Der Ig-Nobelpreis ging an Glenda Browne für ihre Arbeit über die Indexierung des Artikels ‚the‘, die bereits 2001 in der April-Ausgabe (Band 22, Nummer 3) der Fachzeitschrift The Indexer erschien. In den Annals of Improbable Research (ISSN 1079-5146, abonniert an der SUB Köln und verfügbar als Open Access) hat es dieser spezielle Teilaspekt der Indexierung und Katalogisierung sogar auf die Titelseite der Juli/August-Ausgabe 2006 (Band 12, Nummer 4) geschafft und wird auf den Seiten 6-11 genauer behandelt! So macht Wissenschaft Spaß und das nächste mal wenn jemand fragt, ob Bibliotheks- und Informationswissenschaft überhaupt eine richtige Wissenschaft sei, gibt es endlich ein schlagendes Argument. 🙂

Neueste Kommentare