Inetbib 2008, first German „2.0“ library conference

10. April 2008 um 16:06 2 KommentareParticipating at the Inetbib 2008 conference in Würzburg I am pleased to see that web 2.0 usage among German librarians finally has reached the critical mass. I’d guess that we are more or less 18 month behind the situation of the vital US „library 2.0“ scene. With Inetbib 2008 we finally have a larger general library conference with open wifi and participants blogging (technorati, google blogsearch), twittering, flickring and social-networking the event (or just reading email if the speaker bores ;-). I hope that soon no more library colleauge will think that „all this internet services“ are a waste of time but usefull tools to better recognize developements, ideas, and events – even outside the German biblio-blogosphere (for instance here). The next event will be BibCamp, a Library 2.0 BarCamp at March May 16th/17th in in Potsdam and Berlin.

Der Subito-Rahmenvertrag ist Murx

9. April 2008 um 15:58 8 KommentareDer bisherige Höhepunkt der INETBIB 2008 war – obgleich ich nur mit halbem Ohr mitgehört habe – der Vortrag „Spinn ich oder die anderen?“ – Das Gute am neuen Urheberrecht und das Häßliche am neuen Subito-Rahmenvertrag von Dr. Harald Müller (Bibliothek des Max-Planck-Instituts für ausländisches öffentliches Recht und Völkerrecht). Dabei zerpflückt er den Subito-Rahmenvertrag als – in meinen Worten – überflüssigen, fehlerhaften und schädlichen Murx (Herr Graf kann bei Bedarf sicher drastischere Worte liefern).

Ich komme mir bei guten Vorträgen von Juristen immer vor wie jemand, der sich ohne technischen Sachverstand einen technischen Vortrag anhört. Vielleicht ist das Verhältnis zwischen Bibliotheken und Jura ähnlich dem Verhältnis zwischen Bibliotheken und Technik: es mangelnd an Fachkompetenz. Den anschließenden Kommentaren und Fragen nach zu Urteilen ist ist ein Grund für den vermurxten Subito-Vertrag, dass Bibliotheken Angst haben und vor lieber irgendeine „Rechtssicherheit“ wollen, anstatt eine eigene Rechtsposition zu vertreten – und diese auch zu verteidigen. Aber auch beim Urhheberrecht gilt: Freiheit stirbt mit Sicherheit.

Übersicht webbasierter Literaturverwaltung

9. April 2008 um 15:28 8 KommentareP.S.: Unter http://literaturverwaltung.wordpress.com gibt es inzwischen ein von Bibliothekaren betriebenes Portal zum Theme Literaturverwaltungsprogramme.

Einen Überblick über „Webbasierte Literaturverwaltung“ gab Thomas Stöber von der UB Augsburg in seinem Vortrag zusammen mit Astrid Teichert auf der INETBIB 2008. Das Thema ist eigentlich nicht neu, aber nicht jeder hat die Zeit und Muße, sich selber mit RefWorks, citeulike, Connotea und BibSonomy im Vergleich zu EndNote und Citavi zu beschäftigen – außerdem sollte man das Firefox-Plugin Zotero kennen.

Auf der einen Seite stehen die traditionellen, „geschlossenen“ Systemen (EndNote, Citavi), bei denen ein Nutzer für sich alleine bibliographische Daten sammelt und verwaltet. „Halboffene“ Systeme (EndNote Web, RefWorks) bieten als Webanwendungen zusätzlich die Möglichkeit, Daten für andere Nutzer freizugeben. Bei „Offenen“ Systeme ist der Nutzerkreis prinzipiell offen und alle bibliographischen Daten werden miteinander geteilt.

Die offenen Literaturverwaltungs-Systeme bieten neue Kooperationsmöglichkeiten im Bereich Forschung und Lehre, Stöber zitierte Lambert Hellers Hinweis auf die Möglichkeit „Informeller Gemeinschaftsbibliographien„. Dabei lassen sich aus seiner Sicht drei wesentliche Anwendungszenarien unterscheiden:

(1) Freigabe des eigenen Datenpools mit Lesezugriff, z.B. Literaturlisten für Lehrveranstaltungen, Bibliographien, eigene Schriftenverzeichnisse etc. (RefWorks…)

(2) Geschlossene Arbeitsgruppen arbeiten gemeinsam an Bibliographien (EndNote Web, BibSonomy…)

(3) Gemeinsamer, offener Datenpool (BibSonomy…)

Für die weitere Entwicklung stellen sich angesichts der rasanten Entwicklungen im Bereich webbasierter Literaturverwaltung folgende Fragen:

(1) Ist die offene, gemeinschaftliche Arbeiten an Bibliographien ein realistisches Modell für eine offene Wissenschaft? Laura Cohen spricht schon begeistert von „Social Scholarship (wobei meiner Meinung nach dabei eher Blogs von Bedeutung sind, siehe blogs as scholarship von Georgia Harper und als Beispiel Research Blogging). Viele Wissenschaftler möchten jedoch vermutlich nur ungern ihre Literaturlisten offenlegen (was meiner Meinung nach nicht unbedingt für die Qualität ihrer Forschung spricht).

(2) Sind OpenSource-Anwendung aktuell und zukünftig eine echte Alternative zu kommerziellen Systemen? Thomas Stöber konnte diese Frage nicht bejahen – ich denke vor allem bei der Usability hat OpenSource regelmäßig Probleme.

(3) Wie entwickeln sich Bibliographie-Verwaltungssysteme weiter? Zur Zeit ist eine Konvergenz der Funktionen zu beobachten, so dass sich die verschiedenen Systeme im Kern immer weniger unterscheiden.

In der anschließenden Fragerunde meldeten sich vor Allem die „üblichen Verdächtigen“ (Till Kinstler, Lambert Heller, Patrick Danowski) zu Wort – ich war zu sehr mit der Formulierung dieses Beitrags beschäftigt und kann der Einführung nichts wesentliches hinzufügen. Mir fehlte nur etwas Zotero. Herr Stöber wies darauf hin, dass sich das Programm in erstaunlich kurzer Zeit zu einer vollwertigen Literaturverwaltung entwickelt hat. Dem in der Diskussion gebrachten Hinweis auf die Notwendigkeit von Werbung und Benutzerschulungen kann ich mich nur anschließen.

P.S.: Eine tabellarische Übersicht von Programmen zur Literaturverwaltung gibt beim Max Planck Institut für Biochemie.

Pseudo-URIs als Identifikatoren für Normdaten der Deutschen Nationalbibliothek

7. April 2008 um 03:31 7 KommentareDie Deutsche Nationalbibliothek (DNB) hat anscheinend Ende März eine neue Katalog-Oberfläche online gestellt – der alte OPAC ist auch noch verfügbar. Dabei sind unter Anderem die Normdaten (SWD, GKD, PND) teilweise besser integriert. Ich warte ja schon seit einiger Zeit darauf, dass endlich richtige URIs vergeben werden, so dass sich Normdaten global referenzieren lassen. Bei der aktuellen Lösung ist aber leider einiges schiefgelaufen.

Was ist eine URI?

Die Diskussion zum Thema URI/URN/URL auf Inetbib hat mal wieder gezeigt, dass es beim Thema Identifikatoren oft Missverständnisse gibt. Die international allgemeine Form globaler Identifikatoren ist der „Uniform Resource Identifier“ (URI) bzw. die Erweiterung „Internationalized Resource Identifier“ (IRI). Sie sind in RFC 3986 und RFC 3987 standardisiert. Die Vergabe von UR regelt RFC 4395. Verschiedene URI-Schemata (gekennzeichnet durch den Teil einer URI bis zum ersten Doppelpunkt) sind jeweils mit einem eigenen Standard registriert und definiert, zum Beispiel URNs durch RFC 2141.

Viele URI-Schemata legen Namensräume und eigene Regeln zur Struktur und Vergabe von Identifikatoren fest. So zum Beispiel RFC 3406 für URNs und RFC 3044 für den URN-Namensraum urn:issn zur Abbildung von ISSNs. Durch die Formulierung von ISSNs als URI können diese bereits etablierten aber nur begrenzt nutzbaren Identifikatoren auch global genutzt werden, beispielsweise im Rahmen des Semantic Web. Während die Zeichenfolge „0024-9319“ sehr unterschiedliches identifizieren kann, weist „urn:issn:0024-9319“ eindeutig auf die amerikanische Ausgabe des MAD-Magazins hin.

Um welche Identifikatoren geht es?

Zur Identifikation von Personen (PND), Begriffen (SWD) und Körperschaften (GKD) gibt es im deutschen Bibliothekssystem seit vielen Jahren etablierte Normdaten. Abgesehen von wenigen Ausnahmen fristen diese Normdaten bzw. ihre Identifikatoren jedoch eher ein Schattendasein. Andere Identifikatoren, wie beispielsweise die Nummern von OCLC und der Library of Congress werden dagegen auch zunehmend von den „global players“ im Netz verwendet (von Google und LibrayThing). Wenn sie endlich mit URIs versehen und frei veröffentlicht würden, könnten die deutschen Normdateien ebenfalls weitere Verbreitung finden – oder andernfalls an Bedeutung verlieren.

Was hat die DNB falsch gemacht?

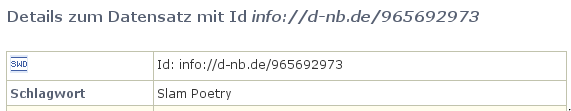

Anscheinend ist nun bei der Erstellung von Identifikatoren für Normdaten bei der Deutschen Nationalbibliothek gleich an mehreren Stellen etwas schief gelaufen. Dabei sieht es auf den ersten Blick ganz gut aus: Beim SWD-Eintrag „Poetry Slam“ ist beispielsweise dort als „Id“ die Zeichenkette „info://d-nb.de/965692973“ angegeben:

Ist das eine URI? Nein. In der offiziellen Liste von URI-Schemata ist „info:“ als gültiges URI-Schema eingetragen, das durch RFC 4452 definiert wird. Die dort festgelegte Maintenance Authority NISO hat die Verwaltung von Namensräumen an OCLC weitergegeben. Nun bekleckert sich OCLC mit dem seit Wochen nicht erreichbaren Verzeichnis der vergebenen Unternamensräume auch nicht gerade mit Ruhm, aber immerhin gibt es klare Standards (mehr Informationen bei der LOC). Eine info-URI ist aufgebaut nach dem Schema „info:NAMENSRAUM/LOKALTEIL„. Die Zeichenkette „info://d-nb.de/965692973“ kann also schon formal keine URI sein. Außerdem ist „d-nb.de“ nicht als gültiger info-URI Namensraum registriert. Zu allem Überfluss wird nicht auf die etablierten SWD-Nummern zurückgegriffen (die SWD-Nummer für den SWD-Datensatz ist „4709615-9“), sondern als lokaler Bestandteil die nicht standardisierte, systemabhängige PND-Nummer (hier: 965692973) verwendet!

Wie lässt sich der Schlamassel beheben?

Leider ist dies nicht das erste mal, dass sich die DNB im Internet lächerlich macht. Zum Glück lassen sich die Fehler relativ einfach beheben.

1. Die bereits existierenden „Standards“ für die existierenden Normdaten-Nummern werden explizit und verlässlich festgeschrieben, d.h. erlaubte Zeichen und Wertebereiche, Berechnung der Prüfziffer und Normalisierung (siehe LCCN-Normalisierung).

2. Die DNB reserviert für die Normdaten-Nummern einen URI-Namensraum (beispielsweise info:swd, info:pnd, info:gkd). Dabei sind die Regeln zur Syntax und Vergabe von URI-Schemata und Namensräumen einzuhalten. Internationale Standards sind zum Lesen und Einhalten da und nicht zum Ignorieren und Uminterpretieren.

3. Die URIs werden verständlich dokumentiert und propagiert. Die Kür wäre eine völlige Freigabe der Normdaten als öffentlicher Datenbank-Abzug unter einer freien Lizenz.

Zur Klärung der Konfusion bezüglich URI und URL sei auf die Artikel URIs, URLs, and URNs: Clarifications and Recommendations (via Kay Heiligenhaus) und On Linking Alternative Representations To Enable Discovery And Publishing hingewiesen.

P.S: Eine bibliotheksrelevante Anwendung von von Identifikatoren für Personen wurde letzte Woche von Arjan Hogenaar and Wilko Steinhoff im Vortrag Towards a Dutch Academic Information Domain auf der Open Repositories 2008 vorgestellt.

Mein Vetter, digitalisierter Gefangener der Gemäldegalerie

26. März 2008 um 11:29 Keine KommentareFür die Abteilung „Dinge, die ich nicht brauche, die aber ganz nett wären“, habe ich für meinen Wunschzettel dieses Objekt entdeckt. Da es wahrscheinlich nur mittels eines angeblich „neben Drogen- und Menschenhandel […] einträglichsten“ Verfahrens beschaffbar ist, reicht zur Not auch eine Kopie aus. Beim Wallraf-Richartz-Museum kann man Abzüge und Scans in verschiedenen Varianten online bestellen. Erst kurz vor Abschluss der Bestellung (High-end-scan RGB 300dpi bis 24x30cm/40MB, Verwendung: Veröffentlichung) steht im Kleingedruckten ein Hinweis auf die Entgeltordnung. Demnach kommen ggf. noch zahlreiche undurchsichtige Zusatzgebühren hinzu und die „Internet-Veröffentlichung“ ist sowieso nur mit Aufpreis und für 3 Monate möglich. Mein Vetter sitzt also sozusagen lebenslang – nein: über sein Ableben hinaus! – als Gefangener der Gemäldegalerie aufgrund zweifelhafter Rechtsvorstellungen fest und keine Aussicht auf Befreiung. Keine Aussicht? Der Urheber ist vor mehr als 70 Jahren gestorben, so dass keine Rechtsansprüche mehr bestehen. Ich kann gerne anbieten, sein Grab zu besuchen, um für seine Werke eine Blume niederzulegen. Aber was ich auf keinen Fall machen werde ist, Museen oder Bibliotheken Geld zur Digitalisierung in die Hand zu drücken, ohne dass dabei die Wikimedia-Empfehlungen für Rechte bei Digitalisierungsprojekten beachtet werden. Dann lieber selber digitalisieren.

P.S: Zum Thema „eigenwilliger Umgang mit Digitalisaten“ hat mein Kollege einen wunderbar treffenden und stilistisch sehr unterhaltsam geschriebenen Text des – mir bislang unbekannten – Institut für Dokumentologie und Editorik entdeckt: In diesem PDF ab Seite 18 unten bis Seite 22 🙂

Bücher, die ich schon mal ausgeliehen hatte…

15. März 2008 um 15:38 1 KommentarHaftgrund berichtet, dass es in Wiener Büchereien „aus Datenschutzgründen“ nicht mehr möglich ist, im Bibliothekssystem auf Wunsch die Titel zu speichern, die man in der Vergangenheit schon mal ausgeliehen hatte. Schön, dass Bibliotheken anders als die meisten Webanbieter auf Datenschutz achten und nicht bis in alle Ewigkeiten speichern, wer wann was gemacht hat. In diesem Fall ist die Begründung aber wohl eher vorgeschoben, schließlich klingt „Datenschutz“ auch kompetenter als „unsere Software kann das nicht und/oder wir wissen nicht wie man sowas technisch umsetzt“. Die Möglichkeit, alle ausgeliehenden Bücher automatisch in einer Liste abzuspeichern, ist meinem Eindruck nach in Bibliotheken ebenso nützlich wie selten.

Wie Edlef bemerkt, kann man ausgeliehene Bücher ja auch „in citavi, Librarything oder beliebigen anderen Literaturverwaltungssystemen für sich selbst [speichern]“ – was prinzipiell tatsächlich die bessere Variante ist. Nur sollten Bibliotheken Nutzer dabei nicht in „kenn wa nich, wolln wa nicht, ham wa nich, geht nich“-Manier abspeisen, sondern aktiv für die Verknüpfung von Bibliothekssystemen mit Literaturverwaltungssystemen sorgen. Alles was über ein Feld „Ausleihen automatisch bei BibSonomy/LibraryThing/etc. eintragen“ im Benutzerkonto hinausgeht, ist nicht zumutbar und überflüssig.

Ein Lösungsansatz gemäß Serviceorientierter Architektur sähe folgendermaßen aus:

Das Ausleihsystem bekommt eine Webschnitttstelle, über die Nutzer abfragen können, welche Medien sie zur Zeit ausgeliehen haben. Wenn dabei RSS oder ATOM eingesetzt wird (natürlich nur über HTTPS und mit Passwort), sollten gängige Feed-Aggregatoren damit klarkommen. Bisher muss der Zugang zum Ausleihsystem für jede Anwendung wie Bücherwecker einzeln gehackt werden, was mühsam und fehleranfällig ist. Die ausgeliehenen Werke sollten (per URL-Parameter steuerbar) in möglichst vielen Datenformaten beschrieben werden. Prinzipiell reicht aber auch die Standard-Kurztitelanzeige und ein Identifier, mit dem z.B. über unAPI weitere Details in verschiedenen Datenformaten angefordert werden können. Zusätzlich zu diesem Pull-Verfahren sollte die Möglichkeit gegeben werden, á la Pingback andere Dienste zu benachrichtigen sobald ein Benutzer ein Medium ausgeliehen hat.

Den Rest (das automatische Eintragen in eine Literaturverwaltung) kann – und sollte – bei gegebenen APIs eine eigene Anwendung übernehmen. Es würde mich nicht wundern, wenn die fixen Entwickler von LibraryThing das selber basteln oder sich ein Student im Rahmen einer Diplom- oder Bachelorarbeit daran setzt. Sobald saubere, einfache Schnittstellen verfügbar sind, ist der Aufwand für neue „Mashups“ und Zusatzdienste minimal.

Wikipedia-Artikel falsch in WorldCat

14. März 2008 um 01:35 2 KommentareOk, WorldCat ist schon eine feine Sache und momentan auf jeden Fall besser als alles in Google Buch-Suche zu packen (was auch eine Möglichkeit wäre) – aber ganz so einfach wie OCLC sich das vorstellt, ist der Betrieb eines Verbundkataloges doch nicht. Mathias hat mich gerade darauf aufmerksam gemacht, dass dort einige hundert falsch katalogisierte Wikipedia-Artikel eingetragen sind. Sicherlich gibt es Anwendungsfälle, in denen die Aufnahme von Wikipedia-Artikeln in einen Bibliothekskatalog sinnvoll ist und sicherlich gibt es richtige Arten, Wikipedia-Artikel zu katalogisieren. Die Einträge bei WorldCat sind keins von beidem – man beachte allein die falsche Herausgeberangabe! Die Möglichkeit, einzelne Versionen von Wikipedia-Artikeln zu zitieren ist sowieso anscheinend völlig unbekannt. Übrigens nehmen auch einige Repositories Wikipedia-Artikel auf, bei OAISter sind mir vor einiger Zeit einige Datensätze untergekommen.

Bibliotheken in LibraryThing mit LibraryThing Local

12. März 2008 um 16:38 Keine KommentareLibraryThing ist vor allem für Öffentliche Bibliotheken wunderbar geeignet – ich hoffe, dass bald mal eine größere Stadtbücherei einsteigt, bislang ist ja Nordenham einsamer Vorreiter. Bisher hat noch niemand die Einbindung in den OPAC mit LibraryThing for Libraries umgesetzt. Schade, dass AbeBooks (zu 40% Anteilseigner an LibraryThing) laut Ausstellerverzeichnis nicht auf der Leipziger Buchmesse ist – ein direkter Ansprechpartner würden deutschen Bibliotheken sicher helfen.

Das neueste Feature (und Anlass dieses Beitrags) ist „LibraryThing Local“: dort lassen sich nette kleine Buchhandlungen, Bibliotheken, literarische Veranstaltungen und sonstige Orte mit Bezug zu Büchern und Lesen eintragen [via netbib]. Aus Berlin hat die Möglichkeit zum Beispiel Marius entdeckt, der darauf hinweist, dass in der Stadtteilbibliothek Berlin-Buch eine Lesung stattfindet. Jetzt müssten diese Daten noch irgendwie mit anderen Veranstaltungsdiensten wie wevent Venteria verknüpft werden.

Die ungeheure Kraft der Communities und warum ich LibraryThing für Bibliotheken ebenso relevant halte wie Wikipedia zeigt vielleicht folgende Aussage aus dem LibraryThing-Weblog:

This morning, three days after its official launch, LibraryThing Local passed 9,000 venues. (UPDATE: 10,000 13,000 15,000 16,000.)

In this time some 700 members have entered more libraries, bookstores, fairs and other venues than our closest competitor in this space assembled in ten months of work, drawing mostly on chain bookstores and publicists.

Bibliotheksveranstaltungen CODE4LIB und BibCamp 2008

24. Februar 2008 um 19:51 3 KommentareIn der kommenden Woche findet in Portland, Oregon die dritte vierte* CODE4LIB-Konferenz statt. Mein französischer Bibliotheks-Informatik-Bruder Nicolas Morin fasst zusammen, auf welche Teile des Programms er sich am meisten freut. Ich war nach zwei sehr produktiven Workshops Ende letzter Woche so konferenzmüde, dass das BarCamp Hannover ausfallen musste. Bei der CODE4LIB wäre ich aber schon gerne dabei, um herauszufinden, was sich hinter so interessanten Vortragstitel wie „Finding Relationships in Marc Data“ von Rob Styles, „Zotero and You, or Bibliography on the Semantic Web“ von Trevor Owens, „Can Resource Description become Rigorous Data?“ von Karen Coyle und „RDF and RDA: declaring and modeling library metadata“ von Corey Harper versteckt und um all die andere Bibliothekstechnik-Nerds zu treffen 🙂

Am ehesten einen Ersatz bietet das Bibcamp am 16 und 17.05.2008 in Berlin, auf das ich hiermit nochmal ausdrücklich hinweisen möchte. Hier wird es im Gegensatz zur CODE4LIB vorranging deutschsprachig und weniger techniklastig zugehen, so dass für alle etwas dabei sein sollte, die an Neuerungen in Bibliotheken interessiert sind. Es wäre nett, sich in die inoffizielle Teilnehmerliste im Wiki einzutragen. Wir sehen uns in Berlin!

P.S.: Wo die nächste CODE4LIB 2009 stattfindet, wird im Laufe der nächsten Woche zwischen vier Kandidaten entschieden. *Laut Peter Murray bzw. Mike. Ich tippe mal auf Ohio, also schon wieder USA 🙁

UB Mannheim führt Social Tagging ein

21. Februar 2008 um 14:59 2 KommentareDas zweite Panel der Workshops Social Tagging in der Wissensorganisation am Institut für Wissensmendien am 21./22. Februar 2008 fasste vier Kurzvorträge unter dem Thema „Bibliotheken und Hochschulen“ zusammen.

Im ersten Vortrag führte Christian Hänger von der Universitätsbibliothek Mannheim mit „Tagging im Kontext Bibliothekarischer Sacherschließung“ an, welche Mehrwerte Social Tagging in Bibliotheken bringen kann, obwohl Bibliotheken Tagging in Form der kontrollierten Erschließung doch schon seit jeher betreiben. Durch Social Tagging können zum einen größere Mengen von Titeln zusätzlich erschlossen werden (zum Beispiel Artikel der Nationallizenzen). Zum anderen können neue Begrifflichkeiten schneller für das Retrieval verfügbar gemacht werden, während die Aufnahme neuer Begriffe in ein kontrolliertes Vokabular relativ lange dauert. Die Nachteile und Grenzens des Tagging bestehen jedoch nach Hänger in der höheren Unschärfe durch Homonyme und Synonyme und in schlechteren Ergebnissen als die Sacherschließung durch Experten.

An der UB Mannheim soll Social Tagging in einem kommenden DFG-Projekt in den OPAC eingebunden werden. Dabei soll unter Anderem untersucht werden, ob sich durch manuelles Tagging bessere Ergebnisse als durch automatische Erschließung erzielen lassen. Auch Misch- und Übergangsformen, wie zum Beispiel das Taggen mit Normdateien sollen ausprobiert werden. Als Tagging-Systeme werden sowohl BibSonomy als auch die Tagging-Funktion von ExLibris Primo eingesetzt.

Im Fazit brachte Christian Hänger seine Einschätzung bemerkenswert auf den Punkt: Tagging wird in Zukunft ein unverzichtbarer Bestandteil der bibliothekarischen Sacherschließung. Es ist jedoch kein Ersatz für bibliothekarische Sacherschließung, sondern eine Ergänzung.

Sicherlich lassen sich beide Aussagen bezweifeln: Möglicherweise ist Tagging für Bibliotheken irrelevant oder aber es wird die bibliothekarischen Sacherschließung überflüssig machen. Die Wahrheit lieht aber eher wie so oft in der Mitte – deshalb ist es sehr zu begrüßen, dass die UB Mannheim (Blog) das Thema Tagging in Bibliotheken einfach mal in die Hand nimmt und ausprobiert anstatt es tot zu diskutieren, um am Ende den Entwicklungen hinterherlaufen zu müssen!

Neueste Kommentare