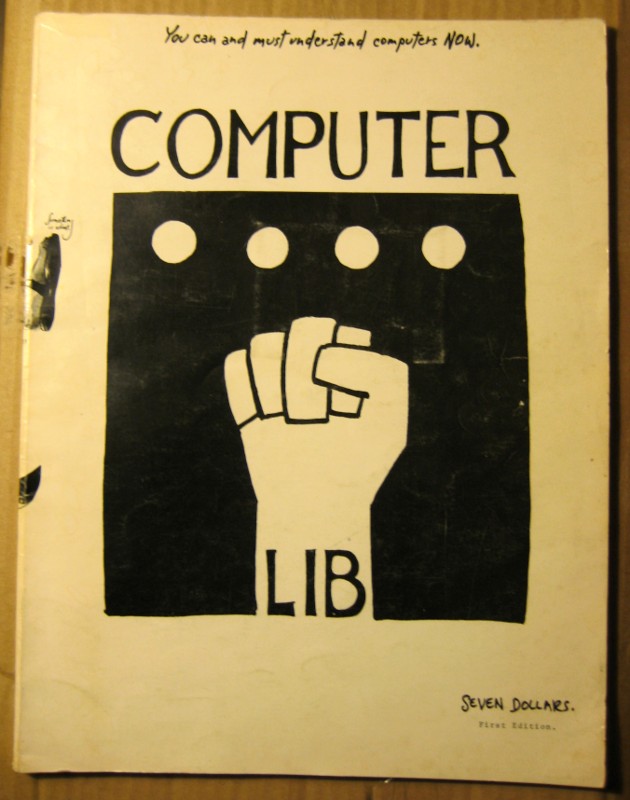

You can and must understand computers NOW

23. Dezember 2010 um 22:29 Keine KommentareWährend Edward Tufte seine Forschungsbibliothek gerade bei Christie’s verkauft hat (katalogisiert bei LibraryThing), baue ich mir meine kleine Spezialbibliothek erst auf. Schuld ist Umberto Eco, der in Die große Zukunft des Buches sagt, dass Büchersammeln kein teueres Hobby sein muss. Falls mir noch jemand ein Geschenk machen möchte: die erste Beschreibung des Binarsystems gibt es für $4.800 🙂

Beim Zoll ist jedenfalls rechtzeitig zu Weihnachten die Erstauflage (1974) von Ted Nelson’s Computer Lib / Dream Machines angekommen. Das Ding ist echt riesig!

Der Slogan „You can and must understand computers NOW“ gilt noch immer, erst Recht für alle die mit Büchern zu tun haben. Siehe auch das Werk bei LibraryThing, Wikipedia und WorldCat.

Anmerkungen zu Dokumenten machen Sinn

18. November 2010 um 02:41 Keine KommentareEnde letzter Woche ist an der UB Leipzig die Ausstellung Druck macht Sinn eröffnet worden. Die Ausstellung zeigt anhand von Inkunabeln und frühen Drucken, wie sich Seitengestaltung und Leseverhalten mit Verbreitung des Buchdrucks im späten 15. und frühen 16. Jahrhundert entwickelt haben. Normalerweise finde ich es eher peinlich, wenn Bibliotheken auf ihre Gutenberg-Bibel stolz sind, als gäbe es für sie nichts Wichtigeres (z.B. die Nutzer). Ein Exemplar dieser berühmte Bibel ist jedoch nur Ausgangspunkt der Ausstellung.

Es folgen viele Beispiele, die anschaulich zeigen, wie sich das geläufige Konzept einer gedruckten Buchseite erst entwickelte. Die Menschen waren noch sehr den Ideen einzeln handgeschriebener Dokumente verhaftet und Vieles musste erstmal ausprobiert werden. Gezeigt wird auch, dass frühe Leser keine passiven Konsumenten waren, sondern ein gedrucktes Buch durch Bindung, Verzierungen und nicht zuletzt Anmerkungen, selber mitgestalteten. Dieser Aspekt hat mich besonders interessiert, da ich mich zur Zeit mit der Möglichkeit von Anmerkungen bei elektronischen Dokumenten beschäftige. Ich habe die Bilder der Ausstellung mit freundlicher Genehmigung bei Wikimedia Commons hochgeladen, von wo sie weiterverwendet werden können. Der folgende Ausschnitt zeigt eine Ausgabe der „Brüder“ von Terenz. Der Druck von 1499 ist extra zweizeilig, um Platz für Anmerkungen zu lassen, wovon der Leser starken Gebrauch gemacht hat:

Gegen diese Möglichkeit der Interaktion sind viele digitale Dokumente heute eher ein Rückschritt. Wie es auch anders gehen könnte, habe ich erstmals 2005 in Libreas beschrieben. Neben Anmerkungen sollte auf die beschriebene Weise auch der Kontext eines Dokumentes sichtbar werden: Die abgebildete Komödie hat Terenz etwa 160 v.Chr. auf Basis von zwei griechischen Stücken erstellt, die Diphilos und Menander etwa um 300 v. Chr. geschrieben haben. Bis ins 20. Jahrhundert gab es zahlreiche kommentierte Ausgaben. In digitaler Form könnten all diese Textvarianten, Anmerkungen und Bezüge besser festgehalten und dargestellt werden.

Vielleicht werden unsere Nachfahren in einigen Jahrzehnten oder Jahrhunderten über eine andere Ausstellung schreiben:

Die Ausstellung „Digital macht Sinn“ zeigt, wie sich Objektgestaltung und Leseverhalten mit Verbreitung digitaler Dokumente im späten 20. und frühen 21. Jahrhundert entwickelt haben. Die Beispiele zeigen anschaulich, wie sich das geläufige Konzept eines digitalen Objekts erst entwickelte. Die Menschen waren noch sehr den einheitlich gedruckter Seiten verhaftet und vieles musste erstmal ausprobiert werden.

P.S: Die mit einem Zeiger und Unterstreichung hervorgehobene Stelle lässt sich übrigens in etwa mit „Was ist denn schon dabei wenn ein junger Kerl Unzucht treibt und trinkt?“ übersetzen. 🙂

P.P.S: Craig Mod hat einen sehr schöner Artikel zu Bücher im Zeitalter des iPad geschrieben, der Zeit, wo die Entwicklung hingehen kann und geht in einem weiteren Artikel geht er auch auf die erweiterten Möglichkeiten von Anmerkungen ein.

Das „nächste große Ding“ im Netz: eine Rückschau

12. November 2010 um 19:27 Keine KommentareProjekte im Web mit nachhaltigen „Wow!-Effekt“ bei mir innerhalb der letzten 8 (23) Jahre:

- Wikipedia

- ab etwa 2002

- LibraryThing

- ab etwa 2006

- OpenStreetMap

- ab etwa 2008

- Stack Exchange (Stack Overflow u.A.)

- ab etwa 2010

- Anteil dieser Projekte, bei denen die Anwender nicht als Konsumenten oder Kunden, sondern als essentielle Mitarbeiter ernstgenommen werden:

- 100%

- Anteil dieser Projekte, die Inhalte unter einer Freien Lizenz (mindestens CC-BY-SA) bereitstellen:

- 100%

Mit besseren Community-Funktionen und wenn git nicht so kompliziert wäre, käme als weiterer Kandidat Github in Frage. Aus der Zeit vor dem WWW ist noch das Usenet zu nennen.

Programme zur Annotation von PDF-Dateien

14. Oktober 2010 um 21:59 9 KommentareDie anhaltende Verbreitung des seitenorientierten Portable Document Format (PDF) kann ich als Informationswissenschaftler als reaktionäres Phänomen zur fortschreitenden Digitalisierung von Dokumenten ansehen, Mittelfristig wird sich der Dokumentbegriff von traditionellen Konzepten wie „Original“ und „Seite“ lösen. Hier und jetzt lassen sich PDF-Dateien aber nicht vermeiden und sind zudem ein relativ einfache Methode, Texte so zu verbreiten, dass sie beim Empfänger auch so ankommen, wie es sich der Autor gedacht hat.

Im Gegensatz zum Papier fehlt PDF-Dateien aber oft die einfache Möglichkeit, Anmerkungen, Korrekturen und Kommentare anzubringen. Dies ist im PDF-Format zwar vorgesehen, aber den meisten PDF-Viewern fehlt diese Funktion. Zudem ist das Annotieren von Texten am Bildschirm nicht so Bequem wie auf Papier, was sich mit besseren Lesegeräten aber schnell ändern kann. Praktisch wäre auch ein etabliertes Dateiformat, um nur die Anmerkungen platzsparend getrennt von ihrer PDF-Datei weitergeben zu können. Ich habe mal ein wenig recherchiert, was es für Programme gibt, mit denen PDF-Dateien kommentiert werden können. Die Kommentare sollten dabei gespeichert und weitergegeben werden können, so dass sie mit jedem gängigen PDF-Viewer lesbar sind.

Wie hier beschrieben beinhaltet Apples Standard-PDF Reader unter OS X die Möglichkeit, Anmerkungen an PDF-Dateien anzubringen. Unter iPhone und iPad bietet anscheinend das Programm Aji Annotate PDF ähnliche Funktionen, allerdings habe ich nicht ausprobiert, ob die Anmerkungen auch direkt im PDF gespeichert werden, so dass sie bei Weitergabe der Datei verfügbar sind (das Programm kostet 4 Euro).

Für Windows habe ich zwei PDF-Reader mit Kommentarfunktion gefunden. Abgesehen von der Adobe-PDF-Suite, die für den Privatgebrauch viel zu teuer ist, gibt es Foxit PDF (download) und PDF-XChange Viewer. Beide Programme sind kostenlos, besitzen aber erweiterte Versionen, die man sich dazukaufen kann – zum einfachen Anmerken von Dokumenten sollte es auch so reichen. Außerdem gibt es noch PDF Annotator in der 60-Tage Testversion.

Für Linux sah es lange Zeit schlecht aus; neben einer Version des proprietären Foxit Reader, gibt es das Programm Xournal (siehe Bericht). PDF-Dateien können in Xournal allerdings nur als Hintergrundbild geladen, also beispielsweise nicht durchsucht werden, aber die Anmerkungen lassen sich direkt im PDF speichern. Beim Öffnen mit dem Ubuntu-PDF-Viewer Evince sind die Anmerkungen zwar sichtbar, können aber nicht gezielt durchblättert oder ein- und ausgeschaltet werden, weil sie von Xournal nur als normaler Teil des Dokumentes gespeichert werden. In Evince selber wird momentan die Unterstützung für Anmerkungen eingebaut (bzw. ist teilweise schon ab Gnome 2.28 vorhanden), aber die Anmerkungen werden nicht im PDF selber gespeichert. Schade, das ist für mich ein Ausschlußkriterium, mir jetzt schon ein Linux-basiertes Tablet zuzulegen.

Eine passende Webanwendung ist a.nnotate.com. Die PDF-Datei wird hier hochgeladen und kann dann online bearbeitet und mit Anmerkungen heruntergeladen werden. Allerdings sind nur 30 Seiten pro Monat kostenlos.

Und natürlich kann man die PDF-Datei auch ausdrucken, darin herumkritzeln und anschließend ggf. wieder einscannen. Was benutzt ihr um PDF-Dokumente zu kommentieren, z.B. zum Korrekturlesen?

P.S: I summarized some ideas on how to express and exchange annotations in a new project to extract/merge PDF annotation in XFDF format. There is also an overview of existing works on annotation and the „beyond the PDF“ projects collects ideas.

P.P.S: Interessant in diesem Zusammenhang ist auch die Möglichkeit, Anmerkungen per elektronischem Stift anzubringen, z.B. mit dem CoScribe Smartpen.

Befremdliches, Allzumenschenverachtendes: Ein Katalogisat für feige Geister

24. September 2010 um 16:57 1 KommentarAxel Schaper hat in netbib über die Verwendung des SWD-Schlagwort Überfremdung zur Beschreibung von Sarrazins Buch geschrieben, für das ja in Spiegel, Bild & Co eifrig Werbung gemacht wurde. Anscheinend hat sich da jemand bei der Katalogisierung nichts bei der Übernahme von rechtem Vokabular gedacht, und das Unwort des Jahres 1993 als offizielles Sach-Schlagwort eingeführt.

Dass Medien und Politiker dabei helfen, bislang geächtete, menschenverachtende Rhetorik zu verbreiten, ist ja schon schlimm genug – aber Bibliotheken?! Ich hoffe, dieser peinliche Fehler wird wieder rückgängig gemacht. Stattdessen könnten Bibliotheken viel besser zur Versachlichung und Aufklärung beitragen, indem sie Bücher zu Integration und Fremdenfeindlichkeit aktiv herausstellen. Bibliotheken könnten sich zudem zu Recht als zu einer guten Integration Beitragende bekannter machen. Warum sind Bibliotheken so ängstlich?

Zugegeben: Katalogisierung ist subjektiv und nicht einfach. Aber Begriffe wie „Neger“ sind als Schlagwort zur inhaltlichen Erschließung von Büchern zu Recht auch nicht mehr gebräuchlich. In den USA gibt es eine ausgeprägtere Kultur des kritischen Katalogisierens, siehe zum Beispiel Radical Cataloging und Sorting things out.

Hier einige Alternativvorschläge aus der SWD: Rechtspopulismus, Soziale Ächtung, Ausländerfeindlichkeit, Islamophobie. Und weil es so schön und entlarvend ist, noch etwas von Karl Valentin und Liesl Karlstadt.

- Valentin

- Fremd ist der Fremde nur in der Fremde.

- Karlstadt:

- Das ist nicht unrichtig. – Und warum fühlt sich ein Fremder nur in der Fremde fremd?

- Valentin:

- Weil jeder Fremde, der sich fremd fühlt, ein Fremder ist und zwar so lange, bis er sich nicht mehr fremd fühlt, dann ist er kein Fremder mehr.

- Karlstadt:

- Sehr richtig! – Wenn aber ein Fremder schon lange in der Fremde ist, bleibt er dann immer ein Fremder?

- Valentin:

- Nein. Das ist nur so lange ein Fremder, bis er alles kennt und gesehen hat, denn dann ist ihm nichts mehr fremd.

- Karlstadt:

- Es kann aber auch einem Einheimischen etwas fremd sein!

P.S: Den Hinweis auf Axels Beitrag habe ich von Christian und von Lambert.

Is data a language? In search of the new discipline Data Linguistics

13. September 2010 um 01:24 33 KommentareYesterday Jindřich asked me for a reason to treat data as a language. I really appreciate this little conversations in data philosophy, but after a while 140 characters get too limited. Half a year ago a similar discussion with Adrian became a small series of blog articles (in German). I doubt that you can find a simple and final answer to fundamental questions about data and meaning, because these questions touch the human condition. This is also the reason why we should never stop asking unless we give up being human beings.

Jindřich’s question first made me wonder because for me data obviously is a language. All data is represented as sequence of bits, which can easily be defined as formal language. But this argument is stupid and wrong. Although language can be described by formal languages (as introduced by Noam Chomsky), this description only covers synax and grammar. Above all, a description of language must not be confound with language itself: the map is not the territory.

But data is used to communicate just like natural (written) language. The vast amount and heterogenity of data sometimes makes us forget that all data is created by humans for humans. Let me start with a simple argument against the view of data as language. A lot of data is created by measuring nature. As nature is not language, measured data is not language. This argument is also wrong. We (humans) design measuring devices and define their language (sic!) in terms of units like length, duration, blood pressure, and so forth. These units do not exist independent from language, but only communicated via it. And most units describe much more complex and fuzzy concepts like „name“, and „money“, which only exist as social construct. A piece of data is a statement that can be false, true, nonsense, or all of it, depending on context. Just like language.

Nowadays we create a lot of data for machines. Is this an argument against nature as language? I don’t think so. We may say that a piece of data made a machine to perform some task, but the machine was designed to act in a specific way. Machines do not „understand“ data, they just react. If I use an axe to cut a tree, I do not send the tree a message of data that it interprets to cut itself. Of course computers are much more complex then trees (and much simpler from another point of view). The chain of reaction is much more subtle. And most times there are more participants. If I create some data for a specific program, I do not communicate with the program itself, but with everyone involved in creating the program and its environment. This may sound strange but compare the situation with legal systems: a law is a piece of language, used to communicate to other people: „don’t step on the grass“. Unforunately society makes us think that laws are static and independent from us. In the same way people think that data is shaped by computers instead of people. Next time you get angry about a program, think about the vendor and programmer. Next time you get angry about a law, think about the lawmakers.

What follows from treating data as language? I think we need a new approach to data, a dedicated study of data. I would call this discipline data linguistics. Linguistics has many sub-fields concerned with particular aspects of natural language. The traditional division in syntax, semantics, and pragmatics only describes one direction to look at language. Anthropological linguistics and sociolinguistics study the relation between language and society, and historical linguistics studies the history and evolution of languages, only to mention a few disciplines. Suprisingly, the study of data is much more limited — up to now there is no data linguistics that studies data as language. The study of data is mainly focused on its form, for instance on the study of formal languages in computer science, the study of digital media in cultural studies and media studies, or the study of forms and questionnaire in graphic design and public administration (forms could be a good starting point for data linguistics).

There are some other fields that combine data and linguistics but from different viewpoints: computational linguistics studies natural language by computational means, similar to digital humanities in general. In one branch of data analysis, linguistic summaries of data are created based on fuzzy set theory. They provide natural language statements, that capture the main characteristics of data sets. Natural language processing analyses textual data by algorithmic methods. But data linguistics that analyses data in general is still waiting to be discovered. We can only conjecture possible reasons for this lack of research:

- Data is not seen as language.

- Digital data is a relatively new phenomenon. The creation of data on a large scale mainly began in the 20th century, so there is not enough time to historically explore the topic.

- In contrast to natural language, data is too heterogenious to justify a combined look at data in general.

- data seems to be well-defined, so no research is needed.

What do you think?

Aktuelle Diskussionen zur informationswissenschaftlichen Fachkommunikation

1. September 2010 um 12:42 2 KommentareIn der deutschsprachigen Biblioblogosphäre wird seit einigen Monaten verstärkt und gut mit Fakten und Argumenten unterlegt die Informationswissenschaftliche Fachkommunikation diskutiert. Ich möchte hier nur auf das neue Blog beyondthejournal.net von Lambert Heller und Heinz Pampel sowie auf den Diskussionsthread Bibliothekarische Fachkommunikation 2010 verweisen. Leider ist der Diskurs bislang sehr von Männern geprägt und wesentliche Stimmen fehlen. Ich denke, dass unter Anderem Wortmeldungen aus der Richtung von LIBREAS und von der Zukunftswerkstatt die Diskussion um weitere Gesichtspunkte bereichern dürften. Es fehlen aber auch Stimmen aus der analogen (gedruckten) Welt. So einfach lässt sich die Frage, wie und wo Fachleute aus Informationseinrichtungen kommunizieren, und was dabei wissenschaftliche Fachkommunikation ist, nämlich nicht beantworten.

In der vorigen (Heft 07-08/2010) und aktuellen Ausgabe (Heft 09/2010) der Fachzeitschrift Password ist ein Artikel erschienen, der sich kritisch mit der Informationswissenschaft und ihrer Publikationspraxis auseinandersetzt. Dazu wird exemplarisch auf die Proceedings des 11. Internationalen Symposions für Informationswissenschaft (ISI2009) eingegangen. Die Vortragsfolien der ISI2009 sind auf der Tagungshomepage unter CC-BY-SA verfügbar, während der Tagungsband nur auszugsweise und verstreut auf verschiedenen Repository-Servern zu finden ist. Dass es das deutschsprachige Bibliotheks- und Informationswesen bis heute weder geschafft hat, seine Publikationen direkt, noch die dazugehörigen Metadaten in geeigneter Weise ins Netz zu bringen, sagt schon einiges über ihren Zustand aus.

Auch der Artikel (bzw. die Artikelserie) „Kritik der Informationswissenschaft. Anmerkungen eines interessierten und besorgten Bürgers mit Common Sense“ des Password-Chefredakteurs Willi Bredemeier (@WilhelmHeinrich bei Twitter) ist nicht bzw. für Abbonnenten bislang nur teilweise online frei verfüg- und verlinkbar. Dies mag ein Grund sein, weshalb er in der Biblioblogosphäre noch nicht rezipiert wurde. Bredemeier verortet die Informationswissenschaft in den Geisteswissenschaften, wo ein additiver Erkenntnisgewinn selten möglich ist. Stattdessen sollte die Informationswissenschaft nach ihrer pragmatischen Relevanz bewertet werden. Angesicht der sich momentan technisch und gesellschaftlich vollziehenden Wandels wäre eine Relevanz der Informationswissenschaft eigentlich gegeben. Leider wird die (bzw. zumindest die deutschsprachige?) Informationswissenschaft ihrem eigenen Anspruch jedoch nicht gerecht: sie bringt – wie Bredemeier kritisiert – vor allem irrelevante und triviale Ergebnisse hervor, zerschnipselt Themen zu Mini-Fragestellungen, beschränkt wissenschaftliche Veröffentlichungen auf einzelne Forschungsphasen, produziert wissenschaftliche Beiträge als Nebenprodukt teilweise interessengeleiteter anderer Aktivitäten und besitzt keinen funktionierenden Peer-Review-Prozess.

Wer über seine Einrichtung die Password abbonniert hat sollte sich die Artikel durchlesen. Vielleicht kann sich Herr Bredemeier ja dazu durchringen seine Beitrag zur Diskussion um die informationswissenschaftliche Fachkommunikation auch online frei verfügbar und dauerhaft verlinkbar zu machen – am besten auf einem Dokumentenserver. Sein ebenfalls empfehlenswerter Artikel Zur mangelnden Funktionsfähigkeit von Fachinformations- und Fachzeitschriftenmärkten ist auf seiner Homepage einsehbar und bietet eine gute Ergänzung zu Lambert Hellers Blogartikel „Status Quo: Fachblogs — „Amateure“ erschließen das Web als Informationsraum„.

Das Internationales Symposium für Informationswissenschaft 2011 finden übrigens vom 9. bis 11. März 2011 in Hildesheim statt, der Call for Papers läuft noch bis zum 25. Oktober. Hoffentlicht nimmt das Programmkommitee Bredemeiers Kritik am Programm der vorigen Tagung zumindest zur Kenntnis.

Das Brennglas des Martin Schrettinger

23. August 2010 um 20:08 2 KommentareIm 1829 erschienenen 2. Band des „Versuch eines vollständigen Lehrbuches der Bibliothek-Wissenschaft“ habe ich unter der Zwischenüberschrift „Ist also alles systematisieren unnütz und zweckwidrig?“ ein schönes Zitat von Martin Schrettinger gefunden:

Ein systematischer Katalog wäre demnach einer optischen Maschine zu vergleichen in welcher alle Arten von Brenngläsern nach den Graden ihrer Konvexität nach den Verhältnissen ihrer Dimensionen und ihrer mehr oder minder Zirkel oder länglicht runden oder eckigten Form in Gestalt eines Stammbaumes über und neben einander systematisch geordnet und in dieser Ordnung befestigt wären oder wenn man lieber will einem Universal-Brennglase in welchem so viele Unterabtheilungen in systematischer Ordnung eingeschliffen wären dass durch die selben alle erdenklichen Grade von Brennpunkten erzielt werden sollten.

Ab dem zweiten Band plädierte Schrettinger wie bereits Albrecht Christoph Kayser in „Ueber die Manipulation bey der Einrichtung einer Bibliothek und der Verfertigung der Bücherverzeichnisse“ (1790) gegen einen systematischen Katalog, da dieser immer nur eine Sicht darstellen könne. Dass es einmal ein „Universal-Brennglase“ geben würde, durch das sich alle erdenklichen Grade von Brennpunkten erzielen lassen, konnte er sicher nicht ahnen. Mit etwas Fantasie lässt sich Martin Schrettinger nicht nur als Vorreiter des Social Tagging sondern auch von Linked Data (d.h. der beliebigen Rekombinierbarkeit von Katalogbestandteilen) ansehen.

Schrettinger und Kayser konnten sich unter den Bibliothekaren jedoch nicht durchsetzen – stattdessen dominierte Friedrich Adolf Ebert die weitere Entwicklung in Deutschland. Mehr zur frühen Geschichte des Katalogs findet sich bei Uwe Jochum, u.A. in „Die Idole der Bibliothekare“ (1995), Kapitel 3. Gut, dass sich viele von Jochums Texten trotz seiner Kritik an Open Access frei im Netz finden lassen (Weshalb – wie er argumentiert – durch die freie Verfügbarkeit von Publikationen die Forschungsfreiheit gefährdet sein soll, habe ich bislang nicht verstanden. Ich denke ab dieser Stelle findet sich eine Antwort im Eigentumsbegriff, über den sich an anderer Stelle streiten lässt).

P.S: Ein schöner Verriss von Schrettingers Handbuchs gab es in der Jenaischen Allgemeinen Literaturzeitung vom April 1821. Der Rezensent kritisiert (zu Recht), wie sich Schrettinger bezüglich des systematischen Katalogs selbst widerspricht.

What is Semantic Information Retrieval?

19. August 2010 um 00:45 Keine KommentareThe most fun part of my dissertation is when I can procastinate dig deeply to the foundation of computer and information science. Lately I tried to find out when the terms „file“ and the „directory“ were coined in its current sense. The first commercial disk drive was the IBM 350, introduced in 1956. It had the size of a wardrobe, stored 4.4 megabytes 6-bit-characters and could be leased for 3,200$/month. Instances of it were also called „files“. But user files first appeared in the early 1960s with the Compatible Time-Sharing System (CTSS), the earliest ancestor of Unix. You should watch this great video from 1964 in which Robert Fano talks about making computers accessible to people. A wonderful demonstration of one of the very first command lines of a multi-user system! The explicit aims and concepts of computer systems are very similar to today. The more I read about history of computing, the more it seems to be that all important concepts were developed in the 1960s and 1970s. The rest is just reinventing and application on a broader scale.

Robert Fano was director of project MAC, a laboratory that brought together pioneers in operating systems, artificial intelligence, and other areas of the emerging discipline computer science. I browsed the historical publications of the laboratory at MIT where you can find a report of CTSS. Also published at MAC in 1964, I stumbled upon Bertram Raphael’s PhD thesis. It is titled SIR: A COMPUTER PROGRAM FOR SEMANTIC INFORMATION RETRIEVAL and its abstracts sounds like todays Semantic Web propaganda:

This system demonstrates what can reasonably be called an ability to „understand“ semantic information. SIR’s semantic and deductive ability is based on the construction of an internal model, which uses word associations and property lists, for the relational information normally conveyed in conversational statements. […] The system has some capacity to recognize exceptions to general rules, resolve certain semantic ambiguities, and modify its model structure in order to save computer memory space.

The SIR expert system even seems to go beyong current RDF techniques in supporting exceptions. By the way Bertram Raphael was at MAC at the same time as Joseph Weizenbaum. Weizenbaum fooled expectations in articial intelligence with his program ELIZA that he created between 1964 and 1966. He later became an important critic of artificial intelligence and the application of computer technology in general. By the way we need more like him instead of well-meaning, megalomaniac technology evangelists. See the documentary Rebel at work about Weizenbaum or even better the promising film Plug & Pray!

So what is Semantic Information Retrieval? In short: bullshit. The term is also used independently for search indices on graph structured data (2009), digital libraries (1998) and more. But why bothering with words, meaning, and history if computers will surely „understand“ soon?

Tagging von OpenAccess-Artikeln mit Wikipedia

5. August 2010 um 07:38 5 KommentareZur Zeit bekomme ich nur am Rande die tollen Beiträge der Biblioblogosphäre wie Ethik von unten und die Übersicht von Repository-Upload-Formularen mit, da ich intensiv an der Dissertation sitze (siehe meine Literatur). Lamberts Vorschlag Wikipedia zur Sacherschließung von Open Access zu nutzen, möchte ich jedoch nicht unkommentiert lassen.

Die Grundidee ist folgende: Wissenschaftliche Literatur aus Open Access Repositorien lässt sich 1.) direkt verlinken 2.) im Volltext analysieren und 3.) zur automatischen Erzeugung von Literaturangaben verwenden. Dagegen steht, dass die Sacherschließung dürftig ist und Artikel oft sehr speziell sind. Wikipedia ist dagegen ebenso für 1-3 verfügbar und bietet einen guten (manchmal sogar ausgewogenen) Einstiegspunkt in ein Thema – es fehlt jedoch oft an weiterführenden Hinweisen auf aktuelle Literatur. Lambert schlägt nun eine Webanwendung vor, in der Nutzer Wikipedia-Artikel und Open-Access Artikel einander zuordnen können. LibraryThing hat vorgemacht, dass Sacherschließung nicht dröge sein muss, sondern durch spielerische Anreize gute Ergebnisse liefert. Deshalb sollte die Sacherschließung mit Wikipedia auch möglichst einfach als Spiel umgesetzt werden. Die Webanwendung könnte sowohl von einer eigenen Seite als auch als Widget direkt aus Wikipedia und aus OA-Repositorien oder Suchmaschinen benutzt werden und sollte mit möglichst wenigen Klicks (im Idealfall nur ein einziger!) zu bedienen sein. Durch Auswertung der Volltexte können mit herkömmlicher Suchmaschinentechnologie (z.B. Solr oder Maui) von OA-Artikeln bzw. Wikipedia-Artikeln ähnliche Artikel der jeweils anderen Textgattung vorgeschlagen werden. Nutzer können dann die Vorschläge als passend oder als unpassend bewerten.

Ich stelle mir die Bewertung ähnlich wie bei Stackoverlow vor (siehe Screenshot-Ausschnitt rechts). Nutzer können dort Reputations-Punkte für verschiedene Aktionen bekommen (oder verlieren) – siehe Stackoverflow-FAQ. Für das Hinzufügen eines nicht-automatisch vorgeschlagenen Artikels könnte es z.B. mehr Punkte geben als für das Bestätigen eines bereits vorhandenen Artikels, so dass zusätzliche Recherchen belohnt werden. In jedem Fall sollte die Weiterentwicklung der Idee erstmal mit der Benutzeroberfläche beginnen anstatt gleich über technische Möglichkeiten nachzudenken. Eine Übersicht von Webanwendungen für User-Interface Mockups gibt es hier. Papier oder Tafel und Stift reichen aber auch aus. Wichtig ist nur, dass das Design nicht von Fragen wie „wie setze ich das in HTML um?“ oder „wo und wie sollen die Daten gespeichert werden?“ beschränkt wird.

Ich stelle mir die Bewertung ähnlich wie bei Stackoverlow vor (siehe Screenshot-Ausschnitt rechts). Nutzer können dort Reputations-Punkte für verschiedene Aktionen bekommen (oder verlieren) – siehe Stackoverflow-FAQ. Für das Hinzufügen eines nicht-automatisch vorgeschlagenen Artikels könnte es z.B. mehr Punkte geben als für das Bestätigen eines bereits vorhandenen Artikels, so dass zusätzliche Recherchen belohnt werden. In jedem Fall sollte die Weiterentwicklung der Idee erstmal mit der Benutzeroberfläche beginnen anstatt gleich über technische Möglichkeiten nachzudenken. Eine Übersicht von Webanwendungen für User-Interface Mockups gibt es hier. Papier oder Tafel und Stift reichen aber auch aus. Wichtig ist nur, dass das Design nicht von Fragen wie „wie setze ich das in HTML um?“ oder „wo und wie sollen die Daten gespeichert werden?“ beschränkt wird.

Neueste Kommentare