Mehrere Adressbücher in Thunderbird

29. Juli 2007 um 21:01 1 KommentarObwohl es anscheinend schon mal ging, kann ich in Thunderbird (Version 2.0.0.5 für Linux) keine neues Adressbuch über Datei>Neu>Adressbuch anlegen. Wem ein „Persönliches Adressbuch“ und „Gesammelte Adressen“ nicht genug sind, der kann aber weitere Adressbücher anlegen, indem er über Extras>Exportieren ein vorhandenes Adressbuch exportiert, die Exportdatei danach umbenennt und anschließend über Export>Importieren das Adressbuch importiert. Über den Export kann ein Adressbuch auch in eine Tabellenkalkulation oder andere Datenbanken importiert werden – gerade bei größeren Datenmengen (mein Adressbuch umfasst mitlerweile über 500 Einträge) ist die Bearbeitung und Weiterverarbeitung dort besser möglich. Was mir trotz des zwingend notwendigen Plugins MoreColsForAddressBook noch fehlt ist die Möglichkeit, Kontakte mit einem Bild zu versehen und Links auf Profile bei verschiedenen anderen Diensten zu setzen, so wie die „Also on “ Connections bei LibraryThing. FOAF-Support wäre auch nicht schlecht.

Vortrag zum Tagging

27. Juli 2007 um 11:35 Keine KommentareDie Unterlagen zum Vortrag Towards integration between collaborative tagging and professional indexing von Traugott Koch am 26.6.2007 im Berliner Bibliothekswissenschaftlichen Kolloquium sind nun Online. Ich finde die analytische Zusammenstellung des Themas sehr bereichernd und hilfreich für weitere Studien – und dass die Forschung noch sehr am Anfang steht, hat Traugott gut dargestellt.

Von ISBD zum Web 2.0 mit Mikroformaten

26. Juli 2007 um 14:18 15 KommentareDen folgenden Beitrag habe ich bereits in ähnlicher Form in INETBIB gepostet. Um ihn in die Blogosphäre einzubinden, poste ich ihn hier nochmal als Blogeintrag.

Um sich nicht im Sommerloch langweilen zu müssen, habe ich hier eine kleine Aufgabe für ISBD-Experten, Bibliothekare und andere Zukunftsinteressierte: Es geht um nicht weniger als die die Entwicklung eines bibliothekarischen Datenformates. Da der Beitrag etwas länger ist, hier eine

Zusammenfassung

1. Im Web sind mehr und mehr Daten direkt und in standardisierten Formaten zur Weiterverarbeitung verfügbar

2. Durchsetzen wird sich am Ende das, was im Browser ohne Plugin unterstützt wird

3. So wie es aussieht, werden dies Mikroformate sein

4. Für Bibliographsche Daten fehlt bislang ein Mikroformat

5. Wenn sich Bibliothekare nicht mit ihrem Sachverstand an der Entwicklung eines solchen Formates beteiligen, tun es andere – und das nicht unbedingt nach bibliothekarischen Gesichtspunkten.

Worum geht es?

Beitrag Von ISBD zum Web 2.0 mit Mikroformaten weiterlesen…

Förderpreis für Suchmaschinen

26. Juli 2007 um 11:40 Keine KommentareDer Gemeinnützige Verein zur Förderung der Suchmaschinen-Technologie und

des freien Wissenszugangs (SuMa e.V.) schreibt mit dem SuMa Awards 2008 einen Förderpreise für Suchmaschinen aus. Für seine Bemühungen Alternativen zu Google aufzuzeigen und umzusetzen musste Herr Sander-Beuermann schon einige Häme einstecken – jetzt können die Kritiker also beweisen, dass sie es besser können.

Nach den bisherigen Informationen beschränkt sich der Wettbewerb nicht nur auf technische Realisierungen – auch wirtschaftliche und künstlerische Auseinandersetzungen sind gefragt. Mich würde beispielsweise interessieren, was an Semantic Web und Suchagenten wirklich dran ist und wie personalisierte Suchdienste das Suchverhalten verändern – werden wir ohne Internet bald an digitalem Alzheimer leiden? Am Wettbewerb kann also jeder vom Studenten bis zur Forschungsgruppen teilnehmen.

Unter SuMa-Lab.de zeigt der Verein einige existierende Projekte, daneben ist sicherlich A9 einen Blick wert. Eine Suchmaschine muss auch nicht von Grund auf neu programmiert werden, sondern kann mit etablierten Techniken (OpenSearch, SRU, OAI, RSS etc.) vielleicht sogar einfach zusammengeklickt werden – ob kleine Lösungen wie Planet Biblioblog den Hauptpreis bekommen, weiß ich nicht aber mit vielen solcher kleinen Lösungen („Webservices“) ist sicherlich mehr zu erreichen als mit dem Versuch eines dicken Google-Clons. Vergleichbare Wettbewerbe (allerdings mehr technik-zentriert) gab es übrigens schon bei Talis (Mashing Up The Library competition) und bei OCLC (OCLC Research Software Contest).

Open Library Project: Wikipedia der Kataloge

23. Juli 2007 um 14:35 3 KommentareEin freies Projekt zur Katalogisierung aller jemals erschienenen Publikationen war ja abzusehen, aber dass es so schnell geht, hat mich doch überrascht. Das letzten Montag bekanntgegebene Open Library Project ist eine vom Internet Archive unterstütze Initiative, nach dem Wikipedia-Prinzip einen frei editierbaren Katalog zu schaffen. Die Software ist Open Source, kann also auch lokal installiert werden. Als Suchmaschine wird anscheinen Lucene-Solr verwendet. Einen Überblick gibt es eine Guided Tour und die System-Dokumentation.

Wenn man sich die Beteiligten und weitere Personen auf den Mailinglisten zum Projekt (Ol-lib, Ol-discuss, Ol-tech) ansieht, so sieht das Projekt sehr vielversprechend aus. Geleitet wird das Projekt von Aaron Swartz, und Tim Spaling (LibraryThing) ist dem Projekt auch wohlgesonnen.

Verwandte Projekte zur gemeinsamen Katalogisierung sind LibraryThing sowie Social Bookmarking-Dienste wie CiteULike, Connotea und BibSonomy und von Content-Seite Project Gutenberg sowie das weniger freie Google Books. Als größten Partner oder Konkurrenten – je nachdem aus welcher Richtung betrachtet – sehe ich allerdings WorldCat. Die aus der Wikipedia-Community hervorgebrachten Ansätze finde ich nicht so relevant, wenngleich Wikipedia natürlich eingebunden werden sollte.

Wie schon LibraryThing ist das Open Library Project bislang ausschließlich Englisch und nicht für Mehrsprachigkeit konzipiert (auch bei LibraryThing ist nur Oberfläche mehrsprachig, während die Tagging-Daten und Texte einsprachig sind). Wenn sich das Open Library Project ein Beispiel an Wikipedia nehmen will, sollten sprachabhängige Bestandteile besser in eigene Komponenten ausgelagert werden.

Und was bedeutet das ganze für die Bibliotheken?: In spätestens 5 Jahren werden alle wesentlichen Katalogdaten frei sein, zu einem wesentlichen Teil nicht mehr ausschließlich von Bibliothekaren erstellt werden und verschiedene Anbieter werden Suchfunktionen über diese Daten bereitstellen. Auf diesen Wandel sollte sich das Bibliothekswesen einstellen.

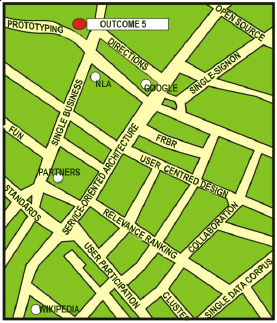

Entwicklungen an der Nationalbibliothek von Australien

23. Juli 2007 um 10:10 Keine KommentareDie Nationalbibliothek von Australien (NLA) hat vor einiger Zeit einen sehr ansehnlichen Lucene-basierten Katalog-Prototypen veröffentlicht. Dass die NLA zukunftsweisende Entwicklungen betreibt, zeigt auch die geospatial search (deren Eingabemaske allerdings nicht sehr komfortabel ist) und den im März diesen Jahres veröffentlichten National Library of Australia IT Architecture Project Report auf den ich hiermit hinweisen möchte. Den folgenden Absatz aus dem Report könnte ich direkt unterschreiben:

The benefits of having a native level of support for standard protocols in the architecture cannot be overestimated. A standards-based service-oriented approach for core services such as Contribute, Alert, Harvest and Request will allow protocols such as SRU Update, RSS, OAI-PMH and OpenURL to be supported across all applications. It will also ensure that these protocols are part of the Library’s way of thinking when training new staff or prototyping new requirements; and that gaps in standards are identified and addressed through a testbed approach, as part of the development process.

Übrigens setzt die NLA wie der GBV auch als Zentralsystem das CBS von OCLC PICA ein.

Streit um Theseus: wohin mit 120 Millionen?

20. Juli 2007 um 15:36 2 KommentareWie am 19.7 mittgeilt wurde ist das EU-Suchmaschinen-Großprojekt Theseus bewilligt worden. Der Gemeinnützige Verein zur Förderung der Suchmaschinen-Technologie und des freien Wissenszugangs e.V. (SuMa-eV) regt sich darüber auf (siehe Pressemitteilung), allerdings dummerweise aus den falschen Gründen.

Es ist nämlich viel eher beklagenswert, dass ohne verbindliche Vorgaben 120 Millionen Euro der Großindustrie (Empolis GmbH, der SAP AG, der Siemens AG und der Deutsche Thompson oHG) in den Rachen geworfen werden, die dafür bunte Luftblasen („Web 3.0“) erzeugt und große Versprechungen à la Transrapid und Mautsystem gemacht werden. Die Panikmache des Suma e.V. kann ich allerdings nicht ganz nachvollziehen. Dass auf „Semantische Technologien“ statt auf eine Google-Kopie gesetzt wird, ist nämlich der richtige Weg – nur muss dieses Buzzword in der Praxis auch richtig ausgefüllt werden, was ich bei der vorliegenden Ausgangslage stark bezweifle.

Die 120 Millionen wären viel besser angelegt, wenn damit zu einem Teil bereits bestehende OpenSource-Initiativen im Suchmaschinen- und Semantic-Web-Bereich unterstützt werden und mit dem Rest digitalisiert und annotiert wird (sei es in Wikipedia, LibraryThing & Co oder durch Bibliotheken und Digitalisierungseinrichtungen). Eine interessante Anwendung der „semantischen Technologien“ wäre es übrigens mal all die beteiligten Projektpartner, Firmen und Personen mit ihren Geschäftsbeteiligungen und Verstrickungen transparent zu erschließen, um zu erfahren, wer hier wem in die Tasche wirtschaftet.

Nachtrag: in der Englischsprachigen Blogosphäre gibt es bereits über ein Dutzend Beiträge zu Theseus. Besonders gefallen hat mir Galileo of the internet, der auch noch die besondere Europäische Komponente dieser Geldverschwendung darlegt:

But nothing symbolises the divide between old Europe and the New World. Whereas Google is a testament to the power of free enterprise, set up by Larry Page and Sergey Brin, then PhD students at Stanford University, the European version is a multi-million project, heavily subsidised by the German and French governments, and developed by some of the largest corporate giants in Europe.

Zotero, COins und technische Kompetenz in Bibliotheken

19. Juli 2007 um 23:22 2 KommentareDas Firefox-Literaturverwaltungs-Plugin Zotero wurde schon vor einigen Monaten in verschiedenen Bibliotheks-Weblogs genannt und unter Anderem auf e-teaching.org vorgestellt; da es Firefox 2.0 voraussetzt, habe ich es mir aber erst jetzt ein wenig näher angesehen.

Zotero erkennt auf vielen Webseiten bibliographische Angaben, so dass sie mit einem Mausklick in die eigene Literatursammlung übernommen werden können. Darunter sind auch Bibliothekskataloge, allerdings bislang noch keine aus Deutschland. Das ist allerdings auch nicht verwunderlich, denn wer sollte die Anbindung an Zotero auch umsetzen wenn nicht die so genannten „Web 2.0“-Experten mit bibliothekarischem Umfeld?

Soweit ich es verstanden habe, genügt für Zotero, bei der Titelanzeige in die HTML-Seite OpenURL-Daten mittels COins (ContextObjects in Spans) einzufügen. COins sind nicht nur für Zotero von Bedeutung sondern wird bereits jetzt als allgemeines Mikroformat für bibliographische Daten eingesetzt (die Microformats-Community werkelt derweil dennoch an einem eigenen Standard herum).

Da COins auf OpenURL basiert, dürfte es bei Katalogen, die bereits OpenURL als Source für Linkresolver unterstützen, einfach sein, auch COins anzubieten. Dies ist nebenbei bemerkt auch ein Beispiel dafür, wie wichtig es ist, dass Bibliotheken die technische Kompetenz zur Entwicklung ihrer OPACs selbst benötigen anstatt die Katalogsoftware bei einem Hersteller einzukaufen ohne selber daran herumzuskripten. Denn obwohl die Einbindung von COins technisch nicht aufwendig ist, hat ein herkömmlicher kommerzieller Hersteller in der Praxis dazu weder die Möglichkeit (außer er hat direkten Zugang zum Katalogserver) noch den Anreiz (außer er bekommt einen expliziten, bezahlten Auftrag). Die Bibliothek selber kann aber ohne die technischen Fähigkeiten, weder mal eben etwas wie COins selber in die eigenen Katalogsoftware integrieren, noch seinem Softwarehersteller früh und konkret genug sagen, was dieser genau umsetzen soll – und bekommen dann deshalb irgend etwas unzureichendes als „Web 2.0“ verkauft.

P.S.: Wie infobib mitteilt ist seit kurzem die Institutsbibliothek der Saarländer Informationswissenschaft schon soweit – ist ja auch kein Produkt von der Stange.

Bibliotheks-Mashups mit Hürden auf dem Vormarsch

13. Juli 2007 um 18:06 8 KommentareWie von Patrick und im BibSonomy Blog berichtet wurde, bietet der Kölner UniversitätsGesamtkatalog (KUG) seit kurzem den Export von Datensätzen in das Kasseler Social-Cataloging-System Bibsonomy an. Als gemeinsames Datenformat fungiert BibTeX, das neben Dublin Core trotz einiger Probleme im Gegensatz zu Spezialformaten wie MARC und MAB De-facto-Standard für solche Anwendungen ist.

Prinzipiell kann jede Bibliothek, die BibTeX exportieren kann, den gleichen Service anbieten. Die Übergabe an BibSonomy funktioniert über eine einfache REST-API, die anscheinend in Kürze veröffentlicht werden soll. Die URL-Syntax is

http://www.bibsonomy.org/BibtexHandler?requTask=upload&encoding=ISO-8859-1&selection=…BibTeX-Datensatz…

Welche Zeichenkodierungen neben ISO-8859-1 noch möglich sind, weiß ich nicht; bislang werden auch sinnlose Werte anstandslos akzeptiert. Problematisch könnte es auch bei umfangreichen Datensätzen werden. Prinzipiell legt der HTTP-Standard zwar keine Längenbegrenzung für URLs fest, aber verlassen würde ich mich darauf nicht. Natürlich gibt es auch bei der Konvertierung noch einige Bugs, siehe zum Beispiel dieser Datensatz, bei dem die Keywords ziemlich durcheinander geworfen werden.

Dazu muss gesagt werden dass ein fehlerfreier BibTeX-Export komplizierter ist als angenommen. Der KUG wird mit der Software OpenBib betrieben, die – so sollte es sein – Open Source ist. Nach kurzer Recherche im Quelltext zeigt sich die Funktion normset2bibtex als Kernbestandteil der Konvertierung nach BibTeX. Mir ist neulich auch schon ein PICA+ nach BibTeX-Script über den Weg gelaufen, aber wenn jede Bibliothek und jeder Hersteller ihr eigenes kleines Skript schreiben, können bei der Konvertierung qualitativ keine großen Sprünge gemacht werden. Ein guter Kandidat für eine dauerhafte Lösung sind vielleicht die Bibutils bibliography conversion utilities, die als Intermediate-Format das Metadata Object Description Schema (MODS) verwenden und ebenso wie OpenBib unter der GPL zur Verfügung stehen. By the way: Warum werden von DFG & Co eigentlich laufend Anträge ohne technischen Sachverstand gefördert, bei denen am Ende nur unfreies Gewurstel rauskommt, anstatt konsequent auf Open Source zu setzen, damit am Ende alle etwas davon haben?

Und noch eine positive Überraschung brachte das Stöbern im Quellcode und der Dokumentation: Der OpenBib-Entwickler Oliver Flimm hat bereits 2005 mit den Open Library WebServices eine SOAP-Schnittstelle für Sisis-Systeme implementiert (siehe Dokumentation und Quellcode), die anscheinend direkt auf die SQL-Datenbank zugreift. Bisher hatte ich von Sisis-Systemen eher den Eindruck, dass sie mit Schnittstellen nicht so freizügig sind. Zwar gibt es beispielsweise schon seit längerer Zeit das Simple Library Network Protocol (SLNP), aber eine offene API-Dokumentation und freie Implementierungen von auf diese API zugreifenden Clients habe ich bisher nicht finden können.

Mit den Open Library WebServices können Benutzerdaten (Ausleihen, Vorbestellungen etc.) und über die interne Datenbank-ID eines Katalogdatensatzes der Medienstatus (Signatur, Exemplar, Standort, Status, Rueckgabe) sowie die vollständigen Titeldaten abgerufen werden. Um welches „nativen Kategorienschema“ es sich bei den Titeldaten handelt, kann ich leider aus Unkenntnis von Sisis-LBS-Systemen nicht sagen, vielleicht MAB2, aber dann sollte besser MABXML geliefert werden und die Konvertierungsroutine nach BibTeX wie oben angedeutet als eigenständiges MAB2-nach-BibTeX-Modul.

Jedenfalls ein großes Lob an Oliver Flimm für die Entwicklung von OpenBib. Ich hoffe, dass die Weiterentwicklung mehr in Richtung einer Serviceorientierten Architektur geht, indem einzelne Funktionen sauber getrennt und als Webservice gekapselt werden. So können Funktionen wie der BibTeX-Export und die Weiterreichung nach BibSonomy als Bausteine auch in anderen Katalogprojekten zum Einsatz kommen können, beispielsweise bei X-OPAC und E-LIB Bremen. Auch dort steckt eine Menge intelligenter Eigenentwicklung, aber noch werkelt jeder vor sich hin. Bei den Schnittstellen sollte deshalb, wie ich vor kurzem in INETBIB betonte, streng auf offene Standards gesetzt werden anstatt eigene Bastellösungen zu verwenden, dann klappt’s auch mit den Mashups.

Tagging, Umfrage, Buch, Vortrag

12. Juli 2007 um 00:22 4 KommentareDrei kleine Hinweise zum Thema Tagging:

1. Tobias Kowatsch führt für seine Abschlussarbeit eine Web-Experiment-Umfrage zum Thema Tagging durch. Die Auswahl fand ich teilweise etwas komisch aber ich bin ja nur Versuchsperson, also nehmt euch die 13 Minuten und probiert es selber aus!

2. Sascha Carlin hat ein Buch über Social Tagging geschrieben, das vermutlich auf seiner Diplomarbeit basiert. Ich bin gespannt und werde es nach Erscheinen mal genauer unter die Lupe nehmen.

3. Auf der GBV Verbundkonferenz im September werde ich unter anderem über Social Tagging und Bibliotheken und die konkreten Planungen zur Tagging-Unterstützung im GBV referieren.

Neueste Kommentare