Übersicht webbasierter Literaturverwaltung

9. April 2008 um 15:28 8 KommentareP.S.: Unter http://literaturverwaltung.wordpress.com gibt es inzwischen ein von Bibliothekaren betriebenes Portal zum Theme Literaturverwaltungsprogramme.

Einen Überblick über „Webbasierte Literaturverwaltung“ gab Thomas Stöber von der UB Augsburg in seinem Vortrag zusammen mit Astrid Teichert auf der INETBIB 2008. Das Thema ist eigentlich nicht neu, aber nicht jeder hat die Zeit und Muße, sich selber mit RefWorks, citeulike, Connotea und BibSonomy im Vergleich zu EndNote und Citavi zu beschäftigen – außerdem sollte man das Firefox-Plugin Zotero kennen.

Auf der einen Seite stehen die traditionellen, „geschlossenen“ Systemen (EndNote, Citavi), bei denen ein Nutzer für sich alleine bibliographische Daten sammelt und verwaltet. „Halboffene“ Systeme (EndNote Web, RefWorks) bieten als Webanwendungen zusätzlich die Möglichkeit, Daten für andere Nutzer freizugeben. Bei „Offenen“ Systeme ist der Nutzerkreis prinzipiell offen und alle bibliographischen Daten werden miteinander geteilt.

Die offenen Literaturverwaltungs-Systeme bieten neue Kooperationsmöglichkeiten im Bereich Forschung und Lehre, Stöber zitierte Lambert Hellers Hinweis auf die Möglichkeit „Informeller Gemeinschaftsbibliographien„. Dabei lassen sich aus seiner Sicht drei wesentliche Anwendungszenarien unterscheiden:

(1) Freigabe des eigenen Datenpools mit Lesezugriff, z.B. Literaturlisten für Lehrveranstaltungen, Bibliographien, eigene Schriftenverzeichnisse etc. (RefWorks…)

(2) Geschlossene Arbeitsgruppen arbeiten gemeinsam an Bibliographien (EndNote Web, BibSonomy…)

(3) Gemeinsamer, offener Datenpool (BibSonomy…)

Für die weitere Entwicklung stellen sich angesichts der rasanten Entwicklungen im Bereich webbasierter Literaturverwaltung folgende Fragen:

(1) Ist die offene, gemeinschaftliche Arbeiten an Bibliographien ein realistisches Modell für eine offene Wissenschaft? Laura Cohen spricht schon begeistert von „Social Scholarship (wobei meiner Meinung nach dabei eher Blogs von Bedeutung sind, siehe blogs as scholarship von Georgia Harper und als Beispiel Research Blogging). Viele Wissenschaftler möchten jedoch vermutlich nur ungern ihre Literaturlisten offenlegen (was meiner Meinung nach nicht unbedingt für die Qualität ihrer Forschung spricht).

(2) Sind OpenSource-Anwendung aktuell und zukünftig eine echte Alternative zu kommerziellen Systemen? Thomas Stöber konnte diese Frage nicht bejahen – ich denke vor allem bei der Usability hat OpenSource regelmäßig Probleme.

(3) Wie entwickeln sich Bibliographie-Verwaltungssysteme weiter? Zur Zeit ist eine Konvergenz der Funktionen zu beobachten, so dass sich die verschiedenen Systeme im Kern immer weniger unterscheiden.

In der anschließenden Fragerunde meldeten sich vor Allem die „üblichen Verdächtigen“ (Till Kinstler, Lambert Heller, Patrick Danowski) zu Wort – ich war zu sehr mit der Formulierung dieses Beitrags beschäftigt und kann der Einführung nichts wesentliches hinzufügen. Mir fehlte nur etwas Zotero. Herr Stöber wies darauf hin, dass sich das Programm in erstaunlich kurzer Zeit zu einer vollwertigen Literaturverwaltung entwickelt hat. Dem in der Diskussion gebrachten Hinweis auf die Notwendigkeit von Werbung und Benutzerschulungen kann ich mich nur anschließen.

P.S.: Eine tabellarische Übersicht von Programmen zur Literaturverwaltung gibt beim Max Planck Institut für Biochemie.

Pseudo-URIs als Identifikatoren für Normdaten der Deutschen Nationalbibliothek

7. April 2008 um 03:31 7 KommentareDie Deutsche Nationalbibliothek (DNB) hat anscheinend Ende März eine neue Katalog-Oberfläche online gestellt – der alte OPAC ist auch noch verfügbar. Dabei sind unter Anderem die Normdaten (SWD, GKD, PND) teilweise besser integriert. Ich warte ja schon seit einiger Zeit darauf, dass endlich richtige URIs vergeben werden, so dass sich Normdaten global referenzieren lassen. Bei der aktuellen Lösung ist aber leider einiges schiefgelaufen.

Was ist eine URI?

Die Diskussion zum Thema URI/URN/URL auf Inetbib hat mal wieder gezeigt, dass es beim Thema Identifikatoren oft Missverständnisse gibt. Die international allgemeine Form globaler Identifikatoren ist der „Uniform Resource Identifier“ (URI) bzw. die Erweiterung „Internationalized Resource Identifier“ (IRI). Sie sind in RFC 3986 und RFC 3987 standardisiert. Die Vergabe von UR regelt RFC 4395. Verschiedene URI-Schemata (gekennzeichnet durch den Teil einer URI bis zum ersten Doppelpunkt) sind jeweils mit einem eigenen Standard registriert und definiert, zum Beispiel URNs durch RFC 2141.

Viele URI-Schemata legen Namensräume und eigene Regeln zur Struktur und Vergabe von Identifikatoren fest. So zum Beispiel RFC 3406 für URNs und RFC 3044 für den URN-Namensraum urn:issn zur Abbildung von ISSNs. Durch die Formulierung von ISSNs als URI können diese bereits etablierten aber nur begrenzt nutzbaren Identifikatoren auch global genutzt werden, beispielsweise im Rahmen des Semantic Web. Während die Zeichenfolge „0024-9319“ sehr unterschiedliches identifizieren kann, weist „urn:issn:0024-9319“ eindeutig auf die amerikanische Ausgabe des MAD-Magazins hin.

Um welche Identifikatoren geht es?

Zur Identifikation von Personen (PND), Begriffen (SWD) und Körperschaften (GKD) gibt es im deutschen Bibliothekssystem seit vielen Jahren etablierte Normdaten. Abgesehen von wenigen Ausnahmen fristen diese Normdaten bzw. ihre Identifikatoren jedoch eher ein Schattendasein. Andere Identifikatoren, wie beispielsweise die Nummern von OCLC und der Library of Congress werden dagegen auch zunehmend von den „global players“ im Netz verwendet (von Google und LibrayThing). Wenn sie endlich mit URIs versehen und frei veröffentlicht würden, könnten die deutschen Normdateien ebenfalls weitere Verbreitung finden – oder andernfalls an Bedeutung verlieren.

Was hat die DNB falsch gemacht?

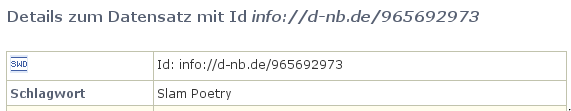

Anscheinend ist nun bei der Erstellung von Identifikatoren für Normdaten bei der Deutschen Nationalbibliothek gleich an mehreren Stellen etwas schief gelaufen. Dabei sieht es auf den ersten Blick ganz gut aus: Beim SWD-Eintrag „Poetry Slam“ ist beispielsweise dort als „Id“ die Zeichenkette „info://d-nb.de/965692973“ angegeben:

Ist das eine URI? Nein. In der offiziellen Liste von URI-Schemata ist „info:“ als gültiges URI-Schema eingetragen, das durch RFC 4452 definiert wird. Die dort festgelegte Maintenance Authority NISO hat die Verwaltung von Namensräumen an OCLC weitergegeben. Nun bekleckert sich OCLC mit dem seit Wochen nicht erreichbaren Verzeichnis der vergebenen Unternamensräume auch nicht gerade mit Ruhm, aber immerhin gibt es klare Standards (mehr Informationen bei der LOC). Eine info-URI ist aufgebaut nach dem Schema „info:NAMENSRAUM/LOKALTEIL„. Die Zeichenkette „info://d-nb.de/965692973“ kann also schon formal keine URI sein. Außerdem ist „d-nb.de“ nicht als gültiger info-URI Namensraum registriert. Zu allem Überfluss wird nicht auf die etablierten SWD-Nummern zurückgegriffen (die SWD-Nummer für den SWD-Datensatz ist „4709615-9“), sondern als lokaler Bestandteil die nicht standardisierte, systemabhängige PND-Nummer (hier: 965692973) verwendet!

Wie lässt sich der Schlamassel beheben?

Leider ist dies nicht das erste mal, dass sich die DNB im Internet lächerlich macht. Zum Glück lassen sich die Fehler relativ einfach beheben.

1. Die bereits existierenden „Standards“ für die existierenden Normdaten-Nummern werden explizit und verlässlich festgeschrieben, d.h. erlaubte Zeichen und Wertebereiche, Berechnung der Prüfziffer und Normalisierung (siehe LCCN-Normalisierung).

2. Die DNB reserviert für die Normdaten-Nummern einen URI-Namensraum (beispielsweise info:swd, info:pnd, info:gkd). Dabei sind die Regeln zur Syntax und Vergabe von URI-Schemata und Namensräumen einzuhalten. Internationale Standards sind zum Lesen und Einhalten da und nicht zum Ignorieren und Uminterpretieren.

3. Die URIs werden verständlich dokumentiert und propagiert. Die Kür wäre eine völlige Freigabe der Normdaten als öffentlicher Datenbank-Abzug unter einer freien Lizenz.

Zur Klärung der Konfusion bezüglich URI und URL sei auf die Artikel URIs, URLs, and URNs: Clarifications and Recommendations (via Kay Heiligenhaus) und On Linking Alternative Representations To Enable Discovery And Publishing hingewiesen.

P.S: Eine bibliotheksrelevante Anwendung von von Identifikatoren für Personen wurde letzte Woche von Arjan Hogenaar and Wilko Steinhoff im Vortrag Towards a Dutch Academic Information Domain auf der Open Repositories 2008 vorgestellt.

Aggregation von Metadaten aus Social Software-Diensten mit Aloe

3. April 2008 um 18:33 1 KommentarIm Vortrag „Sagt wer? Metadaten im Web“ auf der re:publica 08 sprach Martin Memmel darüber, „wie Daten von Experten, Maschinen und Endusern kombiniert“ werden können. Dabei stellte er das Projekt Aloe vor (link), in dem am DFKI Metadaten aus verschiedenen Quellen kombiniert und annotiert werden können. Alle Funktionen sind auch als Webservice verfügbar. Interessant sah die im Vortrag vorgestellte Tagging-Funktion aus, die Tag-Vorschläge aus mehreren Tagging-Diensten zusammenführt. Mehr dazu in den Vortragsfolien bei Slideshare.

Wirklich interessant werden solche aggregierenden Dienste meiner Meinung nach erst, sobald sich offene Standardformate zum Austausch von Kommentaren, Bewertungen, Tags etc. und anderen Metadaten durchsetzen. Bisher nicht bekannt in diesem Kontext war mir APML. Ein kritischer Punkt, der am Ende heftig diskutiert wurde, sind die Rechte an Metadaten und was juristisch und moralisch möglich und vertretbar ist. Ist es beispielsweise legitim, aus verschiedenen Social Networking-Plattformen soziale Graphen zusammenzuführen und weiterzugeben? Welche Rechte an Metadaten kann es überhaupt geben und welche lassen sich überhaupt durchsetzen? In jedem Fall spannend, wie es mit der Zusammenführung von Daten aus verschiedenen Diensten weitergeht.

Morgen nimmt Martin Memmel auch noch am Panel Social Media in der Wissenschaft teil, wo die „Möglichkeiten und Grenzen einer Wissenschaft 2.0“ diskutiert werden.

Review in Wikipedia mit markierten Versionen

2. April 2008 um 01:20 4 KommentareDie als „stabile Versionen“ diskutierte Erweiterung von Wikipedia um ein System zur Begutachtung nähert sich mühsam aber sicher ihrer Vollendung (siehe Ankündigung im Wikimedia-Deutschland-Blog und Beitrag von Tim). Zur Zeit kann die neue Funktion in einem Testwiki ausprobiert werden. Konstruktive Bugreports, Vandalismus-Tests und vor allem Hilfe bei der Verbesserung der Usability (!) sind gerne willkommen. Danach wird das System – möglichst noch diesen Monat – zunächst in der deutschsprachigen Wikipedia probeweise eingeschaltet. Und darum geht es:

Mit der neuen Funktion „markierte Versionen“ können einzelne Versionen eines Artikels markiert werden. Die Markierung als gesichtet zeigt an, dass kein Vandalismus vorhanden ist. Wenn zusätzlich jeweils zuerst die letzte gesichtete Version eines Artikels angezeigt wird, sollten offensichtlicher Blödsinn und Quatscheinträge in Wikipedia merklich abnehmen – allerdings ist es für Neuautoren möglicherweise abschreckend, wenn ihre Verbesserungen nicht sofort sichtbar sind.

Die Markierung als geprüft geht über eine gesichte Version hinaus: Sie stellt ein Qualitätsurteil eines fachkundigen Prüfers dar. Ein Prüfer gibt mit der Markierung als geprüft bekannt, dass die betreffende Artikelversion keine falschen Aussagen oder verfälschende Lücken enthält. Damit nähert sich Wikipedia dem traditionellen Review-System in den Wissenschaften an. Genauer gesagt handelt es sich um ein Offenes Peer-Review-Verfahren. Bisherige Peer-Review-Verfahren stoßen immer mehr an ihre Grenzen – zur Überwindung dieser Krise könnten Wikis helfen.

Was ich besonders bemerkenswert finde: Im Unterschied zu den bereits jetzt in Wikipedia vorhandenen Review-Verfahren (lesenswerte Artikel, exzellente Artikel) treten bei der Prüfung von einzelnen Artikelversionen nicht das Kollektiv der „Wikipedianer“ in Erscheinung, sondern einzelne Personen. Wenn jemand einen Artikel prüft, muss er mit seiner vollen Reputation dafür geradestehen, dass keine Fehler übersehen wurden. Bei Wikipedia-Autoren ist das in geringerem Maße zwar auch schon der Fall; für Außenstehende ist jedoch in der Regel undurchschaubar, was ein Autor zu einem konkreten Wikipedia-Artikel geleistet hat.

Ich befürchte nur, dass den meisten Lesern aufgrund fehlender Informationskompetenz sowieso egal ist, wer für welche Inhalte in Wikipedia verantwortlich ist (nämlich die konkreten Autoren und Prüfer und nicht ein anonymes Kollektiv oder ein Herausgeber!). Die meisten Menschen wollen nämlich beim Erwerb von „Wissen“ nicht selber denken, sondern einer Autorität vertrauen, die sagt, was richtig und was falsch ist. Das ist dann aber nicht das Problem der Wikipedia sondern ein Problem der Massenverdummung unserer Gesellschaft und ihren Teilnehmern, die lieber in selbstverschuldeter Unmündigkeit verharren, anstatt eigenes Urteilsvermögen zu gebrauchen.

Ich bin gespannt, wie sich die markierten Versionen in der Praxis entwickeln werden und wie sich die offen-anarchische Wikipedia-Community und das elitär-akademische Wissenschaftssystem weiter aufeinander zubewegen – im Guten wie im Schlechten.

re:publica 2008

1. April 2008 um 19:40 2 KommentareSo, ich fahr‘ dann auch ma‘ nach Berlin zur re:publica08. Dort treffen sich Blogger, andere Arbeitslose, Selbstdarsteller und/oder Weltverbesserer, um … dabei zu sein 😉

Nächste Woche geht es dann zur INETBIB’08 und im Monat d’rauf ist schon das erste BibCamp. Und dann ist ja auch schon bald wieder Weihnachten!

Wikisource im DFG-Viewer dank Schnittstellen

31. März 2008 um 14:52 3 KommentareDer DFG-Viewer ist eine relativ neue Webanwendung zur Anzeige von Digitalisaten. Das von der Deutschen Forschungsgemeinschaft geförderte Projekt soll bei der Etablierung von Standards für Digitalisierungsprojekten helfen – und macht das dank Webservices und offener Standards schon recht gut.

Angestoßen von einem Hinweis auf die Sammlung Ponickau an der ULB Sachsen-Anhalt und eine anschließende Diskussion um die andauernden Verwirrungen bezüglich URI, URN, URL Identifikatoren und Lokatoren, habe ich mir den DFG-Viewer etwas näher angesehen. Die Darstellung sieht nicht ganz so cool aus, wie bei The Open Library, dafür gibt es offene Schnittstellen. Digitalisate können dem Viewer per OAI oder direkter URL im METS/MODS-Format übergeben werden. Die einzelnen Seiten eines digitalisierten Buches und dessen innere Struktur (Gliederung) lassen sich dann durchblättern. Eine Volltextsuche ist anscheinend noch nicht implementiert und es fehlt eine eigene Zoom-Funktion; bislang ist es nur möglich zwischen verschieden großen Auflösungen zu wechseln, falls diese vom Repository ausgeliefert werden.

Ein Exemplar des auf INETBIB als Beispiel genannten Buches mit der VD17-Nummer 32:623995L ist in Halle digitalisiert vorhanden. Die Metadaten des Digitalisates können per OAI in METS/MODS abgerufen werden. Übergibt man nun dem DFG-Viewer die URL, kann das Digitalisat im DFG-Viewer betrachtet werden. Im Moment ist noch ein Schritt Handarbeit notwendig, da im DFG-Viewer ein falscher (?) OAI-Server für Halle eingetragen ist, aber grundsächtlich funktioniert das Mashup. 🙂

Statt spaßeshalber eine METS-Datei mit Pornobildchen zusammenzustellen, um sie im DFG-Viewer anzeigen zu lassen, habe ich mir ein zufälliges Digitalisat von Wikisource vorgenommen. In Wikisource gibt es für jedes Digitalisat eine Indexseite, auf der einige Metadaten und die Seiten der digitalisierten Vorlage aufgelistet sind. Aus dieser Seite kann eine METS/MODS-Datei erzeugt und an den DFG-Viewer geschickt werden. Zwei bis drei Stunden später steht ein einfaches Perl-Skript, dass aus der Index-Seite in Wikisource eine METS-Datei erzeugt. Und so sieht es im DFG-Viewer aus (Draufklicken=größere Ansicht):

Das ganze ist nur ein schnell gehackter Proof-of-concept. Eine stabile Verwendung der Metadaten aus Wikisource sollte aus einer OAI-Schnittstelle bestehen, die METS/MODS liefert (und MABXML für ZVDD). Falls jemand Interesse hat (Bachelor/Diplomarbeit, eigenes Projekt etc.), biete ich gerne meine Unterstützung an – umsetzen muss er es jedoch erstmal jemand anderes da ich nicht dauernd nur neue Projekte anfangen kann. 🙁

Mein Vetter, digitalisierter Gefangener der Gemäldegalerie

26. März 2008 um 11:29 Keine KommentareFür die Abteilung „Dinge, die ich nicht brauche, die aber ganz nett wären“, habe ich für meinen Wunschzettel dieses Objekt entdeckt. Da es wahrscheinlich nur mittels eines angeblich „neben Drogen- und Menschenhandel […] einträglichsten“ Verfahrens beschaffbar ist, reicht zur Not auch eine Kopie aus. Beim Wallraf-Richartz-Museum kann man Abzüge und Scans in verschiedenen Varianten online bestellen. Erst kurz vor Abschluss der Bestellung (High-end-scan RGB 300dpi bis 24x30cm/40MB, Verwendung: Veröffentlichung) steht im Kleingedruckten ein Hinweis auf die Entgeltordnung. Demnach kommen ggf. noch zahlreiche undurchsichtige Zusatzgebühren hinzu und die „Internet-Veröffentlichung“ ist sowieso nur mit Aufpreis und für 3 Monate möglich. Mein Vetter sitzt also sozusagen lebenslang – nein: über sein Ableben hinaus! – als Gefangener der Gemäldegalerie aufgrund zweifelhafter Rechtsvorstellungen fest und keine Aussicht auf Befreiung. Keine Aussicht? Der Urheber ist vor mehr als 70 Jahren gestorben, so dass keine Rechtsansprüche mehr bestehen. Ich kann gerne anbieten, sein Grab zu besuchen, um für seine Werke eine Blume niederzulegen. Aber was ich auf keinen Fall machen werde ist, Museen oder Bibliotheken Geld zur Digitalisierung in die Hand zu drücken, ohne dass dabei die Wikimedia-Empfehlungen für Rechte bei Digitalisierungsprojekten beachtet werden. Dann lieber selber digitalisieren.

P.S: Zum Thema „eigenwilliger Umgang mit Digitalisaten“ hat mein Kollege einen wunderbar treffenden und stilistisch sehr unterhaltsam geschriebenen Text des – mir bislang unbekannten – Institut für Dokumentologie und Editorik entdeckt: In diesem PDF ab Seite 18 unten bis Seite 22 🙂

Wettbewerb: Ideen zur Zukunft des Internets

20. März 2008 um 13:58 1 KommentarLeider etwas an mir vorbeigegenagen ist der schon seit November letzten Jahres laufende Ideenwettbewerb im Rahmen des Theseus-Projekt mit Einsendeschluss 14. April 2008 [via IB Weblog]. Der Wettbewerb an sich ist aller Kritik am Theseus-Projekt zum Trotz schon mal eine gute Idee! Hier das wichtigste zusammengefasst:

Schaut euch den Fragenkatalog an, ignoriert das Geschwurbel und Technoblabla und sucht euch eine Frage aus, die irgendwie passend klingt. Dann heftig Brainstormen, Drogen einwerfen, Spazieren gehen oder wie auch immer die besten Ideen kommen und anschließend die Geistigen Ausflüsse in verständlicher Form zusammenfassen. Die Teilnahmebedingungen sind:

Die besten Ideen werden mit Geldprämien ausgezeichnet und im Rahmen einer Patenschaft mit einem THESEUS-Konsortialpartner umgesetzt und weiterentwickelt. Es ist vorgesehen, insgesamt bis zu 24 Ideen auszuzeichnen. Die beste Idee soll mit 10.000 €, die Preisträger zwei bis vier mit jeweils 5.000 € prämiert werden. Alle weiteren Preisträger sollen mit 2.500 € ausgezeichnet werden. […] Teilnahmeberechtigt sind natürliche Personen mit Wohnsitz in Deutschland, z.B. Nachwuchs¬wissenschaftler, Studierende, Schüler und freie Entwickler. […] Die Idee sollte auf max. 10 Seiten beschrieben werden. […] Nach Ausfüllen des Anmelde-Formulars kann der Wettbewerbsbeitrag als pdf-Datei hochgeladen werden. Alle Angaben können bis zum Einsendeschluss jederzeit verändert werden. […] Die eingegangenen Wettbewerbsbeiträge werden durch eine Jury mit Beteiligung externer Experten bewertet. Hauptbewertungskriterien sind Qualität der Idee, Innovationsgehalt und Originalität des Ansatzes sowie Umsetzbarkeit. Weitere Kriterien sind Potenzial und Kompetenz des Wettbewerbsteilnehmers, Qualität des Arbeitsplanes und der Ressourcenabschätzung sowie Verwertungs-, Markt- und Anwendungspotenzial.

Übrigens spricht nichts dagegen, gute Ideen von anderswo zu nehmen (natürlich mit Quellenangabe!) und Ideen öffentlich zu diskutieren. Ideen sind zum Teilen da, und wer eine Idee weitergibt kann nur gewinnen (gegen die künstliche Monopolisierung durch Patente und andere Vergewaltigungen des Wissens helfen Freie Lizenzen).

Wem nichts einfällt hier zur Anregung einige Ideen über Ideen.

Länder, die es gar nicht gibt

16. März 2008 um 00:07 Keine KommentareJetzt weiß ich endlich, was das für eine Fahne war, die letzte Woche in Göttingen vor dem Rathaus (sic!) hing, es muss am Montag zum Jahrestag des Volksaufstandes in Lhasa gewesen sein. Am 21. März wurde der Aufstand damals blutig niedergeschlagen – momentan sieht es eher so aus, als ob sich das wiederholen könnte. Laut tagesthemen und Spiegel Online sollen sich die Demonstraten bis Dienstag selber bei der Polizei melden, dann werden sie wahrscheinlich ein bischen weniger gefoltert als jene, die erst später durch die Film- und Fotoaufnahmen identifiziert werden.

Am 22. März diesen Jahres sind in Taiwan Präsidentschaftswahlen und gleichzeitig wird ein Referendum darüber abgehalten, ob das faktisch seit Jahrzehnten unabhängige und seit 1987 demokratische Land sich zukünftig als „Taiwan“ statt als „Republik China“ um Aufnahme in die Vereinten Nationen bemühen soll. Der Antrag wird aber sowieso immer abgelehnt, da es niemand mit China verscherzen möchte. Weil die Deutsche Regierung beim Ablehnen immer brav mitmacht und auch in ihrer Tibet-Politik eher der Wirtschaft vor den Menschenrechten Priorität einräumt, gab es diesen Januar ein Lob aus Peking. Man muss jedoch zugeben, dass in Taiwan die Frage der Unabhängigkeit vor allem innenpolitisch mißbraucht wird. Wie es aussieht wird bei der Wahl die Opposition gewinnen, die inzwischen zu einem Boycott des Referendums aufruft. Mit Taiwans Unabhängigkeit hat das weniger zu tun als damit, dass der jetzige Präsident in den größeren Korruptionsskandal verwickelt ist als die Opposition. Eine Beschreibung der Taiwanesischen Verhältnisse (und das was die Taiwanesen tatsächlich interessiert) gibt es im Blog von Rüdiger Teichert.

Ähnlich wie Taiwan wird es dem Kosovo ergehen, eine genaugenommen völkerrechtswidrig von Serbien abgespaltene Region, die momentan ein eigener Staat wird, aber keinen Sitz bei den Vereinten Nationen bekommt und nur von einigen anerkannt wird. Im Gegensatz zu Taiwan ist die EU hier offener, schließlich wandert die Aufbauhilfe für den Kosovo wieder über Aufträge an Europäische Firmen, während Serbien sich lieber von Russland kaufen lässt.

Von Tibetern und Taiwanesen in Göttingen weiß ich nichts, habe dafür aber auf der Suche nach Göttinger Weblogs grade den Blog der Nepalesen in Göttinger entdeckt – das Land wird im Gegensatz zu Tibet, Taiwan und Kosovo von allen anderen Staaten anerkannt obgleich es auch kein Musterknabe ist. Was schließlich alle hier genannten vereinigt (selbst Göttingen) ist die Korruption, weshalb ich mein Geld auch lieber Transparency International spende als irgendwelchen letzendlich nationalistischen Freiheitsbewegungen. Der letzte Eintrag der Presseschau von TI verweist übrigens auf einen Artikel zum Korruption im Sport – womit sich der Kreis die fünf Ringe schließen.

Bücher, die ich schon mal ausgeliehen hatte…

15. März 2008 um 15:38 1 KommentarHaftgrund berichtet, dass es in Wiener Büchereien „aus Datenschutzgründen“ nicht mehr möglich ist, im Bibliothekssystem auf Wunsch die Titel zu speichern, die man in der Vergangenheit schon mal ausgeliehen hatte. Schön, dass Bibliotheken anders als die meisten Webanbieter auf Datenschutz achten und nicht bis in alle Ewigkeiten speichern, wer wann was gemacht hat. In diesem Fall ist die Begründung aber wohl eher vorgeschoben, schließlich klingt „Datenschutz“ auch kompetenter als „unsere Software kann das nicht und/oder wir wissen nicht wie man sowas technisch umsetzt“. Die Möglichkeit, alle ausgeliehenden Bücher automatisch in einer Liste abzuspeichern, ist meinem Eindruck nach in Bibliotheken ebenso nützlich wie selten.

Wie Edlef bemerkt, kann man ausgeliehene Bücher ja auch „in citavi, Librarything oder beliebigen anderen Literaturverwaltungssystemen für sich selbst [speichern]“ – was prinzipiell tatsächlich die bessere Variante ist. Nur sollten Bibliotheken Nutzer dabei nicht in „kenn wa nich, wolln wa nicht, ham wa nich, geht nich“-Manier abspeisen, sondern aktiv für die Verknüpfung von Bibliothekssystemen mit Literaturverwaltungssystemen sorgen. Alles was über ein Feld „Ausleihen automatisch bei BibSonomy/LibraryThing/etc. eintragen“ im Benutzerkonto hinausgeht, ist nicht zumutbar und überflüssig.

Ein Lösungsansatz gemäß Serviceorientierter Architektur sähe folgendermaßen aus:

Das Ausleihsystem bekommt eine Webschnitttstelle, über die Nutzer abfragen können, welche Medien sie zur Zeit ausgeliehen haben. Wenn dabei RSS oder ATOM eingesetzt wird (natürlich nur über HTTPS und mit Passwort), sollten gängige Feed-Aggregatoren damit klarkommen. Bisher muss der Zugang zum Ausleihsystem für jede Anwendung wie Bücherwecker einzeln gehackt werden, was mühsam und fehleranfällig ist. Die ausgeliehenen Werke sollten (per URL-Parameter steuerbar) in möglichst vielen Datenformaten beschrieben werden. Prinzipiell reicht aber auch die Standard-Kurztitelanzeige und ein Identifier, mit dem z.B. über unAPI weitere Details in verschiedenen Datenformaten angefordert werden können. Zusätzlich zu diesem Pull-Verfahren sollte die Möglichkeit gegeben werden, á la Pingback andere Dienste zu benachrichtigen sobald ein Benutzer ein Medium ausgeliehen hat.

Den Rest (das automatische Eintragen in eine Literaturverwaltung) kann – und sollte – bei gegebenen APIs eine eigene Anwendung übernehmen. Es würde mich nicht wundern, wenn die fixen Entwickler von LibraryThing das selber basteln oder sich ein Student im Rahmen einer Diplom- oder Bachelorarbeit daran setzt. Sobald saubere, einfache Schnittstellen verfügbar sind, ist der Aufwand für neue „Mashups“ und Zusatzdienste minimal.

Neueste Kommentare