Informatik ist cool, mit oder ohne Wettbewerbe!

30. Januar 2008 um 01:31 Keine KommentareDer Chiphersteller Intel und die Hannover Leibniz-Universität wollen mit dem gestern beworbenen Intel®-Leibniz-Challenge (was für ein beknackter Name) dem „Fachkräftemangel in den Ingenieurswissenschaften“ entgegentreten und das „Informatikstudium cool machen“ [via heise]. Der Schülerwettbewerb hieß letztes Jahr noch „1. Wettbewerb Leibniz Challenge unterstützt von Intel“ (nicht weniger beknackter Name). Die Unterstützung liest sich dann in der ersten der Aufgabe der ersten Runde (PDF) so:

Ein moderner Computer besteht aus vielen unterschiedlichen Komponenten. Die Kern-Komponente des Computers (das „Gehirn“) ist der Prozessor, wie z.B. der Core 2â„¢ Duo, der von Intel als weltgrößtem Hersteller von Halbleiterbauelementen entwickelt wurde […]

Der Rest der Aufgaben wird dann aber besser und ganz zum Schluss gibt es neue Laptops und 30.000€ für die Schule. Mal im Ernst: Informatik ist cool. Vom Schüler bis zum Rentner kann ich jedem mit etwas Spaß an Knobeleien empfehlen, es statt Sudoku mal mit Informatik – Rätseln zu versuchen. Etwa 1 0 0 0 mal cooler (und ein wenig anspruchsvoller) als der „Challenge“ ist allerdings der Bundeswettbewerb Informatik (BWINF, siehe Wikipedia), der nächsten September in die 28. Runde geht. Dort und nirgendwo anders habe ich mit QBasic und Borland Turbo C++ unter MS-DOS 5.0 programmieren gelernt – das Studium war danach kein wirkliches Problem mehr. Leider habe ich es nie in die Endrunde der besten 30 geschafft, aber Spaß gemacht hat es trotzdem. Wem der BWINF zu aufwändig ist, der sollte sich mal den etwas jüngeren Onlinewettbewerb Informatik anschauen. Das wichtigste Werkzeug zur Lösung sind übrigens Papier und Stift!

Encoding ISO 3166 in RDF with SKOS

29. Januar 2008 um 00:56 Keine KommentareLast year at the 2nd International Conference on Metadata and Semantics Research (MTSR 2007) I gave a talk about the Simple Knowledge Organisation System (SKOS) and its application to encode ISO 3166 country codes. The revised paper „Encoding changing country codes for the Semantic Web with ISO 3166 and SKOS“ is finally ready to appear in the post-proceedings. The preprint is accessible at http://arxiv.org/abs/0801.3908. I raised three issues (notations, nesting concept schemes, and versioning) that are not included in the current SKOS draft – but the proposed solutions are compliant, beside the nesting of concept schemes with the RDF property skos:member – which could be possible by making skos:ConceptScheme a RDF subclass of skos:Collection. Therefore the paper can also be used as a general introduction to SKOS, especially to encode authority files. More details in the paper and at the public-esw-thes@w3.org mailing list. SKOS is going to become a W3C recommendation this year.

Amtliches vorläufiges Endergebnis und weniger bekannte Details

28. Januar 2008 um 00:37 2 KommentareWarum wird eigentlich bei diesen blöden Hochrechnungen kein Konfidenzintervall angegeben? Egal, hier das vorläufige amtliche Endergebnis für die Landtagswahl in Niedersachsen und in Hessen. Die Wahlbeteiligung lag in Niedersachsen bei 57,0% (49,5%-63,6%) bzw. 56% der Wahlbeteiligten mit gültig abgegebenen Stimmen und in Hessen bei 64,3% bzw. 62,8% gültige Stimmen. Die NPD wurde in Niedersachsen von 52.817 Menschen mit ihrer Zweitstimme gewählt und bekommt dafür als einzige der „Sonstiges“ Parteien Wahlkampfkostenerstattung (1,5% d.h. 36.971,90€). Die meisten Anhänger scheint sie in Delmenhorst (577=2,1%) und Helmstedt (1.548 = 3,6%) zu haben. In Hessen bekamen NPD und Republikaner zusammen 51.693 Stimmen (1,9%), da sie jeweils ganz knapp unter 1% liegen, dürften sie dafür kein Geld erhalten. Dass die CDU in Hessen doch noch ganz knapp vor der SPD liegt (1.009.749 zu 1.006.154 Stimmen) könnte angefochten werden, da es beim Einsatz von Wahlcomputern zu Unstimmigkeiten kam. Unter anderem lagerten Wahlcomputer in Niederhausen in Privatwohnungen von Parteimitgliedern, wie Wahlbeobachter des CCC mitteilten. Ob die Geräte so umprogrammiert wurden, dass 1798 für die SPD abgegebene Stimmen stattdessen der CDU zugeschlagen wurden, bezweifle ich, aber es ist immerhin eine mögliche Erklärung. 😉 Mehr haarsträubende Berichte vom Einsatz der Wahlcomputer in Hessen bei Netzpolitik.

30 Jahre Tunix-Kongress

26. Januar 2008 um 11:20 Keine KommentareVor 30 Jahren, vom 27.-29. Januar 1978, fand in Berlin der Tunix-Kongress statt. In Wikipedia gibt es einen kurzen Ãœberblick und bei „einestages“ berichtet ein Zeitzeuge (mit Bildern). Nach dem 68er-Bashing im letzten Jahr ist das eine passende Gelegenheit für etwas Differenzierung: na sowas, es waren bei weitem nicht alle Terroristen. Der Tunix-Kongress wird als Höhepunkt der sympatisch undogmatischen Sponti-Bewegung angesehen und gab Anstoß für vieles was für die jüngeren von uns (hüstel…ich war damals noch nicht mal gezeugt) heute wie selbstverständlich zur Bundesrepublik dazugehört (taz, die Grünen, Christopher-Street-Day, die Autonomen und eine bunte Vielfalt weiterer „alternativer“ Initiativen und Organisationen). Sicherlich: Vieles davon war auch nicht der Weisheit letzter Schluß und wie Felix Lee gestern in der taz kommentierte sollte Tunix nicht überbewertet und verklärt werden – aber dabei gewesen wäre ich schon gerne. Egal. 30 Jahre später gibt es genügend Anlässe sich undogmatisch und froh daran zu beteiligen, dass die Welt nicht völlig in den Arsch geht. Macht nichts, aber tut was! 🙂

P.S: Und um mir ein weiteres Politik-Posting zu sparen hier noch der Hinweis auf nebeneinkuenfte-bundestag.de [via netzpolitik].

Landtagswahlen in Hessen und Niedersachsen ohne Wähler?

24. Januar 2008 um 23:21 Keine KommentareAus Anlass der Landtagswahlen in Hessen und Niedersachsen am kommenden Sonntag hier noch einige Informationen über die weniger üblichen Optionen. Abgesehen vom unwählbaren „Hessenhitler“ haben in beiden Bundesländern Prognosen zufolge CDU, SPD, Grüne, FDP und Linkspartei gute Chancen, in die Landtage einzuziehen (siehe auch die Wahlbörse von Prokons).

Wer sowieso eine dieser Parteien gut findet – sei es als positiver Anhänger oder als Vertreter der Strategie des „Kleines Ãœbels“ hat sich schon entschieden und brauch nicht mehr weiterlesen – aber was ist mit den noch Unentschlossenen? Wer Wert darauf legt, dass möglichst viele Parteien im Landtag vertreten sind, könnte sich als Protestwähler die Linkspartei überlegen – damit könnte diese in Hessen wohlmöglich noch an die Regierung kommen. Statt den Parteien im Landtag bieten sich für Protestwähler die Splitterparteien an. Dafür muss man dann aber doch ein wenig Idealist sein – oder berechnender Altruist: Ab 1% der Zweitstimmen (bzw. ab 10% in einem Wahl- oder Stimmkreis) bekommen Parteien Wahlkampfkostenerstattung. Das könnten je nach Wahlbeteiligung etwa 16.000€ (Hessen) oder 25.000€ (Niedersachsen) sein, die eine Partei dazubekommt. Die Chancen dafür sind aber eher gering, 2003 gelang es nur den Republikanern in Hessen und da die dummen Nazis dieses Jahr dort wohl eher CDU wählen, wird das auch nichts.

Es bleibt noch die Alternative, nicht oder ungültig zu wählen. Ungültig und Nichtwählen. Nichtwähler bleiben einfach zu Hause und bestätigen sowohl das Ergebnis der Wahl – wie immer es auch ausfällt – als auch ihr Desinteresse oder ihre Ablehnung der Wahl. Oder dass sie den Wahltermin verpeilt haben. Unpolitisch, verantwortungslos und undemokratisch muss das jedenfalls nicht sein – siehe zum Beispiel die Initiative Wahlabsage und das Buch Die letzte Wahl (auch in Wikipedia). Dass Nichtwähler den radikalen Parteien Vorschub leisten ist Quark und Demokratie finden wahrscheinlich viele grundsätzlich auch ganz gut – nur eben nicht diese Form der Medien-, Parteien- und Lobbyistendemokratie. Dass es unter bestimmten Bedingungen auch anders geht, zeigt Wikipedia: dort heisst eine der schönsten Regeln Nimm nicht an Abstimmungen teil. Trotzdem gibt es in Wikipedia zahlreiche Meinungsbilder und Abstimmungen. Ob, wann, wo und in welcher Form Abstimmungen sinnvoll sind, kann aber selbst wiederum diskutiert werden.

Nun ist ein Bundesland zwar nicht Wikipedia, aber alle 4 oder 5 Jahre zweifelhaften Organisationen eine Blankobescheinigung auszustellen kann es auch nicht gewesen sein. Stattdessen besteht zumindest die Möglichkeit, nicht zu wählen oder noch besser: den Gang zum Wahllokal für einen Spaziergang nutzen, den Wahlhelfern vor Ort für ihren Einsatz zu danken (bzw. sich die Wahlmanipulationsgeräte anschauen), und dann mit einem ungültigen Stimmzettel explizit gegen Mitbestimmungssimulation aussagen. Wer sich daneben anderweitig politisch beteiligt und dabei an einem offenen, gleichwertigen Austausch von Meinungen und Interessen interessiert ist, verdient mehr Respekt als jemand, der seine Stimme abgibt und sich danach höchstens noch darüber beschwert, dass „die die oben doch sowieso machen, was sie wollen.“ Dabei gibt es genügend Möglichkeiten, hier unten selber etwas zu bewirken, es muss ja nicht gleich die Revolution sein 😉

Citation parsing

24. Januar 2008 um 19:09 6 KommentareCitation Analysis is used to rate authors (problematic) and to find interesting papers (good idea). Citations of papers at the famous arXiv.org preprint server are analysed by CiteBase which is very useful. Unluckily it is buggy and does not alway work. I really wonder why the full text of a paper is parsed instead of using the BibTeX source. The citation parser ParaCite has been developed in the Open Citation Project. Since then it seems to be more or less abandoned. But it’s open source so you can test you papers before uploading and one could take the suiting parts to build a better citation parser. I found out that this way you can extract citations out of a document in $file (for instance a pdf) with perl (the needed modules are available at CPAN):

my $parser = Biblio::Citation::Parser::Citebase->new;

my $content = Biblio::Document::Parser::Utils::get_content( $file );

my $doc_parser = Biblio::Document::Parser::Brody->new;

my @references = $doc_parser->parse($content);

for (my $i=0; $i < @references; $i++) {

my $metadata = $parser->parse( $references[$i] );

print '[' . ($i+1) . '] ' . Dumper( $metadata ) . "\n";

}

In the documented that I tested there are almost always parsing errors, but better then nothing. I wonder what CiteSeer uses to extract citations? There is more action in citation parsing in the Zotero project – even an IDE called Scaffold to create new „translators“ that extract bibliographic data out of webpages. Another playing ground is Wikipedia which contains a growing number of references. And of course there are the commericla citation indexes like SCI. I thought to use citation data for additional catalog enrichement (in addition to ISBN2Wikipedia) but quality of data seems to be too low and identifiers are missing.

P.S: Right after writing this, I found Alf Eaton’s experiment with collecting together the conversations around a paper from various academic, news, blog and other discussion channels – as soon as you have identifiers (ISBN, URL, DOI, PMID…) the world gets connected 🙂

P.P.S: ParsCit seems to be a good new reference string parsing package (open source, written in Perl).

P.P.S: Konstantin Baierer manages a bibliography on citation parsing for his parser Citation::Multi::Parser.

Felix Klein über Riemann’sche Flächen in Katalogen

23. Januar 2008 um 11:43 6 KommentareIn einem Posting von letztem Jahr auf ol-tech wies Paul Rubin auf dieses Digitalisat (vollständiger Datensatz bei Archive.org) hin, mit dem die OCR ihre Schwierigkeiten haben dürfte: Abgesehen vom Titelblatt und Inhaltsverzeichnis ist das Vorlesungsskript „Riemann’sche Flächen 1“ (gehalten im Wintersemester 1891/92 in Göttingen) von Felix Klein handschriftlich verfasst! Der entsprechende Katalogeintrag im GBV ist dieser. Das Digitalisat stammt vom „zweiten Abdruck“ (1894), die erste Ausgabe (dieser Datensatz) ist von 1892. Einen unveränderte Nachdruck gab es 1906 (dieser Datensatz). 1986 erschien im Teubner-Verlag eine kommentierte Neuauflage (ISBN 3-211-95829-0), die im GBV-Katalog als Duplikat (hier und hier) verzeichnet ist. Wie aus dem Digitalisat bei Open Library und Internet Archive nicht ganz hervorgeht, gibt es auch den Zweiten Teil mit „Riemann’sche Flächen 2“ (siehe Datensatz) gehalten während des Sommer-Semesters 1892.

Abgesehen vom Inhalt finde das Beispiel schön, da es zwei Probleme und Herausforderungen illustriert. Duplikate und die Schwierigkeit sie automatisch zu erkennen (ein Algorithmus würde wahrscheinlich Teil 1 und Teil 2 zusammenschmeißen) sowie die fehlende semantische Verknüpfungen zwischen Datensätzen. Warum wird bei der Erstausgabe von Teil 1 nicht ein Verweis auf die folgenden Ausgaben, auf das Digitalisat und auf Teil 2 angezeigt? Je mehr ich mich mit dem Thema beschäftige, desto mehr komme ich zur Überzeugung, dass zu solch einer semantischen Tiefenerschließung alle Bibliothekare der Welt nicht ausreichen werden. Ein offener Ansatz wie beim Open Library Projekt, wo Katalogisate wie in Wikipedia von jedem gändert werden können, ist wahrscheinlich die einzige Möglichkeit, mit den Massen an Datensätzen und Verknüpfungsmöglichkeiten fertig zu werden.

P.S: Noch zwei amüsante Fundstücke: es gibt doch einen „Volltext“ und wie sich am Umschlag ablesen lässt wurde das zugrunde liegende Exemplar der Universität Berkeley zuletzt 1987 ausgeliehen worden, bevor es digitalisiert wurde.

Schnittstelle für Verfügbarkeitsdaten von Bibliotheksbeständen

21. Januar 2008 um 11:22 4 KommentareLetzen Dezember habe ich über Serviceorientierte Architektur geschrieben und bin unter Anderem auf den Heidelberger UB-Katalog eingegangen. Dabei ging es darum, wie Daten einzelner Exemplare von Bibliotheksbeständen – speziell Verfügbarkeitsdaten – über eine Schnittstelle abgefragt werden können. Bislang gibt es dafür keinen einfachen, einheitlichen Standards sondern höchstens verschiedende proprietäre Verfahren. Till hat mich zu Recht auf den Artikel „Beyond OPAC 2.0: Library Catalog as Versatile Discovery Platform“ hingewiesen, in dem die API-Architektur des Katalogs an der North Carolina State University vorgestellt wurde. Die Beispiele zeigen gut, was mit dem Buzzword „Serviceorientierte Architektu“ eigentlich gemeint ist, wie sowas in Bibliotheken umgesetzt werden kann und was für Vorteile der Einsatz von einfachen, webbasierten Schnittstellen bringt. Die als CatalogWS bezeichnete API ist – wie es sich gehört – offen dokumentiert. CatalogWS enthält einen Catalog Availability Web Service, der ausgehend von einer ISBN ermittelt, in welchen (Teil)bibliotheken ein Titel verfügbar oder ausgeliehen ist.

Bei Bedarf könnte ich mal versuchen, diese API für die GBV-Kataloge zu implementieren. Andererseits sollte man sich vielleicht erstmal Gedanken darüber machen, was es noch für Kandidaten für eine Verfügbarkeitsschnittstelle gibt und welche Daten über so eine Schnittstelle abfragbar sein sollten: Das NCIP-Protokoll scheint mir wie Z39.50 nicht wirklich zukunftsfähig zu sein. Janifer Gatenby macht in ihrem Vortrag „Bridging the gap between discovery and delivery“ (PPT) weitere durchdachte Vorschläge. Auf den Mailinglisten CODE4LIB und PERL4LIB habe ich letzte Woche herumposaunt, wie wichtig eine Holding-API wäre und dass das doch alles eigentlich ganz einfach sei. Neben Iinteressanten Bemerkungen zu FRBR bin ich daraufhin auf Holding-data in Z39.50 hingewiesen worden. In den PICA-LBS-Systemen stehen die Verfügbarkeitsdaten soweit ich es herausgefunden, habe im Feld 201@, aber nur teilweise. Für die weitere Umsetzung wäre es wahrscheinlich sinnvoll, erstmal alle in der Praxis vorkommenden Verfügbarkeits-Stati (ausleihbar, Präsenzbestand, Kurzausleihe, ausgeliehen, unbekannt…) zu ermitteln. Für elektronische Publikationen sollte die Schnittstelle außerdem irgendwie mit existierenden Linkresolvern zusammenarbeiten können. Eine einfache Schnittstelle für Verfügbarkeitsdaten von Bibliotheken ist also nicht ganz trivial, aber solange nicht jeder Spezialfall berücksichtigt wird oder erstmal ein Gremium eingesetzt werden muss, dürfte es machbar sein. Hat sonst noch jemand Interesse?

Vorratsdatenspeicherung fördert Korruption

17. Januar 2008 um 16:16 Keine KommentareÃœber den 2006 gegründeten Whistleblower-Netzwerk e.V. bin ich auf das „Business Keeper Monitoring System“ (BKMS) der BUSINESS KEEPER AG gestoßen. Whistleblower (deutsch „Hinweisgeber“) sind Personen, die Missstände wie verschleierte Gefahren, Korruption und andere nicht-aufgedeckte illegale Aktivitäten an die Öffentlichkeit bringen.

…also in etwa das Gegenteil der drei Affen (nichts sehen, nichts hören, nichts sagen) – die im Japanischen Original übrigens ganz anders interpretiert werden. Allerdings sollte Whistleblowing nicht mit dem Herumkrakelen und Gezeter über Mißständen verwechselt werden, die eigentlich längst bekannt sind und/oder sich leicht auf anderem Wege abstellen ließen.

Für tatsächliche Fälle von Korruption, Machtmißbrauch, Veruntreuung etc. sind Hinweisgeber nicht nur für die Öffentlichkeit, sondern auch für Unternehmen eigentlich von großem Nutzen – wenn jeder dichthält und Probleme unter den Teppich gekehrt werden, wachsen diese meist immer weiter, bis es zum großen Knall kommt (Skandal, Pleite etc.). Leider haben es Hinweisgeber mangels Schutz in Deutschland eher schwer und selbst in Ländern mit spezielle Whistleblower-Schutzgesetzen wird der Hinweisgeber als Ãœberbringer einer schlechten Nachricht oft selbst dafür verantwortlich gemacht und als Nestbeschmutzer diffamiert. Hilfreich sind deshalb Möglichkeiten, Beschwerden anonym abgeben zu können, was für an US-Börsen notierte Unternehmen sogar vorgeschrieben ist.

Das „Business Keeper Monitoring System“ ist ein mit EU-Mitteln gefördertes, kommerzielles Produkt, mit dem Unternehmen eine anonyme Beschwerdestelle einrichten können. Unter bkms-system.net finden sich beispielsweise Anlaufstellen des Landeskriminalamt Niedersachsen, der Deutschen Telekom AG und der Kaufmännischen Krankenkasse KKH. Ãœber ein Ticket-System, das ähnlich wie ein Toter Briefkasten funktioniert, ist auch die bidirektionale anonyme Kommunikation zwischen Hinweisgeber und Anlaufstelle möglich. Die Gute Idee wird jedoch durch mangelnde Implementation und nicht zuletzt die Vorratsdatenspeicherung torpediert.

Zum einen erfordert BKMS unverständlicherweise zur Benutzung JavaScript, was völlig unnötig ein potentielles Sicherheitsloch in das Verfahren reißt. Zum anderen ist es mit der Anonymität nicht weit her, wenn Verbindungsdaten ohne Tatverdacht erstmal ein halbes Jahr gespeichert werden. Investigative Journalisten wissen schon davon zu berichten, dass ihnen Informaten abspringen, weil sie nicht mehr sicher kommunizieren können. Wie soll sich ein Hinweisgeber sicher sein, dass seine Kontaktaufnahme mit der Anlaufstelle ihm nicht negativ angelastet wird? Ein zweifelhaftes Webformular bringt wenig, wenn nicht erklärt wird, wie man anonym (z. B. mit Tor) und verschlüsselt auf die Seite zugreifen kann. Ich empfehle der BUSINESS KEEPER AG erstmal JavaScript wegzuschmeissen und dann einen Tor-Exit Node für ihre Seite aufzusetzen, dann könnte es es mit der Anonymität klappen.

Dass sich auf der Seite des amerikanischen National Whistleblower Center ebenfalls nichts zu Verschlüsselung findet, macht die Sache auch nicht besser. Dass dagegen die Telekom eine Hinweisstelle für Whistleblower eingerichtet hat, während sie gleichzeitg Verbindungsdaten speichern muss, hat schon was ironisches.

Gekommen bin ich auf das Thema Whistleblowing übrigens über Mordechai Vanunu. Der Träger des Alternativen Nobelpreises hatte 1986 das Atomwaffenprogramm Israels publik gemacht. Daraufhin wurde er vom Mossad in Italien entführt und saß 11 Jahre in Isolationshaft. Seit 2004 ist er sozusagen in offenem Vollzug, d.h. er darf Israel nicht verlassen und sich nicht mit Ausländern unterhalten, weshalb er zwischenzeitlich wieder inhaftiert wurde. Dazu gibt es auf YouTube einen guten BBC-Film.

Weitere Informationen zum Thema gibt es unter Anderem im Weblog des Whistleblower-Netzwerk e.V. – dort lässt sich dann beispielsweise nachlesen wie im Lande des so genannten „Hessenhitler“ die Steuerfahndung intern an Aufklärung behindert wird.

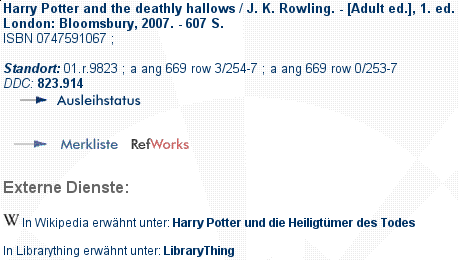

thingISBN is getting better – so does SeeAlso

17. Januar 2008 um 00:05 Keine KommentareTim Spalding points out that thingISBN is getting better [via FRBR blog] – a good reason to update the thingISBN data of our SeeAlso Linkserver isbn2librarything. It now includes 2994299 ISBNs, that’s almost 12 times the size of the isbn2wikipedia linkserver. But what’s a linkserver? A linkserver is a server that gets an identifier (for instance an ISBN) and gives you links (for instance a link to a work at LibraryThing). You can try out some SeeAlso linkservers at a demo page or start to implement your own.

To get an impression, look in GBV union catalog, for instance this record: after a short moment, a link to German Wikipedia is included. More and more German libraries follow to include such additional links in their catalog. The Catalog of University Bremen includes both links to (German) Wikipedia and links to LibraryThing (you have to click at „weitere Informationen…“ at a selected record):

There is also an experimental ISBN2WorldCat linkserver. But linkservers that only send one or zero links are not very effective. I could combine multiple service to something like ISBN2SocialCataloging or such. Any suggestions for other services that libraries might not be frightened to link to? I’d also like to include more data in the link to LibraryThing (for instance the number of reviews) but unless German libraries wake up to ask for LibraryThing for Libraries I better not reimplement services that LibraryThing already offers.

The linkserver model could also be used to provide links to library holding and thus implement a FRBR-Manifestation to FRBR-Item mapping. As I just wrote at CODE4LIB and PER4LIB, a simple data format for holding information is needed to do so.

Neueste Kommentare