Aktuelles zur Zeitschriftendatenbank

21. Mai 2009 um 12:33 Keine KommentareWie Jürgen Plieninger berichtet, wurde Anfang dieser Woche die Die Webseite der Zeitschriftendatenbank (ZDB) überarbeitet und auf das Content-Management-System (CMS) Typo3 umgestellt. Das Discovery-Interface (aka OPAC) der ZDB bleibt von den Änderungen unberührt. Um daran nachhaltig etwas zu verbessern, sollten sich meiner Meinung nach PICA-Anwender mal zusammentun und auf Open-Source-Basis (!) ein neues Interface für PICA-Kataloge erstellen. Die DNB hat beispielsweise ein eigenes Portal aufgesetzt und an der VZG werden verschiedenen Alternativen ausprobiert – z.B. die Suchkiste – aber zusammengenommen ist das noch zu wenig und zu unkoordiniert. Aber das ist ein Anderes Thema.

Über den RSS-Feed der ZDB-Webseite erfährt man zum Beispiel, dass vor kurzem die CD-ROM-Ausgabe eingestellt wurde – die ZDB ist also endgültig im Web angekommen. Um sozusagen auch im „Semantic Web“ oder „Web 3.0“ anzukommen, d.h. um auch mit den aktuellen Entwicklungen des Webs Schritt zu halten, sollt die ZDB als nächstes Linked Open Data tauglich werden. Dazu müssen in erster Linie stabile URIs vergeben und die ZDB-Daten verfügbar gemacht werden. Zweitens gibt es anscheinend auch in technischen Angelegenheiten nie genügend Dokumentation und Öffentlichkeitsarbeit. Auf der Mailingliste zur Bibliographic Ontology wird schon seit mehreren Wochen darüber diskutiert, wie sich Zeitschriftendaten am besten in RDF abbilden lassen und auf welche Daten dabei zurückgegriffen werden kann. Die ZDB wurde dabei zwar schon erwähnt, ist aber in der Diskussion noch nicht aktiv in Erscheinung getreten.

Unique Identifiers for Authors, VIAF and Linked Open Data

20. Mai 2009 um 15:53 1 KommentarThe topic of unique identifiers for authors is getting more and more attention on the Web. Martin Fenner listed some research papers about it and did a quick poll – you can see the results in a short presentation [via infobib]. What striked me about the results is how unknown existing traditional identifier systems for authors are: Libraries manage so called „authority files“ since years. The German Wikipedia has a cooperation with the German National Library to link biliographic Wikipedia articles [de] with the German name authority file since 2005 and there is a similar project in the Czech Wikipedia.

Maybe name authority files of libraries are so unknown because they have not been visible on the Web – but this changes. An important project to combine authority files is the Virtual International Authority File (VIAF). At the moment it already contains mappings between name authority files of six national libraries (USA, Germany, France, Sweden, Czech Republic, and Israel) and more are going to be added. At an ELAG 2008 Workshop in Bratislava I talked with VIAF project manager Thomas Hickey (OCLC) about also getting VIAF and its participating authority files into the Semantic Web. He just wrote about recent changes in VIAF: by now it almost contains 8 million records!

So why are people thinking about creating other systems of unique identifiers for authors if there already is an infrastructure? The survey that Martin did showed, that a centralized registry is wished. VIAF is an aggregator of distributed authority files which are managed by national libraries. This architecture has several advantages, for instance it is non-commercial and data is managed where it can be managed best (Czech librarians can better identify Czech authors, Israeli librarians can better identify authors from Israel, and so on). One drawback is that libraries are technically slow – many of them have not really switched to the Web and the digital age. For instance up to now there are no official URIs for Czech and Israeli authority records and VIAF is not connected yet to Linked Open Data. But the more people reuse library data instead of reinventing wheels, the faster and easier it gets.

For demonstration purpose I created a SeeAlso-wrapper for VIAF that extracts RDF triples of the mappings. At http://ws.gbv.de/seealso/viafmappings you can try out by submitting authority record URIs or the authority record codes used at VIAF. For instance a query for LC|n 79003362 in Notation3 to get a mapping for Goethe. Some returned URIs are also cool URLs, for instance at the DNB or the VIAF URI itself. At the moment owl:sameAs is used to specify the mappings, maybe the SKOS vocabulary provides better properties. You can argue a lot about how to encode information about authors, but the unique identifiers – that you can link to – already exist!

Petition gegen Internetzensur unterzeichnen!

18. Mai 2009 um 23:57 Keine KommentareObgleich schon in vielen Blogs und anderen Internetmedien berichtet wurde über die Pläne zur Internetzensur unter dem Vorwand der Bekämpfung von Kinderpornografie, möchte ich die Sache selber kurz zusammenfassen für alle, die die Petition an den Bundestag noch nicht unterzeichnet haben:

Die Petition richtet sich gegen ein geplantes Gesetz der Fraktionen der CDU/CSU und SPD, nach dem das Bundeskriminalamt (BKA) eine geheime Liste von Webseiten verwalten soll, die von Internetprovidern gesperrt werden müssen. Statt der Seiten soll ein Stoppschild angezeigt und der Zugriff auf das Stoppschild protokolliert werden.

Wie sinnlos und gefährlich das ist, wird unter Anderem in einem YouTube-Video mit LEGO demonstriert: Das Internet ist wie eine Fußgängerzone, bei der die Webseiten den Schaufenstern entsprechen. Das BKA soll nun das Recht bekommen, vor jedes Schaufenster seiner Wahl ein Stoppschild anzubringen und alle Passanten zu filmen, die vor dem Stoppschild stehenbleiben. Dabei lässt sich das Stoppschild mit wenig technischem Aufwand (oder über die Seitengassen) ganz einfach umgehen. Welche Schaufenster verdeckt werden, ist geheim. So werden unliebsame Webseiten einfach zensiert, anstatt gegen die Seitenbetreiber mit rechtlichen Mitteln vorzugehen: Wegschauen statt helfen und alles im Namen des Kinderschutz!

Statt tatsächlich gegen Kindesmissbrauch vorzugehen werden also mit dem Gesetz und mit ähnlichen Maßnahmen Grundrechte abgeschafft. Im Februar gab es beispielsweise eine Hausdurchsuchung bei einem Blog-Betreiber, der einen Link auf einen anderen Blog gesetzt hatte, der wiederum auf eine der geheimen Sperrlisten bei WikiLeaks verlinkt hatte. Da im Internet über einige Links Alles mit Allem Verbunden ist, kann praktisch jeder mit einer willkürlichen Hausdurchsuchung rechnen.

Eine weitere gute Zusammenfassungen gibt es hier, hier beim CCC und übersichtlich unter www.zeichnemit.de. Abschließend nochmal der Text der Petition und ihre Begründung. Bitte unterzeichnet und sagt es weiter – auch außerhalb des Internet:

Wir fordern, daß der Deutsche Bundestag die Änderung des Telemediengesetzes nach dem Gesetzentwurf des Bundeskabinetts vom 22.4.09 ablehnt. Wir halten das geplante Vorgehen, Internetseiten vom BKA indizieren & von den Providern sperren zu lassen, für undurchsichtig & unkontrollierbar, da die „Sperrlisten“ weder einsehbar sind noch genau festgelegt ist, nach welchen Kriterien Webseiten auf die Liste gesetzt werden. Wir sehen darin eine Gefährdung des Grundrechtes auf Informationsfreiheit.

Begründung: Das vornehmliche Ziel – Kinder zu schützen und sowohl ihren Mißbrauch, als auch die Verbreitung von Kinderpornografie, zu verhindern stellen wir dabei absolut nicht in Frage – im Gegenteil, es ist in unser aller Interesse. Dass die im Vorhaben vorgesehenen Maßnahmen dafür denkbar ungeeignet sind, wurde an vielen Stellen offengelegt und von Experten aus den unterschiedlichsten Bereichen mehrfach bestätigt. Eine Sperrung von Internetseiten hat so gut wie keinen nachweisbaren Einfluß auf die körperliche und seelische Unversehrtheit mißbrauchter Kinder.

Who identifies the identifiers?

10. Mai 2009 um 16:39 7 KommentareA few days ago, after a short discussion on Twitter, Ross Singer posted a couple of open questions about identifiers for data formats on code4lib and other related mailing lists. He outlined the problem that several APIs like Jangle, unAPI, SRU, OpenURL, and OAI-PMH use different identifiers to specify the format of data that is transported (MARC-XML, Dublin Core, MODS, BibTeX etc.). It is remarable that all these APIs are more or less relevant only in the libraries sector while the issue of data formats and its identifiers is also relevant in other areas – looks like the ivory tower of library standards is still beeing build on.

The problem Ross issued is that there is little coordination and each standard governs its own registry of data format identifiers. An inofficial registry for unAPI [archive] disappeared (that’s why I started the discussion), there is a registry for SRU, a registry for OpenURL, and a list for Jangle. In OAI-PMH and unAPI each service hosts its own list of formats, OAI-PMH includes a method to map local identifier to global identifiers.

On code4lib several arguments and suggestions where raised which almost provoced me to a rant on library standards in general (everyone want’s to define but noone likes to implement and reuse. Why do librarians ignore W3C and IETF?). Identifiers for data formats should neither be defined by creators of transport protocols nor do we need yet another über-registry. In my point of view the problem is less technical but more social. Like Douglas Campbell writes in Identifying the identifiers, one of the rare papers on identifier theory: it’s not a technology issue but a commitment issue.

First there is a misconception about registries of data format identifiers. You should distinguish descriptive registries that only list identifiers and formats that are defined elsewhere and authoritative registries that define identifiers and formats. Yes: and formats. It makes no sense to define an identifier and say that is stands for data format X if you don’t provide a specification of format X (either via a schema or via a pointer to a schema). This already implies that the best actor to define a format identifier is the creator of the format itself.

Second local identifiers that depend on context are always problematic. There is a well-established global identifier system called Uniform Resource Identifier (URI) and there is no excuse not to use URIs as identifiers but incapability, dullness, laziness, or ignorance. The same reasons apply if you create a new identifier for a data format that already has one. One good thing about URI is that you can always find out who was responsible for creating a given identifier: You start with the URI Scheme and drill down the namespaces and standards. I must admin that this process can be laborious but at least it makes registries of identifiers descriptive for all identifiers but the ones in their own namespace.

Third you must be clear on the definition of a format. For instance the local identifier „MARC“ does not refer to a format but to many variants (USMARC, UNIMARC, MARC21…) and encodings (MARCXML/MARC21). This is not unusual if you consider that many formats are specializations of other formats. For instance ATOM (defined by RFC4287 and RFC5023, identified either its Mime Type „application/atom+xml“ which can could expressed as URI http://www.iana.org/assignments/media-types/application/atom%2Bxml or by its XML Namespace „http://www.w3.org/2005/Atom“)* is extended from XML (specified in http://www.w3.org/TR/xml [XML 1.0] and http://www.w3.org/TR/xml11 [XML 1.1], identified by this URLs or by the Mime Type „application/xml“ which is URI http://www.iana.org/assignments/media-types/application/xml)*.

The problem of identifying the right identifiers for data formats can be reduced to two fundamental rules of thumb:

1. reuse: don’t create new identifiers for things that already have one.

2. document: if you have to create an identifier describe its referent as open, clear, and detailled as possible to make it reusable.

If there happen to exist multiple identifiers for one thing, choose the one that is documented and adopted best. There will always be multiple identifiers for the same thing – don’t make it worse.

*Footnote: The identification of Internet Media Types with URIs that start with http://www.iana.org/assignments/media-types/ is neither widely used nor documented well but it’s the most official URI form that I could find. If for a particular format there is a better identifier – like an XML or RDF namespace – then you should use that, but if there is nothing but a Mime Type then there is no reason to create a new URI on your own.

Einführung in die Bibliometrie

16. April 2009 um 23:51 5 KommentareVor Kurzem hat Frank Havemann vom Institut für Bibliotheks- und Informationswissenschaft der HU Berlin eine umfassende Einführung in die Bibliometrie veröffentlicht. Das 66-seitige Werk steht unter der CC-BY Lizenz zur Verfügung, so dass es gut weiterentwickelt und für eigene Texte verwendet werden kann. Zur Einarbeitung ins Thema bietet sich zum Beispiel an, parallel zur Lektüre die entsprechenden Artikel in Wikipedia zu verbessern. Die Lizenz CC-BY ist mit der GFDL kompatibel, mit dem anstehenden Lizenzwechsel werden zusätzlich auch CC-BY-SA-Werke in Wikipedia übernommen werden können. Das bisher einzige deutschsprachige Einführungswerk zur Bibliometrie von Rafael Ball und Dirk Tunger ist übrigens auch online verfügbar. Warum keines der beiden Werke mit dem SWD-Schlagwort „Bibliometrie“ verknüpft ist, wird wohl ein Rätsel bleiben – vielleicht sollte man die Sacherschließung besser gleich ganz den Nutzern überlassen und dann mit bibliometrischen Verfahren untersuchen, was die Nutzer beim Social Tagging so treiben?

Bibliometrische Verfahren werden unter Anderem in der Wissenschaftsforschung und zur Evaluation von Forschungsleistungen eingesetzt. Natürlich ist es sehr fragwürdig, Qualität durch quantitative Verfahren messen zu wollen – um so wichtiger ist ein Verständnis für bibliometrische Methoden und Grundlagen, welches mit dem Einführungswerk vermittelt wird.

Disclaimer: Ich habe selber bei Frank Havemann studiert und meine Abschlussarbeit zu Bibliometrischen Untersuchungen an Wikipedia [PDF] geschrieben, was mein Urteil möglicherweise beeinflusst.

Mehr als Tauchcomputer: Computer Unterwasser

6. April 2009 um 12:34 2 KommentareWährend mit Notebooks und Netbooks Computer auf jeder Reise dabei sein können und man mit Smartphones selbst auf dem Klo twittern kann, sieht es unter Wasser noch eher düster aus. Abgesehen von Tauchcomputern mit begrenztem Funktionsumfang muss beim Tauchen auf Internet und GPS verzichtet werden. Alle die sich nun „was soll man auch unter Wasser mit einem Computer?“ fragen, brauchen ja nicht weiterzulesen, für die anderen hier die Ergebnisse einer kurzen Recherche zum Thema Tauchen und Computer:

Grundsätzlich vollzieht sich die Entwicklung wie anderswo: Nach ersten Anwendungen im militärischen Bereich und in der Forschung werden technische Entwicklungen auch von Privatleuten genutzt und weiterentwickelt. Die neueste Entwicklung ist Augmented Reality im Unterwasser-Einsatz: Das Fraunhofer-Institut für Angewandte Informationstechnik hat dazu gerade einen Prototypen vorgestellt. Beim Tauchen ist man praktisch schwerelos, weshalb die Simulation unter Wasser auch zum Standardtrainung von Astronauten gehört (um als Scuba-Diver ein Gefühl dafür zu bekommen, sollte man sehr gut austariert sein und dann mal seine Flossen ausziehen). Mit Augmented Reality sind daher Virtual Reality-Anwendungen denkbar, die nicht nur auf Stehen oder Sitzen beschränkt sind.

Tauchmasken wie die Oceanic Datamask HUD blenden bereits im Sichtfeld wichtige Informationen ein. Sehr interessant ist der Tauchcomputer von HeinrichsWeikamp: Die Software ist Open Source, kann selber angepasst und weiterentwickelt werden und es ist möglich, weitere Sensoren anzuschließen – hier ein Testbericht.

Das anscheinend am weitesten fortgeschrittene Gerät ist oder war der WetPC bzw. sein Nachfolger SeaPC – die Computer wurden vor einigen Jahren als Prototyp in Australien entwickelt – der aktuelle Stand des Projekt ist mir etwas unklar. Ich denke, dass auch mit dem zunehmenden Einsatz von Rebreathern wie dem INSPIRATION und dem Camelion Computer unter Wasser häufiger werden. Momentan steckt die Entwicklung aber eher noch in den Anfängen.

Bachelorarbeit zu Micro-Blogging

30. März 2009 um 13:23 3 KommentareSebastian Cario: „Potenziale von Micro-Blogging im Unternehmen – Analyse bisheriger Anwendungsbeispiele“ http://tinyurl.com/d2gltd #PMBUAA

nichtich. Nicht mehr in die 139 Zeichen passte die Informationen, dass die von mir an der FH Hannover betreute Bachelorarbeit einen sehr informativen und übersichtlichen Einblick in die Nutzungsmöglichkeiten von Micro-Publishing* gibt. Obgleich der Focus speziell auf dem Einsatz in Unternehmen liegt, gilt vieles davon auch für Informationseinrichtungen. Weitere Aspekte für Bibliotheken finden sich im Artikeln Better Practices From the Field: Micro-Blogging for Science & Technology Libraries, der allerdings schon ein Jahr alt ist, in der „Bonusrunde zu Twitter“ im Selbstlernkurs für Bibliothekare und Bibliothekarisch.de fragt Twittern – etwas für Bibliotheken? und im LIS-Wiki gibt es ein Liste von Microbloggendedn Bibliothekaren.

Für eine Masterarbeit hätte ich noch etwas mehr Querbezüge und Vergleiche erwartet, z.B. zu Instant Messaging und Chat, aber für eine Bachelorarbeit weiss ich nicht was besser gemacht werden könnte. Die Arbeit ist übrigens die erste Bachelorarbeit auf dem Dokumentenserver der FH Hannover – welcher wiederum der erste Dokumentenserver im Bereich Hannover ist.

*Der Begriff „Micro-Publishing“ beschreibt übrigens ebenso wie „Micro-Blogging“ nur einen Teilaspekt des Phänomens. Mir gefällt, dass herkömmliches „Micropublishing“ ja eigentlich die Publikation z.B. durch Kleinverlage für Nischemärkte als den im „Long Tail“ bezeichnet. Witzig ist zudem die Verwechslung mit Publikationen auf Mikroform: diese waren für die Wissenschaftskommunikation auch mal wichtig (siehe „Micropublishing: A History of Scholarly Micropublishing in America, 1938-1980“) und wurden fast wie heute Micro-Blogging als zukunftsweisend beschrieben ;-).

Zwei Artikel zu Hochschulbibliografien und zur WorldCat Policy im Bibliotheksdienst

22. März 2009 um 18:45 1 KommentarIn der März-Ausgabe des Bibliotheksdienst (Jahrgang 43/2009) ist ein Artikel zu Hochschulbibliografien erschienen, den ich zusammen mit Franziska Scherer an der Fachhochschule Hannover geschrieben haben: „Hochschulbibliografien an deutschen Hochschulen. Eine vergleichende Bestandsaufnahme„. Bei E-LIS habe ich eine Postprint-Version veröffentlicht, dort ist zusätzlich noch die Hochschulbibliografie der TU Darmstadt aufgeführt.

In der selben Ausgabe findet sich der Artikel „OCLC, WorldCat und die Metadaten-Kontroverse“ von Adrian Pohl (auch als Online-Version verfügbar). Adrian, der übrigens seit kurzem einen eigenen Blog betreibt, fasst darin übersichtlich die Kontroverse zur „Policy for Use and Transfer of WorldCat Records“ zusammen, so dass man sich nun auch auf Deutsch darüber gut einen Überblick verschaffen kann. Ich bin ja persönlich der Meinung, dass bibliographische Daten wie beispielsweise WorldCat frei sein sollten, die passenden Lizenzen gibt es bald oder jetzt schon. Wenn allerdings, wie Adrian ausführt, OCLC ein Drittel seiner Einnahmen durch Lizensierung der Daten und WorldCat-Dienste macht, kann ich auch verstehen, dass sie sich nicht gleich hinter freie bibliographische Daten stellen. Schade für OCLC.

Aktuelle Entwicklungen zu Freien Daten

18. März 2009 um 21:39 Keine KommentareFreie Software existiert als solche seit den 1980er Jahren (vorher war Software bis in die 1960er frei) und setzt sich im (Wind-)Schatten von Open Source Software immer mehr durch. Freie Inhalte gewinnen dank Creative Commons und Wikipedia ebenfalls seit Anfang des Jahrtausend an Bedeutung. Seit etwa zwei Jahren kommen nun auch vermehrt Freie Daten. Erst im Februar hat beispielsweise Web-Begründer Tim Berners Lee auf der TED-Konferenz mit der Forderung Raw Data Now! der Notwendigkeit von Freien Daten Nachdruck verliehen. Aus verschiedenen Gründen (andere Rechtsgrundlagen, Praktikabilität …) können Lizenzen für Freie Software und Freie Inhalte bei reinen Datensammlungen nicht so einfach angewandt werden. Deshalb wird zur Zeit im Projekt OpenDataCommons (ODC) von der Open Knowledge Foundation (OKF) an einer passenden Lizenz für Freie Daten gearbeitet. Weitere Informationen zu diesem Prozess gibt es bei OpenStretmap.

Für das freie Kartenprojekt und die OpenStreetMap Foundation besteht der größte Bedarf nach einer Lizenz, weshalb sie dankenswerterweise die Sache in die Hand genommen haben. Weitere Beteiligte sind unter Anderem die Autoren Jordan Hatcher und Charlotte Waelde, Creative Commons sowie Talis. Zur Diskussion steht momentan die “Open Database License“ (ODbL) zusammen mit der „Factual Information Licence“ (ODC-Factual). Zur Freigabe als Public Domain gibt es bislang schon die ODC Public Domain Dedication and Licence (PDDL) und seit kurzem von Creative Commons die CC Zero [via Netzpolitik].

Kommentare zur ODbL werden möglichst bis zum 20. März erbeten. Weitere Grundlagen und Vorarbeiten zu Lizenzen für Freie Daten gibt es von der OKF mit dem Guide to Open Data Licensing und bei Creative Commons bzw. Science Commons mit dem Protocol for Implementing Open Access Data. Die Privatisierungs-Mafia versucht übrigens derweil am demokratischen Prozess vorbei mit Geheimabsprachen an immateriellen Monopolrechten festzuhalten.

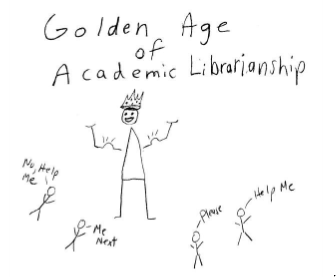

Provokative Thesen zur Zukunft der (Hochschul)bibliotheken

17. März 2009 um 15:31 2 KommentareDas Taiga Forum, ein Zusammenschluss von US-Hochschulbibliothekaren hat in Anschluss an sein viertes Treffen im Januar diesen Jahres zum zweiten Mal seit 2006 (PDF) eine Liste von „Provocative Statements“ (PDF) vorgelegt. Darin wird prophezeit, was sich in den nächsten Jahren in und für Bibliotheken ändert. Obgleich die Thesen teilweise etwas radikal überspitzt sind („Wir werden all störben!“)* und vor allem auf US-Hochschulbibliotheken zielen, treffen einige Punkte doch auch für Bibliotheken im Allgemeinen zu. Mir sind vor allem zwei Themenbereiche aufgefallen (Zusammenfassung subjektiv gefärbt):

1. Die eigene Bestände einer Bibliothek verlieren an Bedeutung, da die meisten Inhalte über das Netz bereitgestellt werden. Sammlung und Erwerbung spielt nur noch für Spezialbibliotheken und Archive eine Rolle (These 2, 4 und 7).

2. Bibliothekarische Dienstleistungen werden in immer geringerem Umfang angefragt, Fachreferenten als direkte Ansprechpartner für Informationssuchende werden weiter an Bedeutung verlieren – stattdessen sollten sich Bibliotheken mit ihren Dienstleistungen dort positionieren, wo die Dienstleistungen benötigt werden, d.h. dort wie der Nutzer schon ist – und das ist in den seltensten Fällen das Bibliotheksgebäude (These 4, 5, 6 und 8 )

Weitere Beispiele und Details zu den Thesen gibt es in den Lightning Talk Slides, aus denen ich auch die Zeichnung übernommen habe.

Obgleich sie inhaltlich richtig sind, halte ich 5 Jahre für etwas zu kurz für solche Prognosen – relevante Techniken wie Internet und mobile Endgeräte setzen sich zwar schnell durch, benötigen aber dennoch einige Jahre, bis sie im Alltag als Gegeben vorausgesetzt werden. Eine Übersetzung der Thesen von 2006 gibt es zusammen mit weiteren Gedanken dazu im Vortrag „Wer bewegt das Wissen? … in 10 Jahren“ (PDF), den Petra Hätscher auf dem Bibliothekstag 2008 gehalten hat.

* These 1: „each of us will evolve or die […] Librarians who cannot evolve will be reassigned or fired.“

Neueste Kommentare