Calls for participation: ISI und Bibliothekstag 2009

6. Oktober 2008 um 22:44 Keine KommentareNoch knapp zwei Wochen laufen die „Calls for participation“ zweier deutschsprachiger Bibliotheks- und Informationsveranstaltungen für das kommende Jahr [via Infobib u.A.]: Für den Bibliothekstag 2009 (2.-5. Juni 2009 in Erfurt) werden Beiträge bis zum 19.10. angenommen und für das 11. Internationale Symposium für Informationswissenschaft (ISI, 1.-3. April 2009, Konstanz) bis zum 17.10. Für Poster auf der ISI ist noch bis zum 5.11. und für studentische Arbeiten bis zum 15.11. Zeit. Wer auf der Suche nach eher wissenschaftlich und internationalen Konferenz ist, sollte in den International Calendar of Information Science Conferences der American Society for Information Science & Technology (ASIS&T) schauen. Die bei calendars.net verwalteten Einträge des Kalenders gibt es leider nicht direkt in einem standardisierten Format wie zum Beispiel hCalendar, aber aus dem RSS-Feed sollte sich etwas herausparsen lassen, um die Daten weiterzuverarbeiten (z.B. zum Übernehmen in eigene Kalender oder zur Darstellung in Google Maps oder mit SIMILE Timeline).

P.S: Außerdem findet am 14. November das InfoCamp Berlin statt – eine Unkonferenz zum Thema Informationsarchitektur!

„Digitale Bibliothek“ im WS 2008/09 an der FH Hannover

6. Oktober 2008 um 17:41 Keine KommentareAn der Fachhochschule Hannover gebe ich dieses Wintersemester zum zweiten Mal die Lehrveranstaltung „Digitale Bibliothek“ im 5. Semester des Bachelor-Studiengang Informationsmanagement. Die Folien werden wieder bei Slideshare und/oder bei scribd eingestellt und von diesem Beitrag aus nach und nach verlinkt. Hier der Semesterplan:

29.09.08 – Einführung

06.10.08 – Datenformate und Standards

13.10.08 – Schnittstellen und Webservices

20.10.08 – Semantic Web und Wissensorganisation

27.10.08 – Communities und Soziale Netzwerke

03.11.08 – Weblogs, Feeds und Syndication

10.11.08 – Formen und Bestandteile Digitaler Bibliotheken

17.11.08 – Empfehlungsdienste

24.11.08 – Mashups und Automatisierung

01.12.08 – Langzeitarchivierung

15.12.08 – Social Tagging und Indexierung

22.12.08 – Nutzer, Autoren und Werke im digitalen Raum

05.01.09 – Zusammenfassung und Ausblick

Bei den Aufgaben für die 38 Studenten hoffe ich, dass im besten Fall nicht nur gute Blogbeiträge sondern der eine oder andere Wikipedia-Artikel (oder die Verbesserung eines existierenden Artikels) für das Portal BID abfällt 🙂

Überreste der Wikipedia aus dem Januar 2001 entdeckt

2. Oktober 2008 um 02:22 2 KommentareAnlässlich des 10jährigen Jubiläums hat Google seinen ältesten Suchindex reanimiert, den es noch auftreiben konnte (abzüglich einiger Seiten, siehe FAQ) und zwar aus dem Januar 2001. Die meisten Seiten gibt es inzwischen nicht mehr, weshalb in so einem Fall auf das Internet Archive verlinkt wird – doch auch dort gibt es nur manche Ausschnitte. Der Januar 2001 ist auch der Geburtsmonat der Wikipedia: am 15. ging sie unter www.wikipedia.com online. Die ältesten Aufzeichnungen aus Wikipedia finden sich nicht im Internet Archive oder in Wikipedia selber, sondern im 2001er Index von Google, der 186 Seite gerettet hat. Im Eintrag zur Wikipedia selber (http://www.wikipedia.com/wiki.cgi?WikiPedia) heisst es:

WikiPedia is an encyclopedia project built using WikiWiki software by

WikiPedians for WikiWatchers. Who knows where it will go? …

Google hat vor, den Index nach einem Monat wieder abzuschalten. So wird auch diese Webpublikation der Vergessenheit anheim fallen anstatt für zukünftigen Generationen bewahrt zu werden. Who knows where it will go?

P.S.: Und noch ein Jubiläum eines Projekts, das die Welt verändert: 25 Jahre GNU

Digital libraries sleep away the web 2.0

1. Oktober 2008 um 23:58 3 KommentareFrome time to time still publish on paper, so I have to deposit the publication in a repository to make it (and its metadata) available; mostly I use the „open archive for Library and Information Science“ named E-LIS. But each time I get angry because uploading and describing a submission is so complicated – especially compared to popular commercial repositories like flickr, slideshare youtube and such. These web applications pay a lot attention to usability – which sadly is of low priority in many digital libraries.

I soon realized that E-LIS uses a very old version (2.13.1) of GNU EPrints – EPrints 3 is available since December 2006 and there have been many updates since then. To find out whether it is usual to run a repository with such an outdated software, I did a quick study. The Registry of Open Access Repositories (ROAR) should list all relevant public repositories that run with EPrints. With 30 lines of Perl I fetched the list (271 repositories), and queried each repository via OAI to find out the version number. Here the summarized result in short:

I soon realized that E-LIS uses a very old version (2.13.1) of GNU EPrints – EPrints 3 is available since December 2006 and there have been many updates since then. To find out whether it is usual to run a repository with such an outdated software, I did a quick study. The Registry of Open Access Repositories (ROAR) should list all relevant public repositories that run with EPrints. With 30 lines of Perl I fetched the list (271 repositories), and queried each repository via OAI to find out the version number. Here the summarized result in short:

76 x unknown (script failed to get or parse OAI response), 8 x 2.1, 18 x 2.2, 98 x 2.3, 58 x 3.0, 13 x 3.1

Of 195 repositories (that I could successfully query and determine the version number of) only 13 use the newest version 3.1 (released September 8th). Moreover 124 still use version 2.3 or older. EPrints 2.3 was released before the web 2.0 hype in 2005! One true point of this web 2.0 bla is the concept of „perpetual beta“: release early but often and follow user feedback, so your application will quickly improve. But most repository operators do not seem to have a real interest in improvement and in their users!

Ok, I know that managing and updating a repository server is work – I would not be the right guy for such a job – but then don’t wail over low acceptance or wonder why libraries have an antiquated image. For real progress one should perpetually do user studies and engage in the developement of your software. Digital libraries with less resources should at least join the Community and follow updates to keep up to date.

P.S: E-LIS has updated its software now (November 2008). A lot of missing features remain but those need to be implemented in EPrints first.

SuMa-eV Kongress 2008

30. September 2008 um 22:53 Keine KommentareLetzten Donnerstag fand in Berlin die 5. Tagung des SuMa-eV statt, Carl Meyer hat einen pointierten Bericht geschrieben. Preisträger des SuMa Award in der Sparte Musik war die Altpunker-Band „Die Betakteten“ mit dem „Lied vom Datenkraken„. Noch besser als das Lied ist fast die Aufführung in der Vertretung des Landes Niedersachsen beim Bund (sic!) – das hätte sich Sänger Micro zu seiner Zeit bei den Abstürzenden Brieftauben wohl eher nicht gedacht. Am 10. Oktober geht die Tour dann weiter zur Fachtagung für Datenschutzbeauftragte.

In die Pleite mit ungeplanten Medien-Mashups

29. September 2008 um 19:59 3 KommentareEine interessante Verkettung von Internetbasierten Medien hat am 8. September zu einem Verlust von mindestens 20 Millionen Dollar in 5 Minuten geführt. Für Banken sind das zwar im Moment sprichwörtliche „Peanuts“ (die ich gerne annehme), aber die Geschichte ist so bemerkenswert, dass ich die Details nachrecherchiert und hier zusammengefasst habe. Weitere Informationen gibt es unter Anderem im Artikel von James Erik Abels.

Am 10.12.2002 veröffentlichte die Zeitung Chicago Tribute einen Artikel über den damaligen Konkurs der Flugline United Airlines. Der Artikel erschien auch im Online-Portal South Florida Sun Sentinel, das zum Tribune gehört. Inzwischen ist United Airlines wieder – mehr schlecht als recht – im Geschäft und der Artikel war im Sentinel über das Archiv abrufbar – im Google Cache kann man sich noch ein Bild davon machen. Wegen des Sturms am Wochenende suchten anscheinend mehr Sentinel-Nutzer nach „United Airlines“ und stießen auf den Artikel, der – es war sonst wohl nix los – auf der Seite unter „Popular stories / most viewed“ auftauchte. Die dort verlinkten, durch die „Wisdom-of-the-Crowds“ ausgewählten Artikel werden nicht nur wiederum häufiger angeklickt sondern auch von Newsaggregatoren wie Google News eingesammelt. Die Agentur Income Securities Advisors Inc. bekommt den Artikel vom Newsaggregator über einen Suchalert und anstatt nochmal nachzurecherchieren schickt der betreffende Mitarbeiter eine Mitteilung an seine Kunden und an Bloomberg Terminal, das Informationsportal für Börsenhändler (die genaue Tickermeldung konnte ich nicht mehr ausfindig machen). Daraufhin werden UA-Aktien verkauft (durch Menschen oder Softwareprogramme, die den Ticker auswerten); als der Kurs fällt, verkaufen automatisch weitere Softwareprogramme und der Kurs stürzt bei einem Verkaufsvolumen von mehr als 20 Millionen $ von 12.45$ auf 3$ – bis der Handel ausgesetzt wird. Corey Rosenbloom hat in seinem Artikel eine Grafik ders Kursverlaufs.

Hm, das erinnert mich an Joseph Weizenbaums bereits 1976 erschienenes Buch „Die Macht der Computer und die Ohnmacht der Vernunft“. Irgendwo waren zwar noch Menschen beteiligt, aber die von ihnen geschaffenen Systeme (Online-Archive, Aggregatoren, Empfehlungs- und Alerting-Dienste, Börsenprogramme und – last-but-not-least – der alte „Schlawiner Kapitalismus“) beherrschen weitgehend das Geschehen. Ich habe die Geschichte in meiner Lehrveranstaltung verwendet, um verschiedene Informationsdienste zu illustrieren und auf die Bedeutung von Metadaten und Informationskompetenz hinzuweisen.

Eine eigene Darstellung der Geschehnisse von Sentitel vom 9.9. gibt es hier und ein passendes Video zur Bankenkrise gibt es von Extra 3.

Deutschsprachiges Buch zum Thema Social-Tagging

24. September 2008 um 17:53 1 Kommentar Das erste deutschsprachige Buch zum Thema Social-Tagging ist diese Woche im Waxmann Verlag erschienen: Birgit Gaiser, Thorsten Hampel, Stefanie Panke (Hrsg.): Good Tags – Bad Tags. Social Tagging in der Wissensorganisation. 240 Seiten, 29,90 EUR, ISBN 978-3-8309-2039-7. Das im Anschluss an den Workshop „Social Tagging in der Wissensorganisation“ (siehe PDF) am Institut für Wissensmedien am 21. und 22. Februar 2008 entstandene Sammelwerk kann auch als PDF heruntergeladen werden. Hier das Inhaltsverzeichnis (auch als PDF):

Das erste deutschsprachige Buch zum Thema Social-Tagging ist diese Woche im Waxmann Verlag erschienen: Birgit Gaiser, Thorsten Hampel, Stefanie Panke (Hrsg.): Good Tags – Bad Tags. Social Tagging in der Wissensorganisation. 240 Seiten, 29,90 EUR, ISBN 978-3-8309-2039-7. Das im Anschluss an den Workshop „Social Tagging in der Wissensorganisation“ (siehe PDF) am Institut für Wissensmedien am 21. und 22. Februar 2008 entstandene Sammelwerk kann auch als PDF heruntergeladen werden. Hier das Inhaltsverzeichnis (auch als PDF):

Einleitung

- Thomas Vander Wal: Welcome to the Matrix! (S. 7-9)

- Birgit Gaiser, Thorsten Hampel, Stefanie Panke: Vorwort (S. 11-14)

- Matthias Müller-Prove: Modell und Anwendungsperspektive des Social Tagging (S. 15-22)

Teil 1: Theoretische Ansätze und empirische Untersuchungen

- Stefanie Panke, Birgit Gaiser: „With my head up in the clouds“ – Social Tagging aus Nutzersicht (S. 23-36)

- Christoph Held, Ulrike Cress: Social Tagging aus kognitionspsychologischer Sicht (S. 37-50)

- Michael Derntl, Thorsten Hampel, Renate Motschnig, Tomáš Pitner: Social Tagging und Inclusive Universal Access (S. 51-62)

Teil 2: Einsatz von Tagging in Hochschulen und Bibliotheken

- Christian Hänger: Good tags or bad tags? Tagging im Kontext der bibliothekarischen Sacherschließung (S. 63-72)

- Mandy Schiefner: Social Tagging in der universitären Lehre (S. 73-84)

- Michael Blank, Thomas Bopp, Thorsten Hampel, Jonas Schulte: Social Tagging = Soziale Suche? (S. 85-98)

- Andreas Harrer, Steffen Lohmann: Potenziale von Tagging als partizipative Methode für Lehrportale und E-Learning-Kurse (S. 97-106)

- Harald Sack, Jörg Waitelonis: Zeitbezogene kollaborative Annotation zur Verbesserung der inhaltsbasierten Videosuche (S. 107-118)

Teil 3: Kommerzielle Anwendungen von Tagging

- Karl Tschetschonig, Roland Ladengruber, Thorsten Hampel, Jonas Schulte: Kollaborative Tagging-Systeme im Electronic Commerce (S. 119-130)

- Tilman Küchler, Jan M. Pawlowski, Volker Zimmermann: Social Tagging and Open Content: A Concept for the Future of E-Learning and Knowledge Management? (S. 131-140)

- Stephan Schillerwein: Der ‚Business Case‘ für die Nutzung von Social Tagging in Intranets und internen Informationssystemen (S. 141-152)

Teil 4: Tagging im Semantic Web

- Benjamin Birkenhake: Semantic Weblog. Erfahrungen vom Bloggen mit Tags und Ontologien (S. 153-162)

- Simone Braun, Andreas Schmidt, Andreas Walter, Valentin Zacharias: Von Tags zu semantischen Beziehungen: kollaborative Ontologiereifung (S. 163-174)

- Jakob Voß: Vom Social Tagging zum Semantic Tagging (S. 175-186)

- Georg Güntner, Rolf Sint, Rupert Westenthaler: Ein Ansatz zur Unterstützung traditioneller Klassifikation durch Social Tagging (S. 187-200)

- Viktoria Pammer, Tobias Ley, Stefanie Lindstaedt: tagr: Unterstützung in kollaborativen Tagging-Umgebungen durch Semantische und Assoziative Netzwerke (S. 201-210)

- Matthias Quasthoff, Harald Sack, Christoph Meinel: Nutzerfreundliche Internet-Sicherheit durch tag-basierte Zugriffskontrolle (S. 211-222)

Das bisher einzige Buch zum Thema war Tagging: people-powered metadata for the social web von Gene Smith (2008, ISBN 0-321-52917-0).

Dublin Core conference 2008 started

23. September 2008 um 12:20 4 KommentareYesterday the Dublin Core Conference 2008 (DC 2008) started in Berlin. The first day I spent with several Dublin Core Tutorials and with running after my bag, which I had forgotten in the train. Luckily the train ended in Berlin so I only had to get to the other part of the town to recover it! The rest of the day I visited the DC-Tutorials by Pete Johnston and Marcia Zeng (slides are online as PDF). The tutorials were right but somehow lost a bit between theory and practise (see Paul’s comment) – I cannot tell details but there must be a way to better explain and summarize Dublin Core in short. The problem may be in a fuzzy definition of Dublin Core. To my taste there are far to many „cans“, „shoulds“, and „mays“ instead of formal „musts“. I would also stress more the importance of publicating stable URIs for everything and using syntax schemas.

What really annoys me on DC is the low committement of the Dublin Core Community to RDF. RDF is not propagated as fbase but only as one possible way to encode Dublin Core. The same way you could have argued in the early 1990s that HTTP/HTML is just one framework to build on. That’s right, and of course RDF is not the final answer to metadata issues – but it’s the state-of-the-art to encode structured data on the web. I wonder when the Dublin Core Community lost tight connection with the W3C/RDF community (which on her part was spoiled by the XML community). In official talks you don’t hear this hidden stories of the antipathies and self-interests in standardization.

The first keynote that I heard at day 2 was given by Jennifer Trant about results of steve.museum – one of the best projects that analyzes tagging in real world environments. Data, software and publications are available to build upon. The second talk – „Encoding Application Profiles in a Computational Model of the Crosswalk“ by Carol Jean Godby (PDF-slides) – was interesting as well. In our library service center we deal a lot with translations (aka mappings, crosswalks etc.) between metadata formats, so the crosswalk web service by OCLC and its description language may be of large use – if it is proberly documented and supported. After this talk Maria Elisabete Catarino reported with „Relating Folksonomies with Dublin Core“ (PDF-slides) from a study on the purposes and usage of social tagging and whether/how tags could be encoded by DC terms.

At Friday we will hold a first Seminar on User Generated Matadata with OpenStreetmap, Wikipedia, BibSonomy and The Open Library – looking forward to it!

P.S: Pete Johnston’s slides on DC basic concepts are now also available at slideshare [via his blog]

Insight into the Digital Library Reference Model

18. September 2008 um 18:31 2 KommentareOn the first post-ECDL-conference day I participated in the Third Workshop on Foundation of Digital Libraries (DLFoundations 2008) that was organized by the DELOS Network of Excellence on Digital Libraries. One major work of DELOS is the DELOS Digital Library Reference Model (DLRM). The DLRM is an abstract model to describe digital libraries; it can be compared to the CIDOC Conceptual Reference Model (CIDOC-CRM) and the Functional Requirements for Bibliographic Records (FRBR) – and it shares some of their problems: a lack of availability and (resulting) a lack of implementations.

The DLRM is „defined“ in a 213-page PDF-file – this is just not usable! Have a look at W3C or IETF how nowadays standards are defined. As DLRM is a conceptual model, you must also provide a RDF representation or it is just inavailable for serious applications on the web. And of course the silly copyright statement should be removed in favor of a CC-license. That’s the formal part. Summarizing the content of DLRM there are 218 concepts and 52 relations – which is far too much to start with. But: there are some really useful ideas behind DLRM.

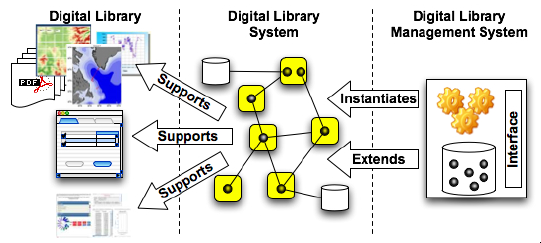

The reference model includes a division of „digital library“ into three levels of conceptualization (see image): first the visible digital library (the collection that users work with), second the digital library system (the software application that is installed and configured to run a digital library), and third the digital library management system (the software system that supports the production and administration of digital libraries). This division can be helpful to understand and talk about digital libraries – although I am not sure whether the division between digital library systems and digital library management systems is a such a good one.

Beside general talks about the Digital Library Reference Model the workshop provided some experience from practise by Wolfram Hostmann (DRIVER project) and by Georg Eckes (Deutsches Filminstitut) – never underestimate good real world examples! The most refreshing talk was given by Joan Lippincott (Coalition of Networked Information). She pointed out that much more then traditional repositories can be viewed as digital libraries. Especially user-generated content can constitute a digital library. A useful model for digital libraries should also fit for collections at Flickr, YouTube, Wikis, Weblogs etc. and user can mash up resources to create new digital library services, for instance the species search engine iSpecies. She is sooo right! In addition Joan mentioned initiatives to broaden the use of authority files and identity management. Another direct hit! If digital libraries only focus on interoperability with other „official“ digital libraries they will not remain. Libraries are only one little player in the digital knowledge environment and their infrastructure is not defined only by them.

I enjoyed the workshop, I really like the digital library community and I am happy to be part of it. But some parts still seem to live in an ivory tower. If the digital library reference model does not quickly get adopted to real applications (both repositories like those build with DSpace, Fedora, EPrints etc. and open systems like YouTube, Wikipedia, Slideshare…), it is nothing but an interesting idea. The digital revolution is taking place anyway, so let’s better be part of it!

P.S: The slides will soon be available at the Workshop’s website.

Some ECDL highlights

17. September 2008 um 22:01 1 KommentarThe main ECDL 2008 program ended today and I will try to quickly summarize some highlights that I catched from the poster session. I participated with a poster on Dynamic Catalogue Enrichment with SeeAlso Link Servers (self-archived at E-LIS, abstract also as DOI 10.1007/978-3-540-87599-4_62).

First I talked with Magnus Pfeffer und Kai Eckert (University Mannheim, see photo). Kai developed a tool called Semtinel to visualize thesauri and classifications, and their usage for indexing a particular collection. He also published a paper (Semtinel: Interactive Supervision of Automatic Indexing, see PDF) at the JCDL’08 and gave a presentation at the Bibliothestag 2008. Displaying a hierarchical knowledge organization system and its usage in a treemap seems to be a simple idea, but it looks like nobody has done it before. If Semtinel becomes OpenSource and reads SKOS, this will be a useful tool for every „ontology engineer“ (that’s what „thesaurus managers“ are called now, as Dagobert Soergel remarked in his tutorial).

First I talked with Magnus Pfeffer und Kai Eckert (University Mannheim, see photo). Kai developed a tool called Semtinel to visualize thesauri and classifications, and their usage for indexing a particular collection. He also published a paper (Semtinel: Interactive Supervision of Automatic Indexing, see PDF) at the JCDL’08 and gave a presentation at the Bibliothestag 2008. Displaying a hierarchical knowledge organization system and its usage in a treemap seems to be a simple idea, but it looks like nobody has done it before. If Semtinel becomes OpenSource and reads SKOS, this will be a useful tool for every „ontology engineer“ (that’s what „thesaurus managers“ are called now, as Dagobert Soergel remarked in his tutorial).

Unfortunately I missed the demo Using Terminology Web Services for the Archaeological Domain about an SKOS terminology webservice developed at the university of Glamorgan. Reminds me at the German terminology registry Museumsvokabular.de. I also liked the demo of DIGMAP, a set of services to enrich maps in libraries with geographical information and to mash them up with Google Maps. The best ECDL demo award was choosen democratically by all participants. It went to the Preservation Planning Tool Plato and to the search engine Summa.

I had some time to glimpse the nice „little“ city of Århus (2nd largest of Denmark with 300.000) and I liked it a lot. The ECDL 2009 will take place at Corfu which is a bit warmer (last year I visited it for the MTSR 2007) – see you next year at ECDL or another digital library related conference!

Neueste Kommentare